I somras köpte jag flera böcker, som jag tyvärr inte ännu haft tid att läsa fullt ut. Boken som illustreras ovan (300 sidor – finns på amazon.com i USA, ca 70 USD) visar sig innehålla mycket tänkvärda synpunkter och sammanbinder vitt skilda skeenden inom ekonomi, fysik, biologi, och också klimatvetenskap. Den är inte helt enkel – men kan ändå läsas med behållning av icke-specialister. Dessutom innehåller den mängder med högintressant vetenskapshistorisk information, som iallafall inte jag kände till.

Den amerikanska redaktörssammanfattningen beskriver det väsentliga bra:

This book provides a lens through which modern society is shown to depend on complex networks for its stability. One way to achieve this understanding is through the development of a new kind of science, one that is not explicitly dependent on the traditional disciplines of biology, economics, physics, sociology and so on; a science of networks. This text reviews, in non-mathematical language, what we know about the development of science in the twenty-first century and how that knowledge influences our world. In addition, it distinguishes the two-tiered science of the twentieth century, based on experiment and theory (data and knowledge) from the three-tiered science of experiment, computation and theory (data, information and knowledge) of the twenty-first century in everything from psychophysics to climate change.

This book is unique in that it addresses two parallel lines of argument. The first line is general and intended for a lay audience, but one that is scientifically sophisticated, explaining how the paradigm of science has been changed to accommodate the computer and large-scale computation. The second line of argument addresses what some consider the seminal scientific problem of climate change. The authors show how a misunderstanding of the change in the scientific paradigm has led to a misunderstanding of complex phenomena in general, and the causes of global warming in particular.

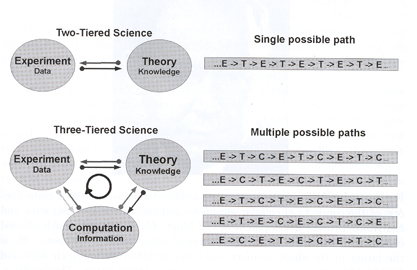

En figur ur boken visar på ett tänkvärt sätt hur klassisk experimentell vetenskap har förändrats, i och med införandet av datorsimuleringar för att möjliggöra en hoplänkning av ”teori” och ”experiment” för mer komplexa system.

Sökandet av relationer mellan ”experiment (E)” (borde egentligen kallas ”observationer”, tycker jag) och ”teori (T)” tar numera ofta vägen över ”computations (C)”, och dessa tre kan göras i olika följd – någon av dessa är bättre än andra – men det vet man inte från början.

Författarna argumenterar runt det mest väsentliga – för komplexa system får man inte heller längre ett entydigt svar när man varierar någon ingångsparameter, vilket lätt kan leda till felaktiga slutsatser. Boken avslutas med resonemang runt ”klimatfrågan” – jag har inte hunnit dit ännu.

Någon känner kanske igen författarnamnen Bruce J. West och Nicola Scafetta. I 2008 års Physics Today skrev de en artikel benämnd ”Is climate sensitive to Solar variability?”. Den rörde om i grytan ordentligt, och givetvis kastade sig bl.a. RC-gänget över dessa hädare. I denna bok utvidgar de resonemangen på ett högst trovärdigt sätt.

Professor emeritus i Fysikalisk Kemi vid KTH. Klimatdebattör sedan 2003.

Intressant bok Peter S!

Den skall jag omedelbart beställa. Den trevägs kommunikation som beskrivs har en massa implikationer. Modellernas blandning av egenskaper och faktorer allt från exellenta till totalt osäkra gör att vi inte har förmågan att utvärdera komplexa modellers riktighet och relevans. Även om vi blir bättre och bättre på utvärdering så springer uvecklingen mot allt mer komplexa modeller mycket fortare än användarnas förmåga att utvärdera dem.

Klimatvetenskapens slutsatser baserade på modellkörningar har lämnat all sans och relevans.De har blivit de förutfattade meningarns springpojke.Många publicerade artiklar har helt fel slutsaser på grund av att de inte förstått att de inte studerat klimatet utan istället gjort en studie av hur modellen räknar vilket är två helt åtskilda saker.

Hur man får stopp på missbruket har jag ingen aning om.Det kan vara ett suveränt verktyg att jobba med men extremt få behärskar verktyget. Tillämpar man Scott Armstrongs kvalitets index för prognostiserande modeller så har man kommit en bra bit på vägen.

Inom klimatvetenskapen skulle det innebära en katastrof för klimahotsånglarna för i princip alla co2 hotande modeller skulle hamna i papperskorgen eftersom de inte uppfyller ens de grundläggande kriterierna för att ens slå slumpen i utfall.

Användarna måste gå en gedigen grundutbildning i modellkunskap för att de skall kunna använda dem på relevant sätt.För nu är det ”hela havet stormar” som gäller.

Det största problemet med modeller är att modellens ”korrekthet” aldrig kan fastställas. Även om en forskare eller annan person använder sig av valfritt av de väldigt många anpassningsmått som finns, så kommer dessa anpassningsmått aldrig att ge någon garanti för att det inte finns ett oändligt antal modeller som bättre beskriver det modellerade fenomenet.

Personligen så är jag övertygad om att klimathysterikerna finns i tre slag. De bibeltroende som köper allt som kallas grönt utan att ifrågasätta något. De som tror på gröna jobb, kolväteoberoende och de som försöker snyta åt sig alla pengar de kan komma över.

Väldigt många tror att pengar kommer att bli viktigare då Obama regimen (som enligt klimat-troende, ska vara 100% förbehållningslöst för klimatet, bara det är grönmålat) troligtvis får lämna över taktpinnen i nästa val. Varför alla gröna måste plocka åt sig så mycket pengar som möjligt för att inte försmäkta under nästa regim. Vilket är ungefär vad som predikas på internetforum, runt om i Svea rike idag. Ifrågasätter man relevansen och vettet börjar de prata om G.Bush och säger att Obama ska fixa problemen, men glömmer att G.Bush faktiskt satsade en del på det gröna i termer av jobbskapande, etanol exempelvis.

ANNONym xxx # 2 : För att ”klimatforskarna” skall kunna tillmätas trovärdighet måste de skrota sina modeller och övergå till observationer, demonstrationer och experiment och sluta att mata in ”garbage” i sina modeller för det ger bara ”garbage” ut. För övrigt anser jag att koldioxidens klimatpåverkan är betydligt överdriven. Mvh, Håkan.

Det kommer aldrig att ske, du Håkan.

Det bara att titta på granskningarna av climategate, finn fem fel. Å andra sidan var det någon på ett av ställena som sa ”vi kan inte kritisera xxx för han har lurat till sig så mycket pengar”.

Experiment är för övrigt mindre vetenskapliga än modeller med undantag av evidensen i replikerbarheten.

Mycket intressant Peter!

Boken tycks ju beröra ett av grundproblemen med klimatvetenskapen och framförallt i kommunikationen av den. Om vi bortser ifrån miljöreligionen och behovet av politisk korrekthet (vilket förstås är svårt) så är det just den absurda övertron på i princip otestade modeller som kännetecknar vetenskapen och debatten.

Precis som #1 påpekar så har tilltron till modellerna lämnat all sans och relevans. Modeller av komplicerade system som inte noggrant har kunnat testas på data med parametervärden i de områden som man önskar modellera har normalt liten förutsägande förmåga! Även om har full koll på 150 av de 151 ingående parametrarna så räcker en liten miss i den 151:a parametern för att förutsägelserna ska bli helt fel (brukar generera ett javisst ja!). Omvändelsen gäller dock normalt dvs. har man lyckats modellera verkliga system som har kunnat mätas med relevanta parametervärden (i det här fallet hög koldioxidhalt) så finns det en god chans att man har rätt. Jag skriver en del om detta på min blogg (och exemplifierar) men skriver också om en roande skriftväxling med SMHI (se http://jorsater.se/klimatet/?p=70) som belyser problemet.

SMHI litar intressant nog inte bara blint på de storskaliga modellerna utan även på att klimatet i Sverige kan förutsägas på detaljnivå (läs länsnivå). Jag hittade det roande exemplet på deras egen webb att SMHI påstår att det är en förhöjd sannolikhet på Gotland under 2030 talet(!) att temperaturen faller där under hela decenniet men inte på en del andra ställen i Sverige.

Det här är naturligtvis ren hokus pokus. OM man överhuvudtaget kan säga något så är det en en punkt om hundra år och en punkt idag och en rät linje däremellan – allt annat är som att försöka förutspå högkonjunkturer på 2090 talet.

Tyvärr är det mycket svårt att övertyga allmänheten om det osannolika i dribblandet mellan modeller och verkligheter när inte ens proffsen klarar det.

Dessutom finns det förstås bara ett bra sätt att testa modellerna – kör dem baklänges och reproducera 1900-talet, 1800-talet, Lilla istiden osv. Men det haverar fullständigt och redan under 1900 talet måste man ta till helt fria parametrar för att klara sig. Men framtiden kan man förstås förutspå – där kan ju inga fria parametrar ställa till det. Eller?

Bokens tema är såpass viktigt så att vi borde överväga och samla en liten intresserad grupp kring boken eller dess tema och diskutera och exemplifiera. Här känns det nämligen som vi berör ett rent systemfel i vetenskapen.

Steven Jörsäter

Fyra ynkliga kommentarer!!! 🙂

Modeller är tydligen svårt? En mycket bra grundanalys om varför klimatmodellerna inte kan användas till prognoser. Han beskriver med ganska enkel terminologi vari klimatmodellerna brister.En bra introduktion för dem som tror att det är för svårt att förstå vad de förväntas åstakomma. Scott Armstrongs enkla modell har slagit Gore och IPCC 20 månader av 27 möjliga.

http://www.theclimatebet.com/?p=376#more-376

Jag klistrar in den på den senaste tråden också.

Att använda datamodeller för framtida klimathändelser är omöjligt,

modeller är bara en bekväm sett att få fram statistik till politiker mm.

Datamodeller tar man fram för att få fram scenarios en möjlig utveckling

av klimat,gäller även ekonomiska modeller det är populärt idag,för att

få anslag till kraftigare datorer att leka med,med förklaringen att få än

bättre modeller,detta går politiker på,och ger mer anslag.

ALI.K.

Kanske någon noterat att det finns stora möjligheter till (själv)bedrägeri när man sammanlänkar Observationer-Teori-Beräkningar på ett cirkulärt sätt, som i figuren ovan.

Cirkelresonemang brukar det heta.

Steven Jörsäter #5 – Du skriver ”Dessutom finns det förstås bara ett bra sätt att testa modellerna – kör dem baklänges och reproducera 1900-talet, 1800-talet, Lilla istiden osv. Men det haverar fullständigt och redan under 1900 talet måste man ta till helt fria parametrar för att klara sig. Men framtiden kan man förstås förutspå – där kan ju inga fria parametrar ställa till det. Eller?”

Vad jag förstår så är det omöjligt att köra modellerna baklänges – av matematiska skäl divergerar de omedelbart – det finner man också för mycket enklare simuleringar, som att söka modellera diffusion (slumpmässig molekyltransport) tillbaka i tiden – trots att den beskrivs av en enkla differentialekvationer.

Vad man kan göra är att utgå från någon känd vädersituation i det förgångna, om man kan leta upp trovärdiga och rimligt kompletta sådana data, och söka simulera sig framåt i tiden.

(Papperskorgen blir nog välfylld.)

Peter Stilbs, nog borde klimatmodeller gå att starta med kända värden ex. 1910, så köra fram till 2010,, var det inte så Steven menar?

Har de inte gjort det?

Självklart är alla klimatmodeller byggda så… med hockeyklubban som start och referens…

Men det finns många programmerare som byggt klimatmodeller som passar perfekt mot vilka framfantiserade grafer som helst på den globala medeltemperaturen.

Men ge någon en objektiv datamängd från ex. 1800-1900, så utifrån det skapa de korrekta data från 1900-2000 utan att först se dem… då har vi en kandidat (eller fuskare).

Det borde alla klimatforskare med åtminstone normalbegåvning veta.

Sorry jag borde läst klart, just så avslutade Peter…

Det blir problem med klimatmodeller som på minsta vis använder medeltemperatur… som att spå när nästa storm kommer med data på de sista hundra årens medelvindhastighet var månad, om så det är ett mönster över hela jorden… med medelvindhastigeter, var sekund skulle däremot ge bättre chans… ty vindkraft ökar bara med kvadraten på vindhastigheten.

Till Gunnar Littmarck:

Medeltemperaturerna är inte korrekta. Egentligen borde alla sådana medeltemperaturer beskrivas av intervall snarare än parametrar. Å andra sidan, även om man tar Klimatalarmisternas egna modeller med deras egna data och använder sig av sida två i läroböckerna så kommer man till slutsatsen att uppvärmningen av världen är insignifikant eller att chansen att det verkligen är en uppvärmning är av storleksordningen någon halv procent. Å andra sidan finns det många sätt att vrida på modeller och statistik, data är nog den mest relevanta delen att studera, men detta tillåts ju inte…..

När det sedan gäller dessa modeller så har de ursprungligen införts av politiska skäl, som en kritik mot ekonomer och deras tidsserieanalyser, men där finns en syfterskillnad, ekonomerna pysslar med pengar och inte policies. Ekonomerna bär alltid ansvaret för pengarna och medan policymakers uppenbarligen inte vill ta ansvaret för policyn, utan tror att det ligger på modellerna.

Du har förstås rätt Peter #9. Tack för påpekandet!

Det var helt enkelt feltänkt av mig. Ett mycket enkelt och pedagogiskt exempel varför det inte går finns här:

http://wmbriggs.com/blog/?p=2067&cpage=1#comment-15951

(Alltid bra att slippa blanda in mystik kring andra huvudsatsen…)

Mycket annat intressant om modeller finns på den bloggen.

Men man kan förstås göra som du skrev – att utgå ifrån en situation i det förgånga och gå framåt och detta kan göras i många steg. Hursomhelst, rädslan för Lilla Istiden och den medeltida värmeperioden är lätt att förstå. Det finns ju ingenting (känt eller erkänt) som har orsakat dem. Enda återstående förklaringen är alltså instabiliteter i klimatsystemet men det vill man för allt i världen inte erkänna eftersom de kan ju faktiskt spela in också idag…

Till ALI.K: Det finns många olika behov av superdatorer, ett klassiskt och korrektbehov är att man helt enkelt vill använda sig av äldre exakta metoder för att beräkna vissa saker exakt. Det är inte helt ovanligt än idag att vanliga pc-servrar med 256Gb RAM inte räcker till.

Däremot är jag av samma uppfattning som dig, när det gäller policymakers, behöver de en superdator är det enbart för att lura allmänheten att inte studera deras förehavanden och beslut närmare. Som en jämförelse kan man säga att alla ekonomiska beslut som tas i Sverige kan simuleras på en 5 år gammal server om man har lust och då kan varenda svensk vara med i simuleringen så visst är det många som luras, sedan finns förstås inkompetensbiten med i spelet och då handlar det om att de inte vet vad de håller på med och dessutom inte vill att någon annan ska veta att de inte vet vad de håller på med. Ett sätt att smita från sin egen inkompetens, helt enkelt.

#13 sammanfattar situationen bra.

Men hur kan vi ändra våra system så inte idioter får fatta avgörande beslut för andra än dem själva?

Jag anser att vi måste få fram ett system där beslutsunderlaget utformas på kanske mest obekväma vis.

Alla gillar Lex Sara, men om vi med det ska gynna de som visar brister och svagheter, måste vi implementera det i hela samhället, motvallskärringar måste uppvärderas (jag ansåg på ett tidigt stadium att Thomas i den rollen tillför något värdefullt på denna blogg)

Skolan måste revideras totalt, elever ska nå nästa nivå genom att finna fel i undervisning och studiematerial, aldrig betyg, bara högre nivåer… där all tidigare inlärd kunskap ständigt krävs.

Universitet och högskolor måste befrias från politisk inblandning. (bara det skulle kräva flera dagars skriverier… men jag har en grov modell).

Slutligen måste alla underlag för politiska beslut öppet ifrågasättas, som en sund vetenskaplig process, maximalt ska hypoteser kritiseras, de som står pall kan sedan gå vidare, men fortfarande alltid ifrågasättas..

Tänk på de sista 50 årens resursanvändning i Sverige efter politiska sanningar som aldrig utsatts för prövning, tänk hur dikeskörningarna skulle minskat helt om alltid alla ”sanningar” utsattes för maximal prövning?

Problemet har funnits i hela mänsklighetens historia, men det är ingen ursäkt för att inte åtgärda det.

Slabadang #6,

Tack för din länk. En guldgruva. Särskilt intressant verkar ju följande vara om den gröna rörelsens alla domedagsprofetior:

http://kestencgreen.com/green&armstrong-agw-analogies.pdf

”Based on an analysis of these 26 similar alarms with known outcomes, we found that none were based on forecasts derived from scientific forecasting procedures, and all were false alarms. Government actions were sought in 96% of the cases and, in the 92% of cases where government action was taken, the actions caused harm in 87%.”

”Based on our structured analogies study, we forecast that the global warming movement will be found to have been raising false alarms, and that the negative effects of the movement will continue to be felt for many years.”

forts på #17,

Armstrong talar om ”scientific forcasting procedures” och jag antar att det då handlar om de 89 principer som han menar att goda förutsägelser skall uppfylla. Utan att ha studerat dem i detalj så verkar de vettiga. Men av grundläggande skäl (induktionsproblemet) så kan de inte ge några garantier för sanning, ens inom en kvantifierbar felmarginal.

Dock: eftersom det handlar om praktiskt beslutsfattande så måste vi handla (där icke-handling är ett alternativ) ändå. Och då kan man argumentera för att det är bättre att handla i enlighet med hans principer än att inte göra det. Å andra sidan måste man som filosof fråga sig om Amstrong har gjort detta, och om han möjligen också utvärderat sina 89 principer. Någon som känner till om han gjort något sådan principellt arbete?

Ingemar!

Att utvärdera modeller i efterhand är ett litet helvete.Att konstatera att modellerna inte klarar sin tänkta uppgift är ganska lätt.Tyvärr tar det ofta tid innan man kan konstatera det.

Armstrongs metod är ett systematiskt reglemente för hur du uppnår kvalitativ tillförlitlighet med 89 ”checkpoints” längs vägen.

Du kan aldrig uppnå 100% tillförlitlighet men ofta räcker det att modellen är bättre än slumpen.Många aktietrading/förvaltning system slår inte ens slumpen men väl index med någon tiondels procent och blir därigenom bättre än konkurrenterna och det räcker för att skapa ett mervärde för användaren.

Klimatmodeller måste leverera med mycket högre krav på tillförlitlighet i en dessutom otroligt mycket mer komplex verklighet.

Om du har några enstaka riktigt robusta samband i ”botten” på modellen så har du något att bygga vidare ifrån.

I klimatmodellerna så blandas förmågan att återge de fysiskaliska förloppen som härstammar från vädermodeller ihop med förmågan att prognostisera dem.Alltså sannolikheten för att de fysikaliska förloppen skall ändras åt ena eller andra hållet. Så modellerna kan ge ett hyfsat bra svar på VAD som händer men inte OM NÄR VARFÖR eller hur mycket.

I centrum för intresset för klimatmodellerna står deras förmåga att beskriva och prognostisera sambandet mellan global temperatur och CO2 halt.Hur många miljoner veenskapsmän som än ställer sig bakom i ”konsensus” så är det bara en hypotes med ett isolerat samband mellan CO2 och ökad absorbtion av värmestrålning.

Hypotesen måste kunna prövas och man har valt att med skohorn trycka in CO2 som förklaring till den 0.7 C ökningen sedan 1850 trots att man är mycket medveten om att hypotesen är som ett blött dasspapper att lägga till grund för prognoserna eftersom hypotesen faller i så många både korta och långa tidsperspektiv.Korrelationen är helt enkelt usel.Att uppvärmningen pågått se LIA med uppvärmningperioder där emellan som strider mot hypotesen skiter ma helt enkelt i den sista femtonåriga temperatur platån likaså.

När dessutom ingen ”hotspot” kan skönjas över tropikerna och Max Plank institutet finner att det antagna sambandet mellan värme och luftfuktighet genom observationer inte stämmer överens med modellerna så faller de platt.

Vad är det som säger att förändringen av den globala temperaturen till 99% inte är en spegel av förändringar i molntäcket?

På vilka statistiskt anständiga grunder har man sorterat ut världstemperaturen de sista 150 åren som ”onaturliga” och beroende av CO2?

Vi har klimatmodellerare som brandgult tydligt ägnar sig åt ”curvfitting” och använder modellerna som språkrör för sina egn högst partiska antaganden från lösan grund.Alla bevisen för att klimatmodellerns förmåga att prognostisera framtida klimat är lika med noll ligger redan på bordet.Att låtsas att så inte är fallet är en allt mer försvinnande möjlighet.Lennart Bengtsson uttrycker detta på ett diplomatiskt sätt. Jag tycker iofs inte att modellerna i sig är problemet utan ser användarnas slutsatser ifrån dem som det riktigt gigantiska problemet.

När kostnaderna för taskiga prognoser blir kopplade till ett meföljande ansvar händer det saker.Att som AGWprofet göra en totalt tokig orkanprognos kostatde floridaborna 82 Mdr $

Jag gissar att han numer bor på hemlig adress och har ett kompani av delgivningsmän efter sig? 🙂

Att hitta en modell som påvisar riskerna och kostnaderna för dåliga politiska beslut tagna på beslutsunderlag från taskig vetenskap är betydligt viktigare.Den uppföljningen är värd många miljarder i vetenskapligt bidrag.Miljöeffekter kontra kostnader är ett effektivitetsmått politiker springer kilometer för att slippa se.

Att bygga modeller helt frånkopplat från Scott Armstrongs processer ä att bygga lutande tornet i Pisa!

På tal om curvfitting!

Så går ju AGWkyrkan ett steg längre,De curvfittar hela kedjan.

http://wattsupwiththat.com/2010/11/16/in-climate-world-up-is-down/

Vad säger klimatmodellerna?

http://www.climate4you.com/images/HadCRUT3%20and%20TropicalCloudCoverISCCP.gif

Hmmmm?

Slabadang # 19 : Att bygga sina förutsägelser om framtida klimat på den obekräftade gissningen att CO2 kan påverka klimatet är som att bygga en skyskrapa på pålar av halmkärvar. Blir vinden gynnsam för vindkraft kommer skrapan att trilla omkull efter att ha kostat oss miljardernas mångfald.

Mvh, Håkan.

Slabadang #21,

Oj, tack för bilden. Och klimatmodellerna som inte ens har med molnbildningen till någon reda. Har de månne förbisett något? 🙂