Mitt bidrag den här gången bygger på ett par blogginlägg från en klimatmodellerare som heter Ed Hawkins som skriver på en blogg som heter Climate Lab Book.

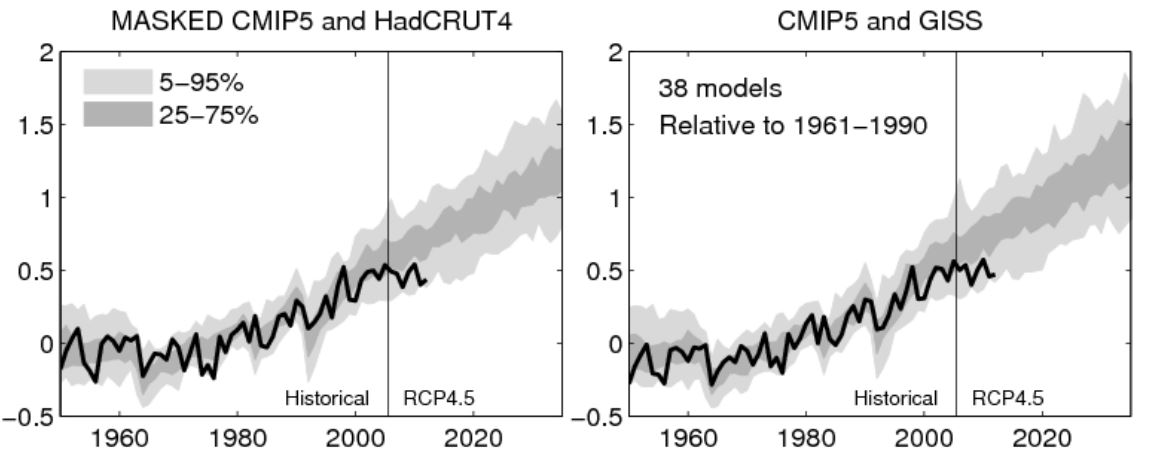

Ed Hawkins är på meteorologiavdelningen vid universitetet i Reading i Storbritannien där för övrigt även professor Lennart Bengtsson medverkar som Professorial Research Fellow. Liksom många andra klimatforskare funderar även Ed Hawkins på frågan om vad det vi kallar uppvärmningspausen kan tänkas bero på. Han har tagit upp detta i ett par av sina blogginlägg, här och här. Diagrammen ovan kommer från hans sistnämnda blogginlägg.

Diagrammen visar jämförelse av beräkningsresultaten från 38 olika avancerade klimatmodeller (beräknngarna ingår i ett samarbetsprogram som av IPCC betecknas med CMIP5) med två temperaturkurvor med uppmätta värden. I det vänstra diagrammet är temperaturkurvan från HadCRUT4 och i det högra från GISS. Till vänster om den lodräta linjen vid år 2005 har klimatmodellerna anpassats (genom så kallad tuning) till de uppmätta temperaturerna. Därefter är det alltså fråga om prognoser enligt ett scenario där utsläppen ökar per år i ungefär samma takt som före år 2005.

Scenariet som de 38 klimatmodellerna har använt för sina beräkningar efter år 2005 benämns av IPCC med koden RCP4.5. Grovt räknat motsvarar scenariet en ökning av koldioxidutsläppen med sådär en 1% per år från nivån år 2005 som var omkring 30 miljarder ton/år, men ökningen avtar så småningom (jag gissar att man tänker sig det med hjälp av ny energiteknologi) och vid år 2030 når utsläppen ett maximum och antas då börja minska. För jämförelsen mellan observerade och beräknade värden för tiden 2005-2012 är det naturligtvis tillräckligt att beräkningarna ligger nära de verkliga utsläppen under denna period.

De 38 klimatmodellernas beräkningar presenteras som mörkgrå och ljusgrå strutar. Mörkgrå strut anger att 50% av de simulerade värdena hamnade inom struten. Vid ljusgrå strut är det i stället 90% som hamnade inom struten. Anledningen till att det blir strutar på detta sätt är dels att klimatet har kaotiska processer så att gör man om samma beräkning flera gånger får man olika kurvor. Detta kan representeras med en strut som vi ser i diagrammet. Men dessutom ger var och en av de 38 modellerna olika sådana strutar eftersom de har olika klimatkänslighet beroende på att klimatprocessernas detaljer har modellerats på olika sätt i olika klimatmodeller. Så det vi ser är en strut som smälts samman av 38 enskilda strutar.

Kurvorna för observerad temperatur följer den mörkgrå struten fram till 2000-talet. Ibland sticker temperaturen ut över denna strut, ibland sticker den ut nedanför men den håller sig huvudsakligen inom den mörkgråa struten, vilket är en följd av den så kallade tuningen.

Men efter år 2000 har kurvorna för observerad temperatur gått in i uppvärmningspausen, både enligt HadCRUT4 och enligt GISS. Detta har medfört att kurvorna nu är helt inne i den nedre delen av den ljusgråa struten. Det verkar som de observerade temperaturerna bättre följer de modeller som ger den minsta uppvärmningen, har den lägsta klimatkänsligheten.

En egen fundering som jag har är följande. Tänk om uppvärmningspausen blir lika lång som i början av diagrammet, dvs. 1950-1980 vilket är trettio år. Detta skulle innebära att uppvärmningspausen fortsätter nästan till 2030 och då skulle de observerade temperaturerna hamna klart under den ljusgråa struten.

Nu är det så att uppvärmningspausen 1950-1980 enligt IPCC anses bero på att mänskliga utsläpp av kylande aerosoler har uppvägt de ökande växthusgasernas effekt. Men något sådant har inte kunna beläggas för den nuvarande uppvärmningspausen även om man gissat på att orsaken skulle kunna vara ökade aerosolutläpp i Kina, men detta verkar inte så sannolikt. Därför borde uppvärmningspausen nu bero på något annat, någon form av naturlig variation.

På senaste tiden har det dessutom börjat komma nya resultat om aerosoler som tyder på att hypotesen om deras kylande effekt 1950-1980 kanske inte stämmer. Då skulle denna gamla uppvärmningspaus kanske helt enkelt också ha berott på naturlig variation. Då skulle även innevarande uppvärmningspaus faktiskt kunna bli trettio år lång. Det skall bli intressant att se hur det går.

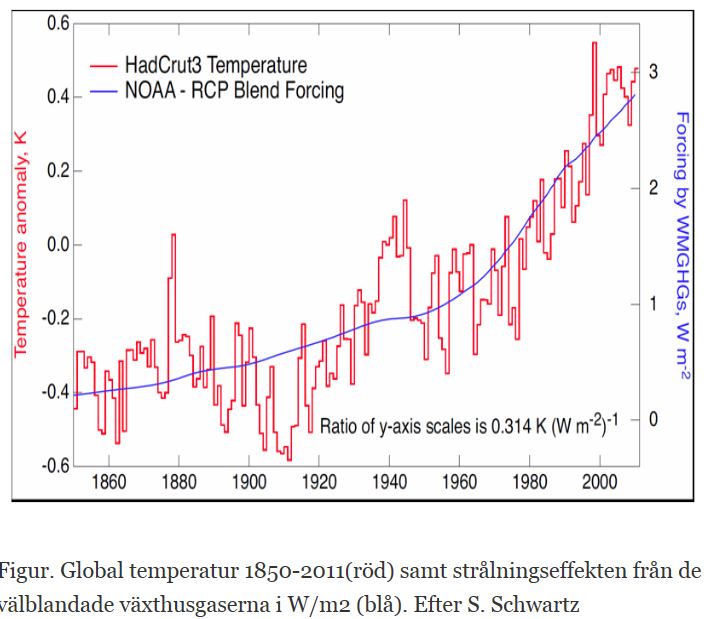

Men vi kan ta tankeexperimentet ett steg till. Om vi nämligen tänker oss att vi inte bara får en fortsatt uppvärmingspaus utan att temperaturen går ner som på 1940-talet som vi ser i följande figur enligt Schwartz som Lennart Bengtsson brukar framhålla så kommer vi att få en ändå större skillnad melllan klimatmodellerna och observationerna. Det sätt som kurvorna för temperatur och forcing jämförs i detta diagram kan med vissa antaganden tolkas som en låg transient klimatkänslighet på omkring 1,2 C per koldioxidfördubbling.

Om Schwartz diagram ger den rätta bilden så betyder det att man utvecklat de avancerade klimatmodellerna för att i alltför hög grad stämma med klimatets utveckling efter år 1950. Men man har lagt ned för lite kraft på att få modellerna att beskriva den typ av naturlig variation som skedde omkring 1940-talet.

Ed Hawkins tar upp detta med aerosolerna och den naturliga variationen, men kanske inte exakt så som jag resonerat ovan, och han menar att detta är två faktorer som kan förklara att vi fått en uppvärmningspaus som inte stämmer så bra med modellerna. Han menar också att ytterligare en faktor kan vara att de av de 38 modellerna med höga klimatkänsligheter har för hög sådan. Men han tror mest på en kombination av dessa förklaringar, aerosolernas kylande effekt har överskattats, naturliga variationer har förbisetts och klimatkänsligheten har överskattats.

Men Ed Hawkins menar att man inte kan säga att uppmätta värden och beräkningar inte stämmer eftersom mätvärdena faktiskt fortfarande är inom den ljusgråa struten. Detta har väckt en del frågor för min del.

En starkt bidragande orsak till att strutarna i diagrammen är så vida är att de bygger på så många olika klimatmodeller, 38 styckern. Jag är faktiskt lite undrande över detta att man har 38 avancerade klimatmodeller. Vad jag förstår så är det inte precis billigt att utveckla och att arbeta med klimatmodellerna. De är dessutom mycket krävande i fråga om att de behöver de allra kraftfullaste datorerna. Vad är motivet för att utveckla så många olika klimatmodeller i stället för att utveckla färre så att man kan koncentrera sina resurser på att ta fram färre men bättre klimatmodeller?

En annan sak som väcker undran är värdet av beräkningar med de avancerade klimatmodellerna som metod för att studera klimatet jämfört med andra metoder. Ta till exempel diagrammet enligt Schwartz som bygger på kombination av observationer med enklare typer av matematiska modeller.

Jag frågar mig om de resultat man får med klimatmodellerna, typ dessa strutar vi ser i diagrammen ovan, verkligen är värda de stora resurser som beräkningarna faktiskt kräver. Hur mycket klokare blir vi egentligen av att i diagrammen med klimatmodellerna längst upp jämföra uppmätta temperaturer som har ett fel på så där ± 0,1 C med de i strutarna redovisade beräkningarna som har en spridning på så där en ± 0,3 C? Om det är Schwartz diagram som är närmast sanningen så har man verkligen anledning att ställa den frågan.

Modeller som följer sin kurva så länge den anpassats mot historiskt data men direkt ”flipprar” ur när den skall prognostisera framtiden säger mig att prognosmakarna inte förstått förloppets bakomliggande mekanismer tillräckligt väl.

I aktiesammanhang är det lätt att i ett programpaket för teknisk aktieanalys göra en modell över kursutvecklingen för valfri aktie och med 2-3 fria variabler som ”tunas” mot historiskt kursdata göra en modell som följer kursförloppet tillräckligt bra för att göra vem som helst till ”historisk aktiemiljardär”.

När modellen används för att prognostisera framtida kursutveckling ser det tyvärr alltid ut som i diagrammen ovan.

Tack, pedagogiskt som vanligt. Många intressanta funderingar och frågor att besvara för dem som anser att science is settled

1. Felaktiga indata ger fel utdata. 2. Felaktig modell ger fel resultat. Skrämmande utveckling i forskarvärlden när politiker och industri ger pengar för att ”forskare” ska visa bevis för vad de betalt för. En omvänd typ av bevisföring. Jag tänker då på klimat-, genus-, fettforskning bl a. Världen blir bara galnare. Vi har tyvärr släppt fram dårar som tagit kommandot av Världen. UI hänvisar ju tex till IPPC:s klimatexperter, men IPPC visar sig vara befolkat av byråkrater och gröna aktivister.

Pehr! Kanske en naiv fråga, men varfö röverhuvudtaget lägga ihop körningar från flera olika modeller och sedan hävda att de ”stämmer” med observationer? I vilken annan vetenskap skulle det vara tillåtet? Tänk på konsekvenserna inom medicin t.ex. Det borde ju finnas en modell som följer observationerna ganska bra. Det borde alltså vara den som beskriver verkligheten bäst. Varför överhuvudtaget ha med de andra då? Eller är det så, hemska tanke, att vid en annan körning med samma modell kan resutatet hamna långt ifrån det tidigare? Hur kan man då överhuvudtaget resonera i termer som att modellerna ”stämmer”. Det är ju ren slump i såfall även om resultaten hamnar inom 2sigma för en begränsad period. Dvs ”spurious correlation”?

AG #4. Den särskrivningen tillförde svenska språket något!

Annars händer det mycket inom tabloidvetenskapen. Jättetorkan i USA som ”var ett bevis på de antropogena klimatförändringarna” har nå blivit omvandlat till simpelt munväder:

http://wattsupwiththat.com/2013/04/11/new-government-report-says-2012-summer-drought-not-caused-by-global-warming/#more-84018

Heja Adolf G #4

Ditt lilla felskriv lyste upp min morgon! ”Röverhuvud(-)taget var riktigt kul!

Får jag kontra med att ändra klimatmodellerare till klimatmodell-lurare då?

Till Pehr den vanliga komplimangen naturligtvis.

Intressant men varför envisas du Pehr med att använda ”paus”? Vet du att det är en paus i uppvärmningen och den kommer att fortsätta efter en paus? Kan det bli kallare?

#6 Felskrivning? Snarare, vedertagen tarminologi.

Solens inverkan på klimatvariationerna lyser med sin frånvaro i modellerna. Solfläcksmaximum har kanske redan inträffad – på en låg nivå. Under senaste solfläcksminimum var solen utan fläckar under rekordlång tid. Möjligen är vi på väg mot en liknande situation som under Maunderminimat som anses ha haft betydelse för Lilla Istiden.

Det finns anledningar till att man använder många olika modeller. En är att det inte finns något självklart sätt att mäta vilken modell som är bäst. En modell kan t.ex. vara bra på temperatur, men sämre på nederbörd, bra över Europa, men sämre över Sydamerika.

Alternativet till körningar med många modeller vore att göra ännu fler körningar med bara en modell. Gjorde man 1000 körningar med en modell skulle man kunna få ett säkert statistiskt mått på klimatutvecklingen, men om t.ex. klimatkänsligheten i modellen är helt fel så blir det en falsk säkerhet.

Då är det bättre att göra körningar med olika modeller som fungerar lite olika. På så sätt får man en bättre beskrivning av osäkerheterna i scenarierna, och det går dessutom att ringa in osäkerheterna bättre. Om modellerna är överens vet vi antagligen ganska bra hur en process fungerar, om modellerna inte är överens så finns det mer att göra.

AG #8, som jag plägar säga: post(colon)ialt vokabulär när det är som bäst! :-9

Sorry Pehr, för dett OT.

För mig är dessa modeller fullständigt, totalt, meningslösa. De är klockrena exempel på kurvanpassning mot historiskt data som felar ut när det gäller att förutsäga någonting. Det är ett så välkänt fenomen att jag skulle skämmas för att publicera resultatet. Att försöka ”måla över” felet genom att sprida ut resultatet med 38 modeller förvärrar bara det hela och kastar ett löjets skimmer över hela detta modelleringsspektakel.

”Bedrövligt” är ett utomordentligt snällt omdöme

Modellerna saknar helt prognosvärde genom att de aldrig validerats. De representerar modellerens åsikter och inte vetenskapliga fakta. Pratet om att för lite hänsyn tagits till 40-talet visar att man inte förstått de fysikaliska processerna.

För övrigt initieras modellerna inte med verkliga data. Olika körningar får då olika resultat. Detta innebär INTE att man kan modellera de naturliga kaotiska processerna.

Sen att lägga ihop olika modeller som bygger på helt likartade principer förbättrar inte helheten men ökar spridningen något. 38 fel summerade är inte mindre än ett. Att tro att prognosvärdet förbättras av detta är naivt.

Hade modellerna varit trovärdiga skulle de kunnat initieras och ge prognoser även de närmaste åren.

För övrigt gillar jag inte att du kallar det uppvärmningspaus. Vad vet du om det? Modellerna saknar prognosvärde. Det kan bli kallare framöver också.

Pehr B

Jag frågar mig istället varför man jämför verkligheten med modellerna?Vilket jag tycker mig se att man gör.

Modellerna har blivit verklighet och när verkligheten inte följer modellerna så undrar man vad det har blivit för fel på klimatet och kallar det för en uppvärmningspaus och försöker förklara verklighetens bångstyrighet med diverse krystade förklaringar.

Jag tycker man skall jämföra klimatvetenskapare med vanliga människor och försöka ta reda på vad det är för fel på klimatvetenskapare.

Eftersom vi vanliga människor är bångstyriga precis som verkligheten i motsats till klimatvetenskapare som är som misslyckade modeller så borde det vara vi som sköter politiken och klimatvetenskapare som sköter sig själva och käkar den medicin som kan bota deras ångest.

Men Pehr B! Jag gillar dina inlägg. Tro inget annat.

#11 Varför är det aldrig så här roligt på AGW-bloggarna? Jag hade faktiskt inte hört ”Post-colon-ialt” tidigare. Genitaliskt!

”Tänk om uppvärmningspausen blir lika lång som i början av diagrammet, dvs. 1950-1980 vilket är trettio år. Detta skulle innebära att uppvärmningspausen fortsätter nästan till 2030 och då skulle de observerade temperaturerna hamna klart under den ljusgråa struten.”

Repris från https://www.klimatupplysningen.se/2013/04/09/professor-bob-carter-torpederar-konsensus-om-globala-uppvarmningen/

”Intressant att han sträcker sig till 23 år. Om vi lägger till Met Offices’ prognos om ytterligare 5 år så blir det 28 år. Deras tidigare prognoser var på 10 år och man med fog anta att anledningen till att de förkortat den är att den skulle visat på 10 år av utebliven uppvärmning.

10 + 23 = 33 år och då har vi en, av det heliga WMO definierad, tvättäkta klimatdatapunkt.”

GS

Det där argumentet är väl IPCCs ’bästa’ version av varför man bör lita på dessa modell-ensemble-prediktioner. För att de ju är ungefär överens inbördes.

Men det är inget vetenskapligt argument, det är baraytterligare en variant av appeller till ’konsensus’

Hej

Jag tycker Pehr har gjort en bra sammanställning. Det som är missledande med att visa IPCCs ”strutdiagram” är att dessa visar ett medelvärde av ett antal beräkningar. Ett medelvärde kan aldrig inträffa. Den verkliga temperaturen är bara en av ett antal olika och i princip möjliga kurvor där flera av dem i modellberäkningarna visar perioder på 10-30 år av ringa eller ingen uppvärmning och sedan perioder med en snabbare. Emellertid över en mycket lång period är det helt klart att enbart de långlivade växthusgaserna (den ekvivalenta CO2 koncentrationen har nu ökat till ca 490 ppm) motsvarar en fördubblad CO2 ca 1.1°C temperaturökning. Orsaken till denna ringa uppvärmning är inte helt klar och indikerar ett systematiskt fel i klimatmodellerna. Fel i reflektion från moln och aerosoler och förhöjd transport till djuphavet är tänkbara möjligheter. De variationer som vi ser på 100-års skalan är med största sannolikhet interna variationer i klimatsystemet och beror inte på ngn särskild extern ”forcing” då enskilda modellberäkningar visar detta av sig själv så att säga. Vi skall givetvis vara tacksamma för detta då det ger oss ytterligare tid att finna förnuftiga lösningar på energiproblemet. Det märkliga är att inte alla tycks vara tacksamma för den måttliga uppvärmningen utan grips av ännu större oro över att ”syndafloden”ännu inte inträffat som de oupphörligt fått höra från vår tids katedrar och att den kanske blir ännu mer förfärande. Att skrämma upp människor i onödan är inte bara dumt utan också otillständigt.

GS

Ingenting blir bättre av att man använder fler modeller om man missat att ta med någon grundläggande faktor. Och det är ju bara att titta på resultatet så ser man att något fattas. Modellerna klarar inte av att prognostisera. De klarar bara av historisk kurvanpassning. Punkt.

”Nu är det så att uppvärmningspausen 1950-1980 enligt IPCC anses bero på att mänskliga utsläpp av kylande aerosoler.”

Detta är grunden till problemen eftersom man helt utesluter inverkan av havsoscillationerna AMO/PDO för att man skall kunna hävda att uppvärmningen 1970-2000 måste då ha med CO2 att göra. Om man nu tar med haven innebär det ju direkt att klimatkänsligheten måste justeras ned i motvsarande grad, vilket inte gynnar ”the cause”.

Helt absurt för att inte säga bedrägligt att man på detta sätt utesluter flera parametrar, haven & solen, för att resterande inverkan då återstår pga. CO2. Inte alls konstigt att modellerna inte fungerar alltså.

Bra analys och beskrivning av modellhanteringen! Efter år 2000 börjar output från modellerna med helt avvikande resultat än vad empiriska data uppvisar. Att sen 38 olika modeller i stort har samma trend, ligger i att samma förutsättningar finns inbyggda i modellerna. Var finns naturliga svängningar i tillförseln av energi från solen? Var finns allbedots inverkan genom variation i molnbildningen? Var finns etc……..? Är det rimligt att vår ekonomiska framtid skall ligga i händerna på ett antal modeller som IPCC gömmer sig bakom?

Det finns ingen nackdel med att CO2 ökar i atmosfären! Bara fördelar! Hållar helt med #12 0 13! Modellerna är löjliga o totalt värdelösa. Påminner om rasbiologin på 30-talet eller vattenprovet för häxor!

IPCC angav att det mesta av uppvärmningen under senare delen av 1900-talet till 90% sannolikhet var orsakad av människan.

Nu visar istället deras modeller att de till 95% sannolikhet helt enkelt haft FEL.

De nuvarande modellerna har flera stora brister. De antar att det mesta beror på CO2 och ingat annat. Aerosoler är bara ett sätt att snygga till resultatet historiskt. Återkopplingen via vattenånga är gissad. Havet, ENSO, PDO, AMO har man inte grepp om. Moln och dess påverkan klarar man inte heller. Solens påverkan säger man att den är nästan försumbar fast korrelationen med globala temperaturen är betydligt bättre än för CO2.

Kvar blir modeller som man kan använda för att labba med olika scenarier vilket kan tillföra viss kunskap. Prognoser duger modellerna inte till.

Politikerna har vräkt ut hundratals miljarder kronor på detta med IPCC och modellerna. Vad har man fått? 38 likartade modeller som saknar prognosvärde! De kunde väl åtminstone satsat en del av pengarna på andra typer av modeller. Fast då hade output nog inte blivit det önskade fast kanske närmare verkligheten. Ge mig några hundra Mkr så ska jag leverera en modell som ger bättre prognoser än IPCC:s modeller. Inte perfekta prognoser men bättre än IPCC:s.

http://www.forecastingprinciples.com/

Precis min fundering: Vad i modellerna ger denna avvikelse om inte CO2. Är det någon annan parameter som kan ha spelat dem ett spratt? Nu är det en kort period-men varför är modellerna så samstämmiga? Har de något antagande de har gemensamt?

Med 38 modeller så är det säkert vissa som bygger på andra.

Sen är det förunderligt att det är dessa beräkningar som ligger bakom alla alarm och att vi skall se dem som konsensus!

Modellerna har visst ett bevisvärde!

De bevisar helt korrekt hur LITE den ”samlade klimatvetenskapen” faktiskt vet om klimatet.

Lasse #25

>Är det någon annan parameter som kan ha spelat dem ett spratt?

Det finns många parametrar som de inte ens har med

>Har de något antagande de har gemensamt?

Ja koldioxiden och säkert andra. De flesta parametrar är säker desamma för all modellerna, de har bara varierat på hur stor påverkan de har.

Att tala om konsensus för modeller är rena dumheter. Det är ett sätt att öka på imponeringsfaktorn för människor som inte har kunskap om modellering. Jag har arbetat med prognostisering men aldrig stött på detta sätt att redovisa resultat. Antingen har man en (1) modell som kan förutsäga framtiden eller så har man det inte.

Här har vi en vad de kallar ”ensemble” av ”scenarier” och hittills har detta skojeri inte lyckats förutsäga nånting.

Lasse #25: Samtliga dessa 38 modeller bygger på samma principer som härstammar från meteorologin. Jordens delas in i ett tredimensionellt rutmönster, partiella diffentialekvationer används för att representera fysiken, randvärden finns. Sen integrerar man sig framåt i tiden. Då någon analytisk lösning inte finns används kraftfulla datorer och numeriska metoder. Ingen av klimatmodellerna initieras med riktiga startvärden till skillnad från vädermodellerna. Istället kör man de massor av gånger med olika påhittade startvärden. Resultatet blir ett spagettinystan.

Skillanden mellan de 38 modellerna är små. Olika randvärden, gridtäthet, lite skillnad på några parametrar. Men samma principer och forskargäng som pratar mycket inbördes.

Ingen slump att SMHI fått uppdrag av svenska politiker att ta fram regionala klimatprognoser. Alla (t.o.m. experterna som Kevin Trenberth i IPCC) vet att detta är humbug och har uttalat det. Men SMHI kör vidare med klimatbluffen regionala prognoser och svenska politiker blir ”mycket bekymrade” över vår framtid. Hundratals kommitteer startas i olika kommuner för att bekämpa detta hemska klimat som om femtio eller hundra år ska dränka oss. En ding, ding värld var nog inte så ding som denna.

Per #28

För i tiden litade härskarna på orakel och präster.

Det är lika djefla illa nu. Eller tom värre. Fenomenet är globalt. Enda skillnaden är att oraklen och prästerna påstår att det är vetenskap. Fast de kanske de gjorde förr i tiden också.

Eftersom det är fredag …. jag såg denna graf och man blir ju lite orolig för att det inte är koldioxiden som styr klimatet utan någonting helt annat :-0

förklaringen till den globala nedkylningn

#26

+1

Hur mycket av ökningen av CO2-koncentrationen beror på mänsklig påverkan? När det blir varmare så avger ju haven CO2 till atmosfären. Den ökande CO2-koncentrationen gör att växterna växer bättre. Och då tas mer CO2 upp av växtligheten än tidigare.

Fördelen med dessa strut-diagram är att snart måste IPCC ta på sig dum-struten. De är sålunda på rätt väg.

S G #32.

”När havet blir varmare”. Har det blivit det?

Jag tror att växter och svamp som kolsänkor är underskattat. Se bara på hur den svenska skogen växer så det knakar på grund av koldioxidgödsling.

Det här var bland det mest korkade jag har sett.

Inte inlägget alltså, men det bakomliggande resonemanget. Om man har ett antal oberoende modeller, där varje modell ger ett väntevärde och en varians för en viss parameter vid varje tidpunkt, så skulle en sammanslagning av dessa modeller medföra att varianansen minskar.

Att använda olika modellkörningar som någon form av spridningsmått är helt barockt. Varje modell bör rimligen skatta ett väntevärde och en varians för en given parameter. Om residualen mellan mätvärdet och modellskattningen är högre än den beräknade variansen så är modellen falsifierad och ska slängas.

Ett mer intressant mått är att se hur många av modellerna som är falsifierade, dvs där de väntevärde plus varians inte täcker in residualen enligt något lämpligt mått.

Inlägg som fastnade i filtret?

!7.12 Länkar till SMHI borde inte utlösa någon moderering? Och inga svordomar ellere andra fula ord.1

Lars Cornell #34

”Jag tror att växter och svamp som kolsänkor är underskattat.”

Jag har aldrig underskattat det utan tvärt om, jordisering är ju en kopia av hur naturen fångar in koldioxid och växer ner i form av stora och djupa rotsystem. Skillnaden är när människan jordiserar genom grävning, borrning eller plöjning så kan hon mångdubbla mängden kol (per ytenhet) i form av organiskt avfall jämfört med naturens rotsystem.

I dag har Skogsaktuellt också en artikel ”Nya rön kring lagring av kol i skogsmark”:

http://www.skogsaktuellt.se/?p=42567&pt=108&m=1422

Märkligt, men i artikeln nämns inte att detta också är naturens sätt att gödsla sig själv. När växternas rötter ruttnar i jorden blir ju dessa till näring till befintlig och nästa generation växter och detta har pågått i årmiljoner. Utan denna underjordiska gödsling skulle jorden snart bli ett stort kalhygge. Kanske vi äntligen kan få ett slut på det här tramseriet med kompostering, ytgödsling och plöjningsfritt.

NOAA slår nu fast att Norra Ishavet blir isfritt före 2050; kanske rentav 2020-2030-talen. Då förändras globala klimatet ännu mer; det blir jättevarmt här nere. [Men… var det inte isbristen som gjorde att vi fick det så kallt här nere, nu?]

Men räknar på tre sätt. ”Trendsetters” räknar med att trenden från förr fortsätter även framåt. Då blir det nästan helt isfritt 2020. ”Stochasters” tittar på tidigare stora isförluster och räknar med att de kommer igen; fast man säger inte när. Då blir Arktis isfritt 2030. ”Modelers” slutligen tittar på – you guessed it – alla de globala klimat-modeller som forskarna tagit fram. Då kan det bli isfritt 2040, fast troligare 2060. (Men, noterar NOAA, den där prognosen måste vara för långsam! Det är nu vi behöver våra anslag.)

http://www.noaanews.noaa.gov/stories2013/20130412_arcticseaice.html

”NOAA is an agency that enriches life through science … We are proud of our role in protecting life and property and conserving and protecting natural resources.” The Boss.

http://www.noaa.gov/about-noaa.html