Det satsas enorma summor idag på att bygga klimatmodeller: programvaran blir alltmer avancerad och följaktligen måste hårdvaran bli större, snabbare och mer komplicerad. Ju fler variabler man drar in i modellen, desto fler ekvationer måste lösas på allt kortare tid. Klimatet är ett oerhört komplext system och det verkar därför logiskt att man försöker få med så många faktorer som möjligt om man nu skall lyckas simulera jordens verkliga klimat.

Men enligt en nyutkommen artikel i Nature Climate Change, (Knutti, R. and Sedlacek, J. 2013. Robustness and uncertainties in the new CMIP5 climate model projections. Nature Climate Change 3: 369-373.) så lyckas inte de nyare, flashigare och mycket dyrare modellerna för i år särskilt mycket bättre än de som man använt tidigare. I artikeln jämför författarna de modeller som används i IPCCs rapport i år (AR5) med dem som användes i deras förra rapport (AR4, 2007). De säger bl.a.:

1. De beräknade globala temperaturförändringarna i de nya modellerna är anmärkningsvärt lika dem som användes i IPCC AR4 om man tar hänsyn till de olika underliggande scenarierna.

2. Spridningen mellan modellerna har inte ändrats mycket trots en substantiell modellutveckling och en massiv utökning av beräkningskapaciteten.

3. Det finns … knappast något från [de senare modellerna] som visar att vår förmåga att begränsa storskaliga återkopplingar har blivit bättre.

Hans von Storch et. al. skriver i en ny artikel: I motsats till tidigare analyser av en tioårs-period som indikerade en konsistens mellan modeller och observationer vid 5% konfidensnivå, så finner vi att den fortsatta stagnationen av uppvärmningen under femton år, mellan 1998 och 2012, inte längre är konsistent med modellprojektionerna ens vid en konfidensnivå på 2%.

Nej, det verkar inte som om de nya, sofistikerade modellerna fungerar särskilt bra – trots att de har ett flashigt yttre och att de är svindyra i drift. Ja, i själva verket så finns det tecken som tyder på att enklare modeller som bygger på erfarenhet och observation av den bistra verkligheten är mycket mer robusta. 🙂

Här är några exempel:

Steve McIntyre på Climate Audit har testat (här och här) en modell baserad på Guy Callendars beräkningar från 30-talet. Callendar är legendarisk i klimatkretsar eftersom han var bland de första att pröva teorin om koldioxidens påverkan på klimatet mot observationer. Den modellen slår Met Offices nya superdupermodell som är deras bidrag till AR5, och stämmer bättre med temperaturutvecklingen under 1900-talet.

Tidigare i våras publicerade Syun-Ichi Akasofu en artikel i tidskriften Climate. Där visar han hur hans egen enkla modell med havströmmarnas oscillationer överlagrade på en linjär uppvärmning med 0,5 °C/sekel sedan den Lilla Istiden stämmer väl med den globala temperaturutvecklingen. Även de senaste dryga 15 åren med utplaning passar in. Här är ett tidigare inlägg om Akasofus arbete på TCS.

Slutligen så publicerade våra norska vänner, Jan-Erik Solheim och Ole Humlum, alldeles i dagarna en artikel i geoforskning.no med rubriken ”En enkel empirisk harmonisk klimamodell”. Den verkar också klart överlägsen IPCCs klimatmodeller.

Gemensamt för alla dessa enkla modeller är att de har en låg klimatkänslighet och att de förstärkningseffekter från luftfuktigheten och moln som de mer komplicerade modellerna räknar med är små eller obefintliga. Så det ligger kanske ändå något i kritiken mot IPCCs modeller. Så länge man laddat dem med ”överkänslighet” för koldioxiden så har de ett litet helsike att få dem att stämma med observationerna.

Ingemar Nordin

Professor emeritus i filosofi. Forskningsinriktning är vetenskapsteori, teknikfilosofi och politisk filosofi. Huvudredaktör för Klimatupplysningen.

Tack, Ingemar – var det inte så att inte ens att paret temperaturobservationer och luftfuktigheten behagat följa dogmen?

https://www.klimatupplysningen.se/2013/04/02/kan-ipcc-halla-angan-uppe/

Ingemar

Dessa triviala modeller Du nämner är just nonsens och har ingenting med seriös vetenskap att göra. De kolossala framstegen inom de globala väderprognoserna ( som exempelvis prognosen av orkanen Sandy i november 2012 som ECMWF gjorde en dryg vecka i förväg och som berodde just på att deras modell var mer avancerad!) är här ett tydligt exempel.

Problemet som vi har är att vädret på olika tidsskalor, som många envisas med att kalla klimat, inte är möjligt att beräkna exakt beroende på fundamentala egenskaper hos kaotiska system. Dagens sk klimatmodeller har tyvärr också systematiska fel vilket är ganska uppenbart från alla utvärderingar som IPCC och många andra genomfört och beror INTE på att modellerna är för komplexa utan att de har begränsningar som ännu inte klarlagts. En väsentlig orsak till dessa begränsningarna beror i stället på att modellerna inte är tillräckligt avancerade och inte kan inkludera viktiga processer i atmosfär och hav som t ex småskaliga vädersystem vilka behövs för att inkludera moln på ett realistiskt sätt.

Ovetenskapliga förenklade amatörmässiga resonemang av det slag Du framställer är mestadels grovt missvisande. Tankarna går till Kina under det stora språnget där dylika tankemönster ledde till gränslöst lidande för det kinesiska folket.

LennartB

”Dagens sk klimatmodeller har tyvärr också systematiska fel vilket är ganska uppenbart från alla utvärderingar som IPCC och många andra genomfört och beror INTE på att modellerna är för komplexa utan att de har begränsningar som ännu inte klarlagts.”

De uppenbara systematiska felen inkluderar en groteskt överskattad klimatkänslighet. Att man fortfarande inte korrigerat detta, det mest allvarliga felet, visar att klimatvetenskapen i första hand inte är en vetenskap utan ett redskap för ideologiska krafter.

# 2

Den datorkraft som behövs för mer och mer ”avancerade” modeller av ett kaotiskt system ökar exponentiellt, och därmed ochså kostnaden för datorerna.

Till slut så går alla skattepengar till superdatorer, men vi når ändå inte fram.

Lennart B #2,

Det är säkert bra med avancerade väderprogram för att förutspå väder. Och som du säger så har de blivit allt bättre.

Problemet med de avancerade modellerna är att vissa forskare och demagoger använder dem för att slå blå dunster i ögonen på folk och beslutsfattare som blir väldigt imponerade av stora och dyra datamaskiner och program utan att förstå dess begränsningar. Det är ett slags razzle-dazzle http://www.youtube.com/watch?v=c-zEtAuKuUY .

Beträffande amatörer så stämmer det att Guy Callendar faktiskt var klimatamatör http://en.wikipedia.org/wiki/Guy_Stewart_Callendar , men de övriga?

Beträffande frågan vad som är fel med dagens klimatmodeller så säger Hans von Storch et al. vidare:

Of the possible causes of the inconsistency, the underestimation of internal natural climate variability on decadal time scales is a plausible candidate, but the influence of unaccounted external forcing factors or an overestimation of the model sensitivity to elevated greenhouse gas concentrations cannot be ruled out.

Det finns onekligen en och annan poäng i Lennart B:s analogier, nu ”det stora språnget” och kulturrevolutionen tidigare Quick.

Men Ingemar hur resonerar du här..

”…..och att de förstärkningseffekter från luftfuktigheten och moln som de mer komplicerade modellerna räknar med är små eller obefintliga. Så det ligger kanske ändå något i kritiken mot IPCCs modeller. Så länge man laddat dem med ”överkänslighet” för koldioxiden så har de ett litet helsike …….”

luftfuktighet, moln blir koldioxid??

Att modellerna är bristfälliga tycks vara uppenbart. Frågan är om de missat något i sin iver att förklara CO2s växthuseffekt eller om det är tillfälligheter som spökar?

Med enklare modeller så kanske förståelsen för olika parametrars påverkan kan öka.

Att som Lennart Bengtsson koppla vädermodeller till klimatmodeller visar på komplexiteten med att bygga modeller. Vem litar på en årsväderprognos?

LBt2013/08/13 kl. 08:53

Jag förstår inte vad Du skriver. Det typiska modellantagandet är vad jag förstår att en grundläggande uppvärmning via mer koldioxid i atmosfären skulle förstärkas en faktor ca 3 via mer vattenånga i atmosfären pga ökad avdunstning.

Det är i alla fall i min hjärna orimligt av flera skäl (bl.a. det logaritmiska strålningsbeteendet, och en endast ca 6% ändring av vattens ångtryck per grad), men har blivit dogm.

För att balansera denna höga känslighet i modellerna har man för att de inte ska skena totalt lagt in vad som då också borde vara en överdriven dämpande effekt av aerosoler.

Detta är inte något jag hittat på – jag citerar bl.a. Lindzen.

Hursomhelst är något sjukt, som nu ex von Storch söker uttrycka på ett diplomatiskt sätt.

Akasofu postulerar en naturlig men oförklarad uppvärmning som är ungefär lika stor som den som normalt anses bero på CO2 och drar därav, inte oväntat, slutsatsen att det inte finns något utrymme för CO2 i hans budget. Det är som att postulera änglar som puttar runt planeterna och därefter hävda att det då inte finns något utrymme för en gravitationskraft.

Solheim och Humlum är än värre. De tycks ha återupptäckt att man kan reproducera vilken kurva som helst med ett lämpligt antal sinuskurvor och försöker dra slutsatser ur sin kurvanpassning. Det är pinsamt både för dem och för Ingemar Nordin som drar upp den artikeln som om den bevisade något.

Thomas P #9,

Jag är inte särskilt impad av modeller, hur avancerade de än är, som inte stämmer med data. Därav följer inte att man behöver vara särskilt impad av de enkla modellerna heller. Men som Lasse #7 påpekar så kan de kanske bidra till en bättre förståelse av olika parametrars påverkan …

Solfläckcykeln påverkas troligen av planeternas rörelser, främst Jupiter och Saturnus, vilka får Solen att röra sig i ett komplicerat mönster runt barycentrum. (Det är så vi upptäcker exoplanter runt andra stjärnor). Om solfläckcykeln har någon inverkan på Jordens klimat så borde det inte vara omöjligt att hitta periodicitet även i klimatet.

Lite OT: http://www.aftonbladet.se/nyheter/article17283975.ab

Lennart Bengtsson ¤2

Utsagor som tex:

Ovetenskapliga förenklade amatörmässiga resonemang av det slag Du framställer är mestadels grovt missvisande.

är väl ingenting annat än ett auktoritetsargument. Dessutom är de modeller Ingemar hänvisar till mindre missvisande än de som IPCC använder. Dessutom så tycker jag att det är tokigt att bygga långsiktiga prognoser på modeller som från början var avsedda för kortsiktiga prognoser (väder).

*5

Ingemar och övriga

Jag tror de flesta är medvetna om att dagens klimatmodeller sannolikt har systematiska fel och indikerar en alltför stor klimatkänslighet. Emellertid, att på något sätt indikera, som har gjorts, att detta är avslktligt är en beskyllan som jag tycker är osmaklig. Däremot beror det på vår oförmåga och bristande kunskap om det oerhört komplexa klimatsystemet. Vi vet ännu inte om vi har lyckats få med alla interna processer i klimatsystemet som kan ge upphov till kraftiga anomalier utan någon yttre påverkan. Det är av denna anledning som jag så kraftigt kritiserat det politiska samhället och dess kohorter som baserar konkreta handlingsprogram på dylika osäkerheter. Vad som är ett rimligt handlingsmönster i en dylik situation är att minimera potentiella risker när detta kan göras inom ramen för ett etablerat ekonomiskt system kombinerat med en aktivitetsplan om mot förmodan uppvärmningen skulle sätta igång och rusa iväg. Vad som dessutom bör göras är att verka för en mer förutsättningslös klimatforskning som drivs av ledande forskare och inte av politiserade forskare, dvs vad vi behöver är mer GRUNDFORSKNING och mindre tillämpade beräkningar efter ett slags IPCC-recept.

LennartB

Modellarbete är något jag har varit mycket inblandad i och är fortfarande men i en annan vetenskapsgren. Jag måste nog ge Thomas och LB rätt. För att få kallas modell måste någon slags mekanism finnas inbyggd – hur fel den än är. Att göra empiriska anpassningar är inte modeller enligt min mening. De saknar förklaringsvärde. Sedan är det en helt annat sak att ”förklaringen” och mekanismen som modelleras är åt skogen. Jag har precis avslutat en dialog med några NOAA-forskare om ”the missing heat”. De hävdar ju att värmen gått ner i djuphaven istället. Men då kommer nästa fråga: motsvarar den värme som gått ner i djuphaven den bortappade värmen i atmosfären? Det verkar faktiskt inte så (det är för lite – hur man än räknar) och pudelns kärna i Ingemars artikel är ju att dagens supermodeller ändå bygger på vissa antaganden kring klimatkänsligheten som stöds allt mindre av verkligheten. Problemet är att om man tvingas skriva ned klimatkänsligheten för mycket så blir det inte så mycket kvar av skräckscenariorna och motivationen att göra något. Då sinar också anslagen på sikt. Detta ligger inte i linje med post-modern forsknings mål. (Där är ju sanningen relativ och används bara selektivt som ett verktyg för ett politiskt mål).

Allt bör göras så enkelt som möjligt, men inte enklare. ~ Albert Einstein

Ingemar #10 ”Men som Lasse #7 påpekar så kan de kanske bidra till en bättre förståelse av olika parametrars påverkan …”

Enkla modeller baserade på sund fysik kan vara nyttiga på det sättet. Callendars modell kan ses som exempel på en sådan, även om den ignorerade så mycket att det mest fås ses som en slump att resultatet blivit så bra. De modeller jag kritiserade var dock av typen kurvanpassning utan någon fysikalisk relevans.

Lennart #13 ” kombinerat med en aktivitetsplan om mot förmodan uppvärmningen skulle sätta igång och rusa iväg.”

Kan du ge några tips på vad vi kan göra i ett sådant läge? Dels har du trögheten i klimatsystemet som gör att temperaturen lär fortsätta uppåt i decennier ens om vi omedelbart slutar med alla utsläpp och dels har du en tröghet i det ekonomiska systemet som gör att vi inte kan sluta med eller ens drastiskt minska utsläppen på mindre än många decennier. Kvar är livsfarliga projekt som att pumpa upp svavel i stratosfären och liknande.

Lennart B #13

Ja det var väl lite mer nyanserat än #2

Njae THomas #9

”Akasofu postulerar en naturlig men oförklarad uppvärmnin g som är ungefär lika stor som den som normalt anses bero på CO2”

Inte riktigt. Denna trend är iofs inte förklarad, men befintlig. Den har pågått sedan lilla istiden, dvs bra mycket längre än den mycket kortare (och numera avslutade?) period då klimatsimuleringarna försökta göra anspråk på att kunna ’förklara’ ngt.

Det är de enare som ad hoc och helt oförklarat antigit att att denna trend avslutats någon gång i mitten på 1900-talet och ersatts av en lika stor men CO2-vållad trend.

DIn liknelse med änglar som puttar på jorden är som vanligt illa vald. Bättre vore det då att hävda att de naturliga änglarna slutade precis lagom då du mfl trodde dig ha upptäckt CO2-änglarna!.

Kaosforskningen har visat att framtiden är genuint oförutsägbar. Varför håller man då på med prognosmodeller?

Så länge man baserar modellerna på tron att CO2 driver klimatet, har modellerna noll reell betydelse och berättigande. Solen är den modullerande faktorn som naturligtvis borde ha störst betydelse i en klimatmodell, men så är inte fallet. Jag har aldrig förstått hur man tänker när man använder som klimatdrivande, en passiv molekyl som CO2 i klimatmodeller och i det vetenskapliga tänkandet. Denna molekyl är underordnad i klimatsystemet.

Gamla ”Bettan”

Har du väl satt dig till att bygga en modell så är beteendevetenskapen i själva modellbyggeriet vitalt att förstå. Beroende på vilket område/bransch/specialområde modellen skall jobba inom finns olika tydliga krav och kriterier de måste uppfylla. Modeller måste ALLTID kunna valideras och Lennart Bengtsson blandar ihop eller tror att vi blandar ihop två HELT OLIKA kritierier och specifikationer medan det tvärtom är Lennart som blandar ihop ETT validerbart kriterium (vädermodell) med ett icke validerbart (framtida klimat) och tar den korta väderprognosförmågan som intäkt för att försvara klimatmodellernas mycket längre.

Det går faktiskt inte att resonera efter de villkoren. Varje modell måste valideras för sig och jag tror att man satte ner spaden på fel åker när man tog befintliga vädermodeller som utgångspunkt när man började utveckla klimatmodellerna enligt ”man tager vad man haver” utan att göra en gedigen analys av vad som krävdes för att kunna lösa uppgiften. Man satte bara igång helt enkelt med antagandet om att det bara var en vidareutvecklingfråga av befintliga vädermodeller. Nu sitter de där, fast i cementen och när tusentals människor jobbar efter samma recept så sitter vi med en mycket svårsmält insikt i att de jobbar med ett mission impossible av ett flertal grundläggande skäl.Men för varje ny tceak eller ny faktor så tror de sig ha kommit en bit till fast det kan vara allt längre ifrån istället. Utan möjligheter till validering jibbar de med bindel för ögonen och ked tanke på utvecklingen och dden obfintliga skillnaden mellan de ”nya” och de ”gamla modellerna” så måste de också ha öronpropparna i! Modellerna pekar åt HERLVETE !! Halllåååååååå!

I de framgångrika modellerna jobbar man inom ett område där de styrande faktorerna är mycket väl kända och begränsade i antal och alla modellerna är valideringsbara. Man kan helt enkelt faställa komplexitetens storlek och omfattning vilket INTE är möjligt med klimatmodellerna. Vilket i sin tur gör att de famlar i blindo och hamnar i tron att lägger man bara till en ny faktor så har man kommit närmare sanningen/korrekt scenario. Beteendevetenskpligt så är det här ett mycket förrädiskt beteende hos programerarna blinda inför hur många faktorer det finns, dvs omfattningen på koplexiteteten och var ny faktor blir istället en ny källa för nya felaktigheter. Jag har erfarit denna process vid flera tillfällen där man utvecklat ”nya”mer komplexa modeller från enklare väl fungerande ”Gamla Bettan” där utfallen blivit sämre än för de äldre. I klimatmodelleringarna har vi inte ens en validerad ”Gamla Bettan” att utgå ifrån och att använda vädermodellerna som validering är som att validera den längre utvecklingen på börsen mot att handla dollarn rätt på en vecka.

Därför kan Akasosfu Solheims och Callendars enkla ”Gamla Bettan” mycket väl vara mycket bättre än överkomplexa och ”felkomplexa” klimatmodeller. Lennart Bengtsson måste inse att man kan vara vän till vädermodeller men samtidigt helt förskjuta klimatmodellerna, för det är faktiskt två helt skilda saker, med helt olika kriterier och att tro att de utgör detsamma eller ”liknande” är en tanke som måste släppas.

Jag fattar inte ens hur man har mage att presentera dagens ovaliderade klimatmodeller som underlag för beslut i mångmiljard klassen. Det är så djupt oseriöst att det måste anses som rent kriminellt. Att samtidigt slå ihop summan av flera unika klimatmodeller till ett gemensamt svar är ett brott mot allt förnuft och logik. Modellerna i sig är pågående experiment och inget arbetsverktyg!

Att de smittat varandra med systematiska fel lyser lika tydligt som solen och främsta misstänkt är deras antaganden om klimatkänsligheten för co2s olika representanter för ”förstärkningseffekter”.

Gränsen dem emellan är tidsfaktorn och den stora skillnaden är att väderprognosen bygger på serier av nogranna detaljerade OBSERVATIONER med korta tidsperspektiv medan klimatmodellen bygger på antaganden med mycket långa. Vädermodellens förmåga att beräkna framåt i tiden utgör samtidigt gränsen för vad klimatmodellerna förmår att räkna. Resten av programmeringen och resultaten av klimatmodelleringen bortom denna tidsgräns har faktiskt NOLL prognosvärde eftersom de inte kan valideras och med facit i hand så kan vi bara konstaterar att så var fallet.

Att skaffa nya superdatorer gör bara att klimatmodellerna kommer att räkna fel mycket snabbare.

Skit in skit ut!

Hela skiten påminner om Dag Stålsjö som bland alla stenar i landet lyckades hitta intrikata mönster av enligt honom ovedersäglig karaktär och ur detta fakta…..klimatet bestäms av så många ”stenar” att avancerade modellerare kan hitta vilka mönster som helst. Det är tydligen vettigare med grova skattningar baserade på några få kända klimatpåverkande faktorer. Jag vill inte motsäga LB:s tro om att man kanske en gång kan få ett avancerat klimatmodellprogram att spotta ut något vettigt om framtida klimat det är en teoretisk möjlighet. Klimatmodellerarna borde framförallt inrikta sig på att nån gång få en modell att stämma med data bakåt i tiden. Kan man med programmet återskapa de senaste 100 årens väder med sina input borde det vara ett framsteg…där är dom inte ännu….framåt ännu mindre.Men så har det väl alltid varit i den akademiska världen..tusen pajasar på varje geni.

Pek #19 ”Kaosforskningen har visat att framtiden är genuint oförutsägbar. Varför håller man då på med prognosmodeller?”

Fråga alla ekonomer, politiker, företagsledare och vanligt folk varför de envisas med att göra upp planer för framtiden. Det är väl bättre att leva för dagen, konsumera för de pengar man råkar ha, inte investera för en framtid kaosteorin ändå bevisat att vi inte kan förutse.

Bra Ingemar! Scott Armstrong har granskat IPCC:s refererade klimatmodeller m.a.p prognosvärde och prognosmetoder. Armstrong är en av de duktigaste i världen på prognoser och tillhörande principer. Han kom fram till att klimatmodellerna bröt mot massa grundläggande principer och var i stort sett värdelösa för att göra prognoser med. De kallas inte heller längre prognoser i IPCC:s nya rapporter utan scenarier. Läs mer om principerna här http://www.forecastingprinciples.com/files/standardshort.pdf

Armstrong säger också att när osäkerhet råder ska ENKLA modeller väljas vilket stöder inläggets slutsatser. Osäkerhet om klimatet finns definitivt då man inte klarar att modellera molnbildning, havsströmmar m.m.

Hans H #22

Du skriver

”Klimatmodellerarna borde framförallt inrikta sig på att nån gång få en modell att stämma med data bakåt i tiden”

Efter som man gradvis har förvanskat historiska data (homogeniserat/masserat) kommer man, hur väl man än får modellerna att stämma med historiken, aldrig att kunna prognosticera framtiden.

För framtiden kan man inte förfalska som man kan med historien.

Thomas #23

”Fråga alla ekonomer, politiker, företagsledare och vanligt folk varför de envisas med att göra upp planer för framtiden. Det är väl bättre att leva för dagen, konsumera för de pengar man råkar ha, inte investera för en framtid kaosteorin ändå bevisat att vi inte kan förutse.”

Dom här människorna, politikerna undantagna, planerar långsiktigt typ 5-10år. Dom tar medvetna risker med egna pengar.

Klimathotarna och politikerna planerar 100 eller 1000 år med andras pengar utan att ta en enda risk för egen del.

Det är en viss skillnad.

En känd matematiker lär ha sagt att med fyra fria parametrar kan han bygga en elefant och med fem parametrar kan han få den att vifta med snabeln. Påminner om klimatmodellerna. 😀

Hans H och Pelle L – det går inte att simulera baklänges – numeriken divergerar snabbt.

Man kan bara simulera framåt, från något tänkt utgångsläge.

Peter Stilbs #27

Helt riktigt, men det var väl inte tanken här.

Utan som du skriver, att simulera framåt, från ett historiskt utgångsläge.

Simuleringen borde ju kunna startas från vilken tidpunkt som helst, så länge man har riktiga data att utgå ifrån.

I det sammanhanget är Perfekts länkade blogginlägg av Roger Pielke Jr intressant

https://www.klimatupplysningen.se/2013/08/11/nya-bevis-for-en-kosmiskt-orsakad-klimatkatastrof/#comment-344459

http://rogerpielkejr.blogspot.se/2009/08/we-lost-original-data.html

Per #24 ”Armstrong är en av de duktigaste i världen på prognoser”

Armstrong är i alla fall bra på att marknadsföra sig själv (naturligt givet att han är professor i marknadsföring), men det är som vanligt att på den här bloggen blir alla ”skeptiker” automatiskt upphöjda till världsledande. Att kritisera IPCC är ett enkelt sätt att bli världskänd i alla fall i vissa kretsar eftersom ”skeptikerna” är så desperata att hitta stöd.

Om framtiden vet vi tydligen väldigt lite, heller hur?

Men finns det något framtidsscenario där det inte kommer att vara önskvärt med så mycket och så billig energiproduktion som möjligt?

Är det då inte kontraproduktivt att försöka begränsa koldioxiden i atmosfären och att subventionera vindkraft?

Med tanke på framtiden bör vi väl redan nu satsa så mycket vi kan på kärnkraft och fossila råvaror som vi ju vet fungerar.

Thomas #23

”Det är väl bättre att leva för dagen, konsumera för de pengar man råkar ha, inte investera för en framtid kaosteorin ändå bevisat att vi inte kan förutse”

Men det låter ju precis som många politiker, speciellt vänsterlutande sådana, och också alla de andra som inte vill ta eget ansvar utan mer omhändertagna.

Och det gäller ännu mer sk ’klimatpolitik’ som ju enbart verkar vara ett race mot att få förslösa så mycket som möjligt på så meningslösa symbolhandningar det bara går (samtidigt som man lever gott på slöseriet själv), totalt ohämmat och ansvarslöst trots i ljuset av hur många länder går på knäna pga vidlyftigt spenderande med allt större andel hand-outs, entitlements, liabilities (pensions etc) och allt färre andel som skapar verkliga reella värden.

Frågan vad allt detta globala megaslöseri öht skulle kunna åstadkomma för klimatet är ju dess många beskäftiga och aktivistiska proponenter livrädda att ens närma sig …

Men de kallar det för ”göra upp planer för framtiden … ”

Fan tro’t

Thomas P!

Armstrongs principer fungerar och jag förstår därför att du blir grön av avund! Vem ska du referera till? Dessler? Han med sina svarta moln och 400 ppm co2 som styrande över all dynamik och feedback av 25.000 PPM vattenånga ? Herrn bakom det största systematiska felet inprogrammerat i klimatframtidens kristallkulor? Nåväl han kan ta skamkrok med Trenberth? Den dagen du har en gubbe med samma substans som Armstrong att relatera till skall jag börja lyssna på allvar. Min modell för sannolikheten för det scenariot är lika med NOLL!

Ett gäng som stoppar huvudet i sanden för observationer!

http://isccp.giss.nasa.gov/zD2BASICS/B8glbp.anomdevs.jpg

Thomas P!

Är det en ”katastrof” om tvättmaskinen går sönder? Du missar poängen i vad du själv hävdar.

Att ha ett sparande och eller försäkring är att skaffa sig en buffert för att vara stryktålig mot ALLA typer av händelser och inte bara vissa. Följer vi din och miljörörelsens logik så skall vi sätta av tusen miljarder för att tvättmaskinen kan gå sönder och inte bara för att den går sönder utan för att den då kan sätta eld inte bara på tvättstugan utan orsaka en brandstorm som kan bränna ner hela staden, kostnaden för denna risk avspeglas sedan i försäkrningspremien.. Vilken typ av andra händelser får du samtidigt då inte råd att skydda dig emot när försäkringspremien kostar tretusen tvättmaskiner!

För er som inte har gjort det, rekommenderar jag att ni läser Nate Silver´s bok ”The Signal and the Noise , THE ART AND SIENCE OF PREDICTION”. I den avhandlar han förutsägelser i allt från poker och vulkanutbrott till väderprognoser och IPCCs förutsägelser.

#2 Lennart Bengtsson

Du är ju väl insatt i modellerandet. Kan ge några ungefärliga uppgifter om antalet faktorer, som igår i de senaste modellerna ? Hur väl är relationerna mellan dem kända ? Hur många måste gissas ? Hur många iterationer gör man för att nå fram till år 2100 ?

Tacksam för någon form av uppgifter.

.

Thomas #29

Låter som du återigen inte har ngn bra dag. Någon desperation har jag svårt att se eller ens skönja på skeptiska sidan. Frustration? Ja, sådan finns det. Och säkert ilska också över sådant vi ’tvångsmatas’ med och dessutom avkrävs betalning för, samt att som salt i såret dessutom tvingas betala fantasiersättningar och -fallskärmar till den ’elit’ av puckon som genomdriver allt detta. Men desperation? Nej! Det är återigen ditt önsketänkande. Eller snarare din sidans allt starkare behov av att skylla alla de egna bristerna och problemen och även projicera dem på dem som pekar ut dem. Typiskt loser-beteende ..

Däremot tycker jag mig skönja viss desperation hos många (OBS inte alla) på din sida, dvs bland de klimathotstroende och klimathotsanhängarna, och då främst de ngt smartare bland dem.

Skocken med sheeple, stolleaktivisterna, tok- och miljövänstern, samt politiker, journalister och övriga grunda populister är nog för okunniga och tröga för att förstå alla ’varför’ och ’hur’ kring klimathotsdogmerna. Och förstår därför heller inte när dominobrickorna börjar falla.

Men de som vet vad de pratar och pratat om, de som är medvetna om vad de har hävdat (inte sällan ganska tvärsäkert) tidigare, och förstår innebörden av sina egna argument (och andras, de man tidigare borstat bort, avfärdat), de börjar visa upp tydliga tecken på desperation och sökande efter undanflykter och utvägar.

Bara en sån sak som att AGU för 4:e (!) gången går ut med samma sorts stöduttalande för ’climate change’ eller att NOAA mfl skickar ut pressreleaser om ’rekord’ innan de fått in all och ffa definitiv data. Och alla de som nu söker finna allt mer skruvade bortförklaringar om ’deep ocean hidden heat’ och plötsligt måste hänvisa allt mer till (de tidigare så förnekade) ’natural variability’. Eller 97%-nonsenset som nu (senast Cook et al) pushas av även dem som ägnat över decenniet att fnysa åt allt som inte gjorts av ’klimatforskare’ ..

Och (som Hans von Storch nyss satte fingret på), ju längre tiden går utan att temperaturen gör en alldeles formidabel spurtupphämtning, desto mer osannolik blir klimatmodellernas riktighet, och det blir de verkligen i ett rasande tempo när observationerna faller ur prognosernas angivna osäkerhetsintervall på undersidan.

De kunde (för en gång skull korrekt) hävda att: Det är mycket värre än vi nånsin trott ….

Så det är klart att desperationen börjar gripa omkring sig. Och inte bara det, den börjar lysa igenom och synas okcså …

Hej

Flera kommentarer berör det meningsfulla i långa beräkningar. Detta är helt korrekt då vädret är oförutsägbart för perioder längre än maximalt några veckor. Små initialfel, som är oundvikliga, växer snabbt och leder till att en prognos blir oanvändbar. Situationen är annorlunda vid en klimatberäkning ty där är man endast intresserad av klimatstatistik ( medelvärden, varians, extremvärden etc) och givetvis i ev ändringar i statistiken. Vill det bli mer extrema vädersituationer, vill episoder med torka bli mer vanliga, vill Sverige få mer nederbörd, vill antalet tropiska orkaner ändras etc. Eftersom vi har god erfarenhet att reproducera dagens klimatstatistik ( som vi kan validera) liksom gårdagens, finns det förhoppningar att även beräkna ändringar i ett framtida klimat där solemissionen, växthusgaser eller vulkaniska aerosoler är annorlunda än i dag Det är detta som är utgångspunkten för IPCCs modellberäkningar.

För en simulering mellan 1850 till 2100 krävs 20-50 miljoner tidssteg vilket säkert också förekommer vid andra typer av simuleringar inom fysiken ( solmodeller, simuleringar av kärnsprängningar etc.) Det inses av de flesta att beräkningar av aktuella geografiskt och tidsmässigt preciserade händelser är helt omöjligt med detta är inte avsikten med klimatberäkningarna. Men jag är inte helt övertygad att det finns personer som tror att detta är möjligt och i detta avseende har blivit missledda. De är i så fall att beklaga.

LennartB

Modeller!

Som militär kunskap, stämmer inte verkligheten med kartan, är det kartan som gäller!

Faktiska uppmätta värden angående temperatur, havsnivå, behagar inte följa modellen!

Vasaloppet på rullskidor? Nej!

Räven simmar över sjön? Ja sommartid!

Pulka till barnen är en okänd pryl? Nej inte vintertid!

Hur kan FN o politiker av annat skäl gå på denna klimatfantasi, annat om det inte vore för alla nya skatter och regler?

Valet i detta rike 2014, blir ovanligt intressant!

Vilka block skall fortsätta att hota och sälja återvinningsbara och klimat/hållbara tagelskjortor?

Lennart B

Initialfel som växet sig stora snabbt får även hos deterministiska system med väldigt få frihetsgrader (om de innehåller starka olineariteter eller bifurkationer). Dvs även om varenda faktor, samband och koefficient är kända exakt!

Klimatmodellerna lider av avsevärt större och allvarligare brister än att modellerna är numeriskt svåra att lösa annat än för korta tidshorisonter framåt.

Vidare är ju hela klimatmodelleringens raison d’etre att försöka följa hur dessa (olinjära) system ändras över tiden, när man skruvar på vissa parametrar.

Svårigheterna att få detta rätt har alls inte (bara) med numerisk precision eller behovet av korta tidssteg att göra! Istället är svårigheten att öht få de ingående mekanismerna (som samverkar olinjärt och kopplat) någorlunda rätt.

Lennart Bengtsson [37]; Det verkar inte finnas någon kongruens mellan det du påstår och vad klimatmodellerna syftar till. De säger oss att vi kommer att få en fortsatt global uppvärmning och vars prediktion är hundratals år framåt. Vi skall ställa om vår energiproduktion till att vara CO2-fri för att undvika en hotande framtida värme. Detta är något annat an vad du påstår. Modellerna används inte heller i ett vetenskapligt syfte, utan i stället i ett politiskt

Ingemar, mycket intressant blogginlägg om dessa nya artiklar!

Återigen kommer jag att tänka på Naomi Oreskes som faktiskt för många år sedan, innan hon började med vetenskapshistorien, inom sitt vetenskapsteoretiska forskningstema förutsade att klimatmodellerna skulle misslyckas på grund av komplexitetsparadoxen:

https://www.klimatupplysningen.se/2013/08/02/sommarrepris-varfor-kan-klimatmodellerna-inte-forutsaga-klimatets-utveckling/

Hon påpekade att det är en väsentlig skillnad mellan väder- och klimatmodeller i detta avseende eftersom vädermodellerna kan modifieras på basis av rikliga observationer inom de tidsskalor som är aktuella för prediktioner.

Detta med att man bör använda enkla modeller mera har jag sett i en annan artikel som diskuteras i följande blogginlägg:

https://www.klimatupplysningen.se/2013/01/04/klimatmodellernas-brister-enligt-klimatmodellerarna-sjalva/

Från ett citat från artikeln i detta blogginlägg har jag hämtat följande mening:

I synnerhet kommer vår förmåga att bättre förstå klimatets dynamik och fysik att bero på insatser för att förbättra den fysikaliska grunden för de avancerade klimatmodellerna genom att utveckla och använda ett spektrum av modeller av olika komplexitet och úpplösning och att utforma förenklade numeriska experiment fokuserade på specifika vetenskapliga frågor.

Jag tror att tanken är att man kan kringgå komplexitetsparadoxen genom först studera olika hypoteser med enkla matematiska modeller för att se om de kan ge en förklaring till observationerna. Om de gör det kan de sedan förfinas och arbetas in i de avancerade klimatmodellerna för att se om överensstämmelsen med observationer fortsätter och till och med kan bli bättre.

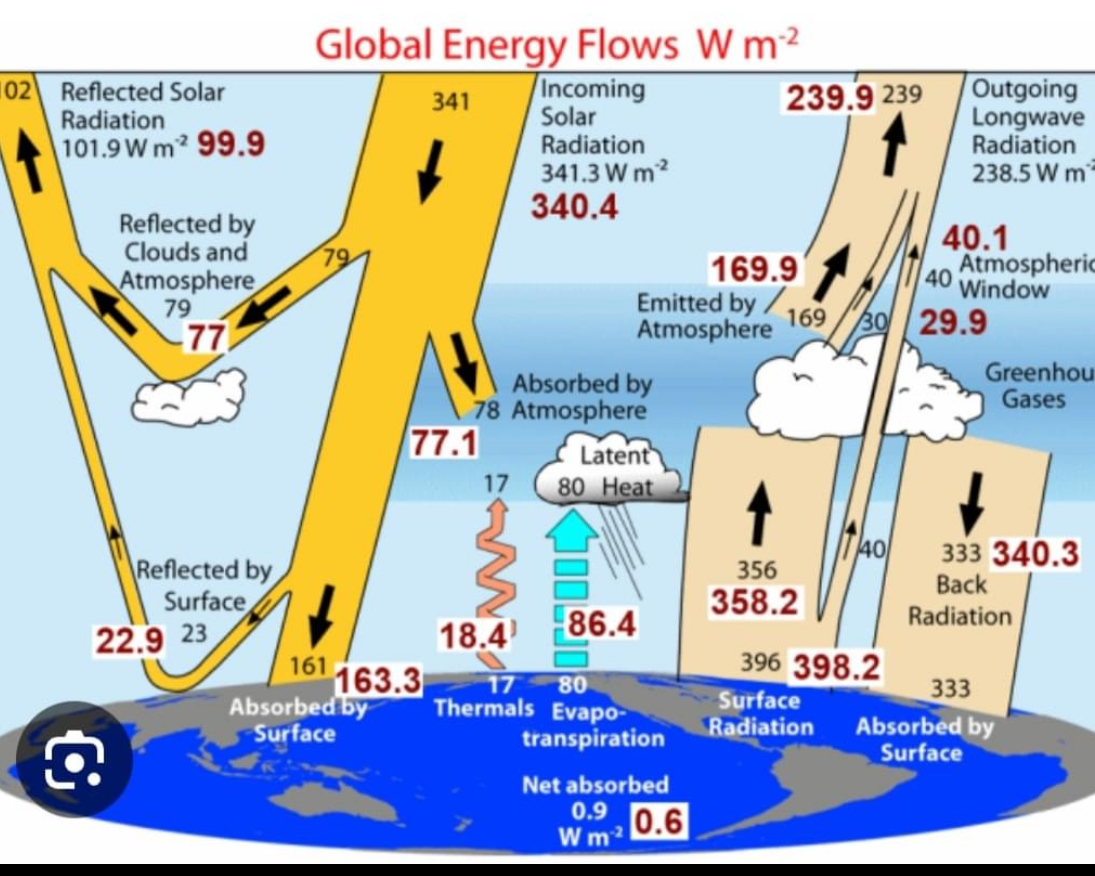

Man kan ta Svante Arrhenius enkla modell för jordens strålningsjämvikt som exempel. Den har förfinats och arbetats in i mer avancerade modeller som bekräftat förutsägelser om att växthusgaserna värmer jorden med cirka trettio grader. En mycket imponerande bekräftelse kom när man från satelliter kunde mäta upp spektrum för den utgående värmestrålningen från jorden.

Lennart B!

Från min horisont så har klimatmodellerna alldelesför dåligt med historiska obsevationer att gå efter.

Vad jag mer ser från min horisont är att alla förklaringar till större historiska klimatförändringar är av resonemangsarten och långt ifrån så fullständiga eller sammanhållna att de ger några bevis på klimathistoriken med avändbara algoritmer. Förklaringarna är mer att se som ad hoc och de olika gissningarna till bakomliggande orsaker till klimatets dalar toppar och enstaka händelser är lika många som det finns gissare. Ta bara medeltidsvärmen som IPCC hävdade var lokal vilket nu bevisats vara global. Jag hävdar att det är totalt meningslöst att jobba vidare med klimatmodeller när man är så uppenbart osäker om historikens olika orsaker.Man har helt enkelt tagit sig vatten över huvudet redan från början med klimatmodellerna och slarvat ihop vad man trodde sig behöva för att kunna bygga nåt av värde.

Därav kan inte vare sig hindcast eller prognoser valideras och när vi nu bara inom ett extremt kort klimatperspektiv redan hamnat så snett som modellerna gjort så ska vi nog mest diskutera användnings och tillämpningsvillkoren för modellerna. Om vi erkänner att klimatmodellerna är ett experiment i sin linda så är det användarna som är helt ute och cyklar och som utgör problemet.

Jag är övertygad om att ni lurar er själva när ni tror att ni kan skilja på ”långsiktiga” faktorer ifrån mer frekventa och korta. Då de kortare mer frekventa kan ändras och bli starkare och ändra förutsättningarna för de ”långsiktiga” eller ”övergripande” så skapar de trendbrott som gör att man då måste börja om på ny kula med helt nya förutsättningar. Det linjära tänkandet är en mänsklig svaghet som kopplas till tryggheten i att tro sig ha makt och kontroll och unika händelser har en förmåga att utraderas i tänkandet.

Hur avslutar man utvecklingen av en modell? Man får säga upp folk helt enkelt, för så länge utveckling pågår så släpper ingen av de inblandade tanken på att de skall funka och aldrig anser de sig ha kört fast. Det är bara ett ytterligare antal programeringsrader som skall till … sen så .. ska ni få se!

Pehr B #41,

Jag tror att tanken är att man kan kringgå komplexitetsparadoxen genom först studera olika hypoteser med enkla matematiska modeller för att se om de kan ge en förklaring till observationerna. Om de gör det kan de sedan förfinas och arbetas in i de avancerade klimatmodellerna för att se om överensstämmelsen med observationer fortsätter och till och med kan bli bättre.

Inom vetenskapsteorin finns ett problem som uppmärksammades först av P. Duhem i slutet av 1800-talet, och som sedan O Quine benämnde problemet med ”underdeterminerade teorier”. Med detta menas att givet en ändlig mängd observationer så kan du alltid konstruera flera (ja, ett oändligt antal) övergripande teorier som ”förklarar” alla observationer.

”Problemet”, om vi vill betrakta det som ett sådant och inte bara acceptera ett logiskt faktum, har ingen lösning. Men en metodologisk respons är att undvika att dogmatiskt hålla fast vid första bästa teori som stämmer med alla hittills tillgängliga observationer. Det är det misstaget som man har gjort inom den IPCC-dirigerade klimatforskningen utan att ha lyckats särskilt väl.

Den uppmärksamme läsaren av inlägget ovan noterar att de olika ”enkla modellerna” faktiskt är olika sinsemellan också. Det enda de egentligen har gemensamt är avsaknaden av CO2 som drivande faktor. De utgör en grupp av modeller som inte bara slår de avancerade, komplexa och tyvärr etablerade modellerna, utan som också i sin tur kan utgöra embryon för mer avancerade och förhoppningsvis bättre modeller.

Att modellerna, vare sig de är enkla eller komplexa, stämmer med historiska (omanipulerade) data är ju bara första steget i processen. Nästa steg är att försöka eliminera de felaktiga, en efter en. Tyvärr har politiseringen av klimatfrågan inneburit att man istället dogmatiskt håller fast vid en hög klimatkänslighet och fåfängt försöker försvara och bekräfta dessa felprogrammerade modeller. Och det kan man säker hålla på med i 100 år till på skattebetalarnas bekostnad.

Men det vore bättre om man öppnade upp för en pluralism beträffande ingående parametrar och även tillät klimatmodeller som bygger på andra antaganden än hög klimatkänslighet för koldioxid. Är det inte det som von Storch et.al. egentligen efterlyser? Det hade gett bättre förutsättningar för att klimatforskningen skulle komma vidare istället för att stå och stampa med samma hopplösa modellförutsättningar.

Ingemar #43,

Att Duhem höll på med sådant visste jag inte. I mitt ämnesområde är Gibbs-Duhems ekvation viktig:

http://en.wikipedia.org/wiki/Gibbs%E2%80%93Duhem_equation

Fantastiskt för övrigt att det finns så kvalificerade artiklar på Wikipedia.

Man kan simulera framlänges från år 1900…och se om decenniet blev som det blev…ingångsvärden för 1900 finns väl ?

Ingemar #43 ”De utgör en grupp av modeller som inte bara slår de avancerade, komplexa och tyvärr etablerade modellerna, utan som också i sin tur kan utgöra embryon för mer avancerade och förhoppningsvis bättre modeller.”

Det är precis det de inte gör! Vad skulle en modell som bara består av att man summerar några sinuskurvor utgöra embryo till? En modell som inkluderar än fler sinustermer?

Medan seriösa klimatmodeller baseras på verklig fysik, mätningar i atmosfären osv handlar det du plockade fram bara om rena kurvanpassningar med en massa fria parametrar. Totalt sterilt som vetenskap betraktat. Att de kan få bättre resultat för globala medeltemperaturen är pga att de enbart är konstruerade för att passa denna enda kurva.

Jag tycker det generaliseras lite väl mycket här.

En modell behöver inte vara avancerad för att vara användbar, eftersom enkla och avancerade modeller båda kan ha sina tillämpningar.

En enkel statistisk vädermodell är att förutsäga att vädret en viss månad är samma som det genomsnittliga vädret de senaste 20 åren (väder för mig är temperatur, blåst, nederbörd och eventuellt molnighet). Den modellen använder jag personligen för att planera semester mm. Den bygger på att det finns stora variationer mellan tex december och juli, som helt dränker de stokastiska variationerna.

Modellen kan dessutom skatta osäkerheten för de relevanta parametrarna. Dvs den kan tex förutsäga både hur varmt det är i genomsnitt en viss tidsperiod, samt hur mycket temperaturen kommer variera.

Denna enkla modell duger som alla förstår väldigt bra för väldigt många tillämpningar. Undvik tex skidsemestern i juni och badsemestern i december.

Vad är då vitsen med att kunna ge ”bättre” prognoser. Jo, det är att de blir noggrannare. I den enkla statistiska modellen så får man bara veta saker som ”i juni kommer det bli 10-15 soldagar”, ”i december kommer det snöa 1-5 dm” osv.

Vill man gå vidare och göra mer avancerade modeller så är poängen att minska osäkerheterna, dvs man vill kanske kunna säga vilka dagar det regnar eller hur varmt det blir en viss dag. Och då behöver man först skaffa sig observationer av nuläget och sedan gå på djupet och modellera den grundläggande fysiken (även om ren statistisk modellering säker fungerar till en viss grad även här).

Samma sak gäller klimatmodellerna. Den enkla regressionen är en bra grund för att skatta framtida temperaturer, givet att klimatet är någorlunda stationärt. Vill man ge mera precisa mått så får man försöka modellera den grundläggande fysiken i systemet.

Men problemet vi har idag är att de avancerade modellerna, vars syfte var att ge bättre noggrannhet, tvärtom är sämre än de enkla statistiska modellerna. Och då ligger man väldigt illa till.

Hans #45 Ingångsvärden är extremt svårt. Vi har inte exakta data för jordens temperatur, speciellt inte i haven, ens idag, och eftersom ”vädret” dvs de korta svängningarna på uppåt ca ett decennium är kaotiska till sin natur så kommer varje klimatmodell att snabbt divergera från verkligheten. Man kan som bäst få långsiktiga trenden och statistiska egenskaper rätt.

ThomasP #9

”Det är som att postulera änglar som puttar runt planeterna och därefter hävda att det då inte finns något utrymme för en gravitationskraft.”

Aha! Det är alltså at postulera änglar om man tror att det förekom klimatförändringar före 1850. Den teorin hade jag inte hört förut.

tty #49 ”Det är alltså at postulera änglar om man tror att det förekom klimatförändringar före 1850. Den teorin hade jag inte hört förut.”

Det hade inte jag heller förrän du just hittade på den…

Lennart Bengtsson #37

”Eftersom vi har god erfarenhet att reproducera dagens klimatstatistik ( som vi kan validera) liksom gårdagens,”

Vet du om någon klimatmodell som klarar av att ”förutsäga” uppvärmingen 1920-45 och avkylningen 1945-75? Jag har då aldrig sett någon.

ThomasP #50

OK. Vad berodde t ex den abrupta temperaturhöjningen 1715-1725 på då? Eller det extremt kalla 1740 inklämt mellant de varma 1739 och 1741? Eller hela MWP respektive LIA.

tty #52 Så länge vi har så stora osäkerheter i vad temperaturen faktiskt var vid dessa årtal så är det lite svårt att diskutera detaljer om varför den var sådan. Det finns en massa faktorer som kan påverka klimatet, speciell över så korta perioder som du drog upp, men det förändrar inte det ofysikaliska i att bara postulera en linjär trend.

På tal om simuleringar – denna bok ”The Physics of Wall Street” kanske kan intressera någon http://www.physicstoday.org/resource/1/phtoad/v66/i8/p50_s1?bypassSSO=1

Peter Stilbs #54

En annan intressant bok är The Misbehavior of Markets: A Fractal View of Financial Turbulence av fraktalforskaren Benoit Mandelbrot. Den ger en mycket bra bild av de ofta oöverstigliga svårigheterna med att modellera stokastiska processer.

Thomas P #46: Om en vad du kallar ”seriös” klimatmodell blir slagen av några sinuskurvor så skulle jag ifrågasätta min modell. Detta gör du uppenbarligen inte då du påstår att det kommer att bli betydligt varmare framöver. Klimatmodellerna duger inte att göra prognoser med. Felaktig klimatkänslighet, uteblivna processer, felaktiga processer, inga initialvärden, för dålig upplösning etc.. För komplex verklighet att modellera till prognoser med dagens kunskap.

Klimatmodellerna kan ändå ha ett vetenskapligt värde genom att de kan öka förståelsen av processer och kopplingen mellan dessa. Med andra ord scenarier som de bör kallas. Men politiserade IPCC använder dessa för att göra prognoser dvs förutsäga framtiden.

En stor varningsflagga är att ALLA modeller som IPCC refererar till för globala temperaturen är uppbyggda på samma sätt, har likadana brister och relativt liten spridning. Varför ligger ALLA modeller ovanför verkligheten? Uppenbarligen för att politiska krafter ger pengar till en homogen grupp forskare att utveckla klmatmodeller och undviker andra grupper. Alla IPCC:s valda klimatmodeller är ju en utveckling av väderprognoser med hög klimatkänslighet.

Per #56 ” Om en vad du kallar ”seriös” klimatmodell blir slagen av några sinuskurvor så skulle jag ifrågasätta min modell.”

Men snälla Per, är du inte medveten om att *alla* kurvor kan reproduceras med en summa av sinuskurvor? Skillnaden är att Solheim och Humlums kurvanpassning inte kan göra några realistiska förutsägelser, inte säger någonting alls om någon annan aspekt av klimatet än just den globala medeltemperaturen och inte innehåller någon som helst relevant fysik.

”Varför ligger ALLA modeller ovanför verkligheten?”

Vi har många klimatmodeller så vi kan få ett begrepp av medelvärde och spridning av deras resultat. Hade vi också många jordklot skulle vi på samma sätt kunna få medelvärde och spridning av deras klimatutveckling vilket skulle gjort det lätt att bedöma modellernas kvalitet. Nu har vi tyvärr bara ett jordklot och det finns ingen anledning att tro att dess klimat kommer att följa medelvärdet av en tänkt ensemble. Kanske är det så enkelt som att jordens temperatur just nu ligger en bit under medelvärdet, och då är det inte konstigt att det även ligger under klimatmodellernas medelvärde.

Thomas Palm #57: Kanske är det så ännu mycket enklare som att du har fel och har haft så hela tiden. Hans von Storch et. al. säger att det är 98% sannolikhet att du har fel. Klimatmodellerna tar hänsyn till naturliga svängningar eller hur? Pratet om jordens medelvärde verkar som desperat bludder. Jordens globala temperatur ändras hela tiden – något riktvärde finns inte. Beroende på intervall kan valfritt värde erhållas. F.ö. har det sista millemiumet varit ett av de kallaste sedan sista istiden.

Allt fler forskare säger att det finns allvarliga systematiska fel i klimatmodellerna. Dags att komma ut ur garderoben Thomas och säga det även du!?

Vill vi veta hur framtiden ser ut om 100 år eller därbortom?

Vill vi är det bara modeller vi kan förlita oss till. För spågummor eller kristallkulor kan vi väl ändå lämna därhän. Modeller som förhoppningsvis så småningom fångar vad som tillförs, reflekteras och omfördelas av den energi solen levererar och som bestämmer vår temperatur och vårt klimat.

Vill vi inte är modellerna, forskningen och allt annat som strävar mot denna kunskap naturligtvis oönskade inslag som måste undanröjas eller minimaliseras.

molnbildningen är dåligt känd

påverkas den av kosmisk strålning? Hur varierar den?

IPCC avlidna nestor Bert Bohlin tyckte det var naivt och ansvarslöst att överhuvud taget föra sådana möjligheter på tal

havens uppvällande av kalla eller varma vattenmassor… hur exakt är kunskapen om dem?

när var och hur kommer vulkaner att få utbrott i framtiden?

månens påverkan på jordens atmosfär, vad vet man om den?

när infaller nästa istid? Varför blir det istider?

Det är bara några få av alla faktorer som måste in i modellerna. De måste skattas korrekt! Felfritt!

Annars blir slutsumman fel. Om man höftar till angående molnens påverkan och havens fördelande av värme eller kyla blir det fel. Samma om man förnekar existensen av en faktor som mycket väl kan ha stor betydelse för klimatets utveckling, som till exempel den kosmiska strålningen, om IPCC misstar sig där blir det också fel.

Oundvikligen.

Om jag ska räkna ut medeltemperaturen för områdena norr om polcirkeln, men bara har uppgifter från tre-fyra termometrar uppställda på flygplatser i Baffin Island så kan statistikern ”interpolera” dvs höfta fram temperaturerna på andra platser i området och därefter med dem och de tre-fyra angivelserna från flygplatserna göra sin medeltemperaturberäkning. Resultatet blir fel. Oundvikligen.

Om jag ska räkna ut vad TP betalade sist han var på ICA och jag vet att han köpte 15 chipspåsar á 15 kr, 4 alladinaskar á 32 kr, 5 hg räksallad (fy vale) á 10 kr/hg men inte om han köpte kaffe eller te och inte hur mycket mjöl, jäst, socker och mjölk han köpte, kan jag ju alltid försöka mig på en gissning och sedan summera. Resultatet blir fel. Av samma orsak som kimatmodelleringarna, viktiga fakta saknas.

När IPCC och Metoffice köper in datorer med än större beräkningskapacitet leder det till att felen blir exaktare och bättre uträknade, mer tillförlitligt felaktiga. Metoffice framtidsprognoser via den nya superdatorn stor som en gymnastiksal, är det bästa beviset på detta.

Visst var det så att när man lät olika datorer beräkna klimatmodelleringarna blev slutresultaten olika?

Om man singlar slant om hur det framtida klimatet kommer att gestalta sig och ställer rätt frågor till slanten varje gång man kastar så tror jag, på allvar, att man får bättre resultat än de bidragsberoende klimatprogrammerarna hittills lyckats åstadkomma. Bättre, i alla fall inte sämre, och billigare.

”Men det är det bästa vi har, förstår du” var det en i TCS:s debattgäng som förklarade väldigt omsorgsfullt och tydligt för mig för något år sedan.

Ändå pekade ALLA klimatmodellerna käpprätt fel. Då tycker jag: En spade av mjukplast fungerar inte över sig bra i styv jord. Har jag något vett i skallen byter jag till en spade av järn och pratar mindre om att spaden av mjukplast är det bästa vi har.

Thomas P #57

Du skriver

”Vi har många klimatmodeller så vi kan få ett begrepp av medelvärde och spridning av deras resultat. Hade vi också många jordklot skulle vi på samma sätt kunna få medelvärde och spridning av deras klimatutveckling vilket skulle gjort det lätt att bedöma modellernas kvalitet.”

”Nu har vi tyvärr bara ett jordklot och det finns ingen anledning att tro att dess klimat kommer att följa medelvärdet av en tänkt ensemble.”

””Kanske är det så enkelt som att jordens temperatur just nu ligger en bit under medelvärdet, och då är det inte konstigt att det även ligger under klimatmodellernas medelvärde.”

Ja jösses!

Vi har bara ett jordklot, och det kan ju inte ensamt följa i de fina klimatmodell-ensemblernas fotspår, som spretar iväg åt alla håll.

Verkligen otur, för klimatmodellerna vet ju bäst, eller hur? Jämrans jordklot!

Thomas, läser du någon gång vad du själv skriver? Är det ditt sinne för humor som driver dig, eller bara ren och skär enfald?

Jag tycker du skall nominera dig själv till http://sv.wikipedia.org/wiki/Tage_Danielsson-priset

Du är i mästarklass!

*tty

Detta är inte ovanligt i klimatsimueringar. Se ex min artikel i Ambio 1997 från Arrheniussymposiet. Men det är ju som jag försökt förklara inte möjligt att simulera detta vid en given tidpunkt, då det bara är den statistiska strukturen som är reproducerbar. Se också min artkel i Tellus från detta år med titeln ” What can the cliate system do on its own”

Klimatet är ett dynamiskt kaotiskt system. Vad vi hittills observerat är bara en möjlig utveckling av ett godtyckligt antal andra utvecklingar precis som mänskliga historien. Däremot har vi en ökande kunskap och förståelse inom vilka gränser dessa variationer är möjliga. Det är ändringar i dessa gränser som man försöker att bättre bestämma med avancerade modellberäkningar

LenartB

Per #58 ” Klimatmodellerna tar hänsyn till naturliga svängningar eller hur?”

Klimatmodellerna förväntas få med naturliga svängningar i statistisk mening, dvs hur stora de är. De förväntas *inte* kunna reproducera exakt vilka svängningar jordens klimat genomgår. Om jorden just nu genomgår en slumpvis period av kallare klimat så är det inget vi väntar oss se i klimatmodellerna.

Börje #60 ”Har jag något vett i skallen byter jag till en spade av järn och pratar mindre om att spaden av mjukplast är det bästa vi har.”

Om du kan köpa en spade av järn var uppenbarligen inte plastspaden den bästa. Var hittar du motsvarigheten för klimatmodeller om du nu anser de vi använder vara så dåliga?

Pelle #61 Det är tråkigt att diskussioner så lätt hamnar över din intellektuella horisont, men det borde vara något du är van vid.

P.S. Eftersom det är populärt att leka språkpolis här. Det retar mig när folk skriver som Per: ”F.ö. har det sista millemiumet varit ett av de kallaste sedan sista istiden”, om han nu inte verkligen menar att jorden kommer gå under snart så det inte blir några fler millennier eller istider. Annars heter det ”senaste”.

#60 Börje S tar upp molnbildningen och den kosmiska strålningen som en möjligen viktig faktor för klimatet. Jag tycker det är konstigt att detta fenomen inte studeras mer ingående. Redan i Realskolan (så gammal är jag!) fick jag en dimkammare demonstrerad och kunde med egna ögon se några vita streck som uppkom ur tomma intet. I samband med att jag på 70-talet tog ett flygcertifikat läste jag en meteorologikurs. Molnbildningen uppstår när luftfuktigheten är den rätta men det behövs ”kondensationskärnor”. Det var spår efter dessa kondensationskärnor jag såg i dimkammaren. Den kosmiska strålningen är, som jag förstår det, väsentlig för molnbildningen. All kan känna skillnaden i temperatur mellan en molnig respektive stjärnklar höstkväll.

Thomas P #63

Ja, det mesta jag är medveten om är sådant som ligger över horisonten.

Varför skulle det vara tråkigt?

Det är värre med det som är under eller bortom horisonten.

Det kan jag ju inte se, så det passerar lätt obemärkt.

Det var så du menade eller hur, du intellektuella gigant 😉

A scientific experiment by one of the world’s top scientific laboratory showed that cosmic rays affect cloud formation … which in turn affects climate.

How could climate scientists be wrong about the factors which go into climate change?

Science is not a one-time, all-or-nothing endeavor. It is the process of refining our understanding of the universe and – if our model doesn’t fit reality – adding details or changing the model altogether.

And even well-known, well-intentioned scientists sometimes push incomplete or counter-productive ideas.

For example, top scientists, government agencies and publications have – for over 100 years – been terrified of a new ice age. (And – in the ”for what it’s worth department”, NASA said 7 months ago that we could be on the verge of another solar minimum.)

Well-known scientists considered pouring soot over the Arctic in the 1970s to help melt the ice – in order to prevent another ice age. That would have been stupid.

Even Obama’s top science adviser – John Holdren – warned in the 1970″s of a new ice age … and is open to shooting soot into the upper atmosphere. That might be equally stupid.

We have to think like true scientists … and learn from our mistakes.

See more at http://www.zerohedge.com/contributed/2013-08-14/scientists-gain-new-insight-climate-change-and-what-do-about-it

#63

Detta är faktiskt det sista millenniet vi (inkl. Per) så som skriver här kommer att uppleva… 😉

Kanske bättre då att reta sig på dem som har dålig pejl på vilket år millenniet började.

Har SMHI fått värmeslag? Hur kan de underlåta sig att skriva om klimatförändringar?

I söndags orsakade ett annat oväder stora problem i södra Norrland, bland annat var det nära att en bro föll ihop i Söderhamn. Telefoner slutade att fungera och över 20 källare vattenfylldes. Enligt SMHI är det vanligare med översvämningar vid den här tiden på året.

– Det beror på att luften är fuktigare, då blir skurarna kraftiga och det åskar mer, säger Marcus Sjöstedt.

Lokalt kan också den torra marken göra att översvämningarna blir värre, eftersom torr mark inte suger upp så mycket vatten.

Den kosmiska strålningen regleras enligt Svensmarks teori av Solens magnetfält, så att vid hög solaktivitet hindras den kosmiska strålningen att nå fram till Jorden med mindre molnbildning och varmare på Jorden. Tvärtom vid låg solaktivitet. Magnetfältet ändras i takt med solfläckscykeln som i sin tur förmodligen beror på dynamon i Solens centrum, vilken styrs av Solens rörelse runt barycentrum. Rörelsen runt barycentrum beror på planeterna, främst Jupiter och Saturnus. Detta är periodiska förlopp och därmed borde det gå att hitta periodicetet i klimatet.

Det kan tilläggas att Solens magnetfält ändrar polaritet vid varannan solfläckscykel så att man kan säga att en solfläckscykel egentligen är 22 år. När Jordens och Solens magnetfält är riktade åt samma håll förstärks effekten och när de är motrikade försvagas effekten (att hindra kosmisk strålning från att nå fram till Jorden).

Thomas P #63: Du kommer ha stor framgång som språkpolis. Bättre än som politisk polis under täckmantel vetenskap. Du har talang för detta. Tack för att du hittade detta språkliga fel på min text. Så tråkigt att du blir uppretad av att jag skrev ”sista” i.st. för ”senaste”. Den vetenskapliga delen har du mindre framgång med. Men nu gäller det att hitta ny sysselsättning innan AGW-hypotesen helt rasat ihop. I PK-samhället borde det finnas ett stort behov av språkpoliser. 🙂

Faktum är att polväxlingen i solens magnetfält sker under solmaxima, vilket innebär att just magnetfältets polaritet är som lägst då. Sedan kan jag inte uttröna vilket håll som är med eller motriktat mot jorden?

http://www.leif.org/research/Solar-Polar-Fields-1966-now.png

Men av erfarenhet var ju somrarna fina under 70- / 90-talet, så det är väl dags igen nu 2010-talet.

Jag antar att det är detta som kan observeras som Bz component på

http://www.swpc.noaa.gov/SWN/

Stora systematiska feltolkningar av trädringsdata!

Wuwt uppmärksammar denna artikel och jag tycker det viktigaste tolkningen av den är större än artikeln i sig. Hur kan man under så många år använda trädringsproxi UTAN att kontrollera dessa basala systematiska problem? Klimatvetenskapen är ju en ren lekstuga!!

http://www.clim-past-discuss.net/9/4499/2013/cpd-9-4499-2013.pdf

Angående artikeln ovan…

jag ska läsa hela artikeln i kväll men bara inledningen ….. pust!!

Analyzing 1200 randomly selected published chronologies, we find that regional

20 curve standardization is improved by adding an effect for individual tree productivity

in 99 % of cases, reflecting widespread differing-contemporaneous-growth rate bias.

Furthermore, modern sample bias produced a significant negative bias in estimated

tree growth by time in 70.5 % of chronologies and a significant positive bias in 29.5 %

of chronologies. This effect is largely concentrated in the last 300 yr of growth data,

25 posing serious questions about the homogeneity of modern and ancient chronologies

using traditional standardization techniques.

CRU kan lägga ner!!

Slabadang #73 Ja, varför skall man bekymra sig över att läsa hela artikeln, än mindre se responsen från andra forskare inom området innan man börjar ropa på att lägga ned CRU,

Skit in skit ut!

Judith Curry har en artikel där hon diskuterar argumenten om ”bästa tillgängliga bevis” som har sina varianter i ”kunskapsläget” ”massor av bevis” och borrar i kriterierna för vilka bevis som ligger till grund för dessa påståenden. Det är som att skala en lök med lager av cirkelresonemang innan man kommer till kärnan, och när sista lagret är avskalat hittar vi ett tomrum. En mycket intressant debatt!

Hon rekommenderar denna artikel som finns bakom betalvägg som beskriver skillnaden mellan hur flygindustrins konstruktörer jobbat fram sin mjukvara för sina utvecklingsmodeller och jämför ( Hjälp!) med klimatmodellerna. Värt att uppmärksamma är samtidigt skillnaden i ansvar för både ekonomi funktion och säkerhet vis avi Colin Jacksson på Rossbycenter.

Artikeln:

http://onlinelibrary.wiley.com/doi/10.1029/2012EO440006/abstract

Judy C bjuder på ett utdrag ifrån artikeln:

http://judithcurry.com/2012/10/31/climate-data-records-maturity-matrix/

Det är inte bara här som diskussionens vågor går höga runt modellering,

http://notrickszone.com/2013/08/15/vahrenholt-thrashes-leading-ipcc-former-ncar-scientist-in-hamburg-debate-the-wound-of-climate-science/

…så även i Tyskland.