Joshfiguren ovan har jag valt för att jag tycker den är kul – notera att i mittfiguren slår han med en hockeyklubba!

Dagens inlägg handlar egentligen om motsatsen. Dvs jag har valt att referera en artikel som illustrerar hur lite våld det krävs för att få en god anpassning, om man gör rätt anpassning.

Artikeln är av David H. Douglass ”The Pacific sea surface temperature” Physics Letters A (2011) , doi10.1016j.physleta.2011.1.042. Författaren är den person som tillsammans med bl a Fred Singer publicerat arbeten om frånvaron av växthuseffektens signatur 8-12 km upp i jordens atmosfär.

Arbetet analyserar förändringar i Stilla havets yttemperatur i en viss zon kallad region 3.4: latitud 5 S till 5 N, longitud 120-170 W. Detta kan synas som en mycket liten del av jordytan. I gengäld har har man där gjort temperaturmätningar sedan 1870 och har identifierat dessa som nära korrelerade med ENSO-variationerna. Dessa har i sin tur betydelse för det globala klimatet. Figuren nedan är en del av resultaten, månadsmedelvärden för 1950-2011: En till synes mycket oregelbunden variation mellan 24 och 30 oC. Man kunde naivt hoppas på en årstidsvariation, men eftersom region 3.4 ligger kring ekvatorn blir den inte särskilt tydlig. Med lite god vilja kan man likväl urskilja 10 maxima och minima per decennium, men på rejält olika nivå. Genom att koncentrera sig på t ex de starkaste maxima kan man för åtminstone några av decennierna ana en period på 2-4 år – om än inte vidare regelbunden.

Figur 1a i ovan citerade arbete av Douglass.

Figur 1a i ovan citerade arbete av Douglass.

Det är en sådan identifikation av mindre frekventa variationer, dvs med period längre än ett år, som Douglass nu gjort. Tidigare arbeten, även så långt tillbaka som Bjerknes 1969, har rapporterat en 2-årsvariation korrelerad med huvudminima i östvinden.

Douglass inför två numeriska filter : NL för årsvariationer och NH för längre perioder och kör mätdata genom dessa, vilket ger dramatiskt olika resultat.

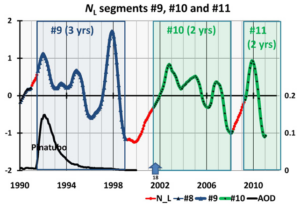

Douglass motiverar detta med uppträdandet hos en olinjär 1-dimensionell oscillator. En del av diskussionen ligger över min nivå i signalteori, men ett huvudresultat är att en sådan kan uppvisa subharmoniska frekvenser, dvs perioder om 2, 3, 4, 5 …år. Vilken av dessa perioder som faktiskt uppträder, och vilken fasrelation den kommer att ha till huvudperioden 1 år är känsligt beroende av yttre störningar. I figuren nedan citeras ett av resultaten: Tidsperioden 1990-2011. Den omfattar segmenten nr 9 – 11 av sammanlagt 11, som Douglass funnit från 1885 – 2011. I det blåa intervallet #9 har NL givit periodtiden 2 år och i de gröna ##10 och 11 är den 3 år. De röda delarna av kurvan är de som inte kunnat anpassas till någon enstaka subharmonisk frekvens. De uppträder typiskt i skarven mellan två segment och är kaotiska. Douglass noterar också att intervallskarvarna sammafaller med de “klimatskift”, som tidigare påtalats av honom och andra forskare. Den svarta nedre kurvan är “AOD-index” som beskriver förekomsten aerosoler, som orsakats av vulkanutbrott. Detta är ett exempel på en slumpmässig yttre störning som ändrar period och fas hos den totala variationen.

Figur 2e i ovan citerade arbete av Douglass.

En uppseendeväckande slutsats i artikeln är att inom ett segment är temperaturutvecklingen i någon mån förutsägbar. Douglass formulering: “If the climate system is known to be in one of these phase-locked states, limited predictability is possible.” Det innebär att inom respektive segment är den subharmoniska perioden en av 1- 4 år, och fasförhållandet mellan denna och 1-årsperioden är fixerat. Det är endast de röda kurvdelarna som verkligen är kaotiska på grund av olinearitet och störningar. Ett viktigt ‘aber’ är dock kravet “is known”. Det är inte trivialt att i inledningen av ett segment se vilka periodtider och fasförhållanden som gäller. Vi måste också besinna att denna ev förmågan att spå, gäller för ett begränsat antal år i ett delområde av Stilla havet. Icke desto mindre tycker jag att arbetet är ett väsentligt framsteg. Denna harmoniska analys är betydligt mer förtroendeingivande än GCM-modellernas metodik. Dessa beror av ett stort antal parametrar vars värden varieras i olika anpassningsprocedurer. Parametrarnas siffervärden kan inte testas på ett stringent sätt, utan det är tvärtom så att modellen körs ett stort antal gånger och sedan beräknas medelvärdet av resultaten. Detta rapporteras som ett ‘scenario’, vilket sedan i media kallas “prognos”.

För TCS läsare är det också intressant att jämföra med Pehr Björnboms inlägg + kommentarer om polynomanpassning för en tid sedan. Det visade hur väl man kan anpassa en temperaturkurva till en summa av ett begränsat antal polynom av 1:a till 3:e graden. Pehr framhöll tydligt att värdet med dessa beräkningar är att man kan identifiera variationer på olika tidsskalor. Polynomen har däremot ingen relation till klimatfaktorernas variation, så de kan inte utnyttjas för prognoser. Sinusfunktionerna i Douglass beräkningar är däremot direkt kopplade till årsrytmen och dess undertoner.

Jag mailade Douglass om artikeln och frågade bl a hur det kom sig att atmosfärens koldioxidhalt inte ens nämns i texten, och än mindre förekommer i beräkningarna. Han svarade “…what I was studying is not particularly sensitive to CO2. “ Så mycket, för det till leda upprepade och felaktiga påståendet att ökningen av atmosfärens koldioxidhalt är nödvändig för att förklara klimatet under 1900-talet.

Imorgon kommer jag att referera en annan artikel, som har med harmonisk analys att göra. Den har därför flera beröringspunkter med dagens, men också viktiga skillnader.

Har arbetat med ”modellbygge” i industriprocesser i skogsindustrin. För de komplexa processer som där gäller (kombination av kemiska, energimässiga och fysiska variabler) är erfarenheten, att många parametrar ger god anpassning till historiska data, dock upphör prognosvärdet snabbt, när nya mätdata matas in i modellen, främst beroende på olinjäriteter och mätosäkerheter. Bättre då, att reducera antalet parametrar och acceptera något osäkrare prognosutfall.

Holmfrid #1

Naturligtvis håller jag med om att det finns god anledning att hålla antalet anpassningsparametrar lågt. Med tillräckligt många kan man få en perfekt anpassning till kända data – men inget prognosvärde förframtida sådana.

Men du tror väl inte att GCM-modellerna klarar sig UTAN anpassningsparametrar? Den mest ökända är förstärkningsfaktorn i klimatkänsligheten.

C-G

Det är intressant att se att man använder nya grepp som signal- och fourier analys på empiriska klimatdata. Det är också intressant att Douglass i sin artikel inte nämner ett ord om CO2 och konsekvent anger solen som forcing. Alltså, analyserad data är en funktion av solen. Sen är det också intressant att se att han också har försökt filtrera ut påverkan av vulkanutbrott.

Artikeln analyserar ju El Nino/La Nina svängningar med höga svängningsfrekvenser så det är väl inte så konstigt att CO2 som ger en långsiktigt trend inte ingår i analysen. Att solen ger ger en 1-års komponent och att lägre frekvenser också kopplar till årstiderna är väl inte konstigt. El Nino startar väl i jultid.

Att ta frånvaron av CO2 i denna artikel som ett belägg för att Co2 inte behövs för att förklara 1900-talets klimat är rätt roligt, jag ser inte den kopplingen, artikeln handlar ju inte om detta.

Jag kan hålla med om att ”modellering utan fysik” är ett intressant och välbeprövat alternativ (identifiering av black-box modeller) och gör man det på hela 1900-talets temperatur blir man rätt övertygad om att CO2 är en trolig förklaring till huvuddelen av temperaturökningen, och att solen utesluten som förklaring.

Stickan #4

Nej, det är absolut inte konstigt ty koldioxiden har inte den stora effekt som hävdas i media!

”Att ta frånvaron av CO2 i denna artikel som ett belägg för att CO2 inte behövs för att förklara 1900-talets klimat är rätt roligt, jag ser inte den kopplingen, artikeln handlar ju inte om detta.”

Nej just det – den handlar inte ett dugg om CO2, men likväl återger den viktiga delar av de variationerna som man mätt upp.

Och hur kan du sedan påstå att ”gör man det på hela 1900-talets temperatur blir man rätt övertygad om att CO2 är en trolig förklaring till huvuddelen av temperaturökningen, och att solen utesluten som förklaring.”?

Tvärtom, det är när man betraktar hela 1900-talets temperaturkurva, som man utan avancerade analyser och anpassningar kan se att CO2 i atmosfären inte kan ha haft en avgörande betydelse. CO2-halten har stigit monotont, särskilt sedan 1945, under det att temperaturen gått ner under tre perioder. Läs gärna mitt tidigare inlägg om den dåliga korrelationen från slutet av juni, och titta på första figuren (Phil Jones) i morgondagens inlägg.

Vänliga hälsningar

C-G

Är detta den artikel där Douglass startar med att applicera ett högpassfilter som genom sin konstruktion filtrerar bort alla långsamma trender? I så fall är det ju inte underligt om CO2 inte kommer in i bilden.

C-G#6

Douglas högpassfiltrerar temperaturen så att alla frekvenser med längre period än 1-år försvinner (t.ex den långsiktiga uppvärmningen). Den resterande lågpassfiltrerade signalen uppvisar subharmonics med perioder t.ex 2-, 3-år. Sen studerar han denna lågpassfiltrerade signal i kortare intervall för att se mönster och ev. predikterbarhet. Långsiktiga trender är inte ämnet för denna artikel.

Douglas pratar om solar forcings vilket är korrekt men det ger ju också en öppning för skeptiker att se stöd för sin favoritteori. Men då måste de läsa artikeln som f-n läser bibeln 🙂

Beträffande CO2 och 1900-talets temperatur så är korelationen slående, det finns dock andra input och intern dynamik som gör att den långsiktiga trenden är överlagrad med andra variationer. Man kan troligen genom harmonisk analys ta bort en del av dessa och se trenden tydligare. F.ö. Har ju de data som Douglass använder en tydlig uppvärmingstrend under åren 1950-2011 och den får han nog ta till CO2 för att förklara. Dock är havstemperturen i detta begränsa område mer varierande än om man tittar globalt och uppvärmningen bara hälften av den globala.

Se gärna det utmärkt pedagogiska exemplet om mannen och hunden för att förstå det här med trender och variationer http://www.skepticalscience.com/trend_and_variation.html

Douglass sysslar som sagt med variationer.

Med vänlig hälsning, Stig alias Stickan

Tomas #6

Hur kan du påstå att Douglass ”konstruktion filtrerar bort alla långsamma trender” – det är ju just 2-, 3- och 4-åriga variationer som är hans resultat? Se figuren ovan.

Stickan #7

Alldeles oavsett vilken potentat som läser bibeln – Du verkar läsa den som en nyfrälst? Jag kan tänka mig att Douglass valt, eller tvingats till, att inte explicit skriva något kritiskt om IPCC i sin text. Detta för att få den accepterad i anrika och -sedda Physics Letters.

Påståendet ”Beträffande CO2 och 1900-talets temperatur så är korelationen slående” är helt enkelt fel – korrelationskoeficienten är ”slående” låg även om man försökt med olika reaktionstider ”lag”.

Dessutom falsifierar det påståendet att CO2 dominerar som förklaring till klimatvariationerna under 1900-talet. Man har som sagt i efterhand kastat in diverse störningar för att förklara varför modellerna, baserade på denna dominans, inte stämt. Det innebära att störningarna väljes starkare än CO2-effekten. Mycket riktigt, så visar Scafetta (se dagens inlägg) att alla GCM-modeller överdriver effekten av Pinatubo utbrottet.

Detta är ett fint exempel på IPCC’s dilemma, som Ingemar Nordin skrev om häromdagen. Ju fler gånger IPCC tvingas reparera sina prognoser, desto mer underminerar man sitt eget påstående att det är CO2 som är huvudförklaringen.

Vänliga hälsningar

C-G

Korrelationen mellan CO2 och temperatur är slående, man får beakta att det finns annan dynamik och input i/till systemet också. Subtrahera Scafettas sinustermer så får du en strålande korrelation!

Stickan, korrelationen mellan temperatur och dubbdäck är också slående, liksom mellan temperatur och mikrovågsugnar… 😉

Stickan #9

.. och då finner du att ev trenden orsakad av CO2 är mycket mindre än vad som hävdas från IPCC m fl.

Hälsningar

C-G