Klimatkänslighetens storlek är kontroversiell inom klimatvetenskapen. Så kallade varmister (motsvarar den allt vanligare engelska benämningen warmists) som James Hansen menar att klimatkänsligheten är omkring S = 3 °C (per fördubbling av koldioxidhalten) vilket är mitt i IPCC:s intervall från 2007.

IPCC-skeptiska klimatforskare, kallister (mitt förslag på benämning), som Richard Lindzen och Roy Spencer anser att deras forskningsresultat visar på låg klimatkänslighet såsom S = 0,6 °C.

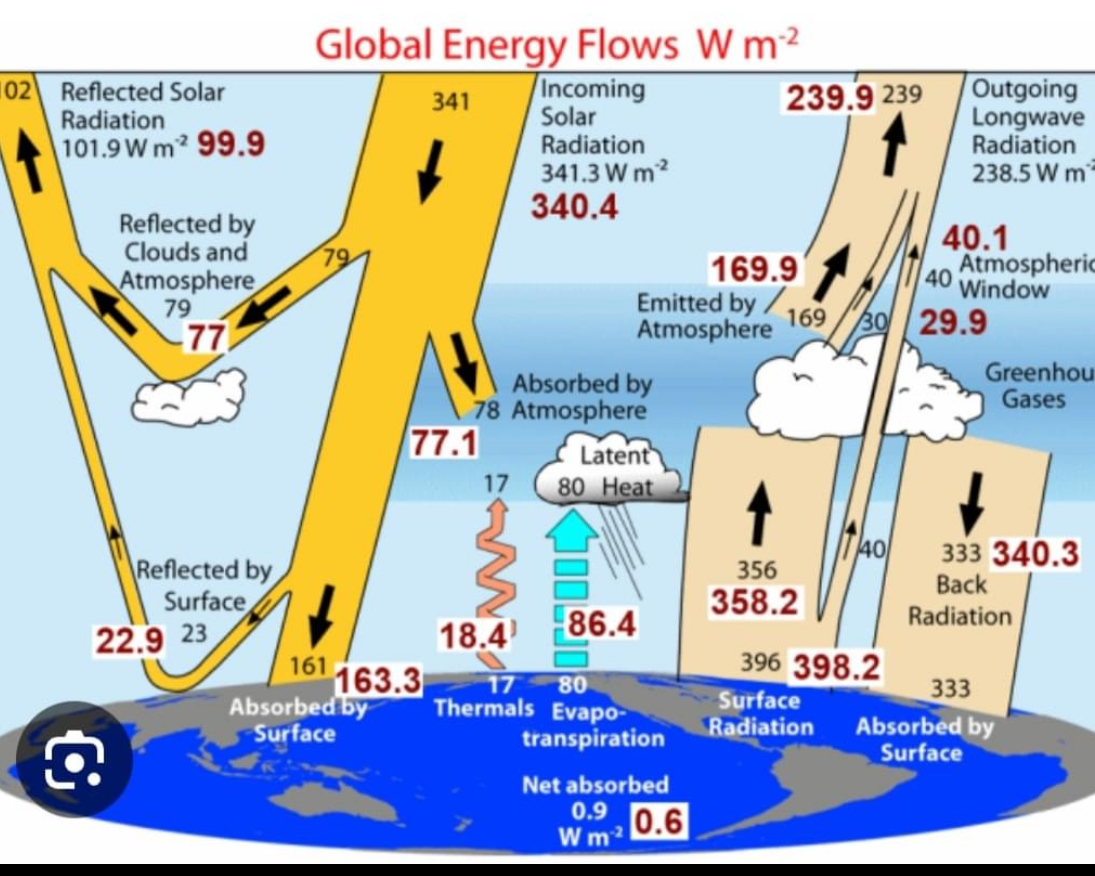

Figur 1 ovan visar resultatet av en räkneövning med den enkla klimatmodell, Energy Balance Model (EBM), som beskrivs i kapitel 8, Climate change, i den grundläggande atmosfärfysiska läroboken av Andrews (2010).

Frågeställningen för denna enkla räkneövning är att undersöka hur väl en hög klimatkänslighet S = 2,8 °C (Hansen) och en låg sådan S = 0,6 °C (Spencer) kan beskriva förra seklets klimatutveckling och vad konsekvensen blir om koldioxidhalten fortsätter att stiga exponentiellt. Data för temperatur och forcings från NASA:s databas GISS skall användas.

Resultatet är att både hög och låg klimatkänslighet inom ramen för EBM kan förklara det förra seklets temperaturutveckling. Låg klimatkänslighet ger inte oroväckande temperaturhöjning.

I fallet Hansen har forcings från GISS använts utan modifiering, vilket motsvarar James Hansens åsikter (aerosolernas kylande effekt enligt Hansen är mycket omdiskuterad).

I fallet Spencer finns även de interna naturliga forcings som enligt Roy Spencer har påverkat temperaturen, en cyklisk forcing från PDO och en under förra seklet linjärt ökande forcing.

Referenser

Andrews, D.G., 2010. An Introduction to Atmospheric Physics. Cambridge University Press. Second edition. Här eller här.

GISS-data. Forcings. Temperatur.

Detaljer om räkneövningen (pdf-fil)

Martina Krüger i svaromål mot Björn Lomborg.

http://www.sydsvenskan.se/opinion/aktuellafragor/article1517459/Det-finns-ingen-sammansvarjning.html

Ulrik.

Typisk halmgubbe. Inte möjlig att kommentera 🙂

Pehr,

Jag trodde att den cykliska forcingen från PDO var en vedertagen forcing. Är den inte med i Hansens modell?

I din PDF-fil missade du källhänvisning till Spencer. Var kommer de linjära och cykliska ändringarna i forcing ifrån och vad motsvar de som inte redan tagits med i Gissnet?

F.ö. tror Hansen på en total klimatkänslighet på sex grader, så om du vill använda begreppen ”kallist” och ”varmist” vore det rimligare att göra det för personer som ligger kraftigt under respektive över IPCC:s centrala uppskattning.

”om koldioxidhalten fortsätter att stiga exponentiellt”

Ska det inte vara linjärt?

För den som har en stund över, Vaclav Klaus, talar till samma församling som allas vår favorit Lord Monckton gjorde för nån’ vecka sedan, dvs. The National Press Club ”down under”.

http://www.youtube.com/watch?feature=player_embedded&v=idKceFvO7AM#at=38

Lejeune!

Jag tackar, susar och skrapar med fötterna

Vaclav Klaus is my hero!

Ingvar #3,

Nej, Hansen har inte med PDO-forcingen i sin värld. Han anser att den minskade temperaturen under 1950 – 1970 helt är en följd av den kylande inverkan från mänskliga aerosolutsläpp.

Varken Hansens avancerade klimatmodeller eller någon av de andra avancerade innehåller denna PDO-forcing som har att göra med samspelet mellan ocean och atmosfär. Därför kan heller inte de avancerade klimatmodellerna återge denna cykliska variation av temperaturen.

Pehr #8

Makalöst. Ju mer man hör desto mer övertygad blir man att IPCC:s modeller endast byggs för att övertyga om CO2-s inverkan.

Snake Oil salesmen!

Ulrik #1,

Synd att artikeln saknar kommentatorsfält. Annars vore det lätt att lätt att visa att Geenpeaceföreträdarens svar är fel. Greenpeaceaktivisten Teske har skrivit det centrala bidraget i rapporten som nästan alla andra kapitel refererar till. Vidare så är Teske med och skriver eller redigerar i nästan alla kapitel. Snacka om inflytande!

http://nigguraths.wordpress.com/2011/07/24/greenpeace-the-edenhofer-excuse/

Thomas #4

Som källa till Spencers tankegångar finns dels hans blogg, dels hans bok om den stora blundern. Den stora blundern är just detta att man inte har tagit hänsyn till dels inverkan av PDO, dels att det kan ha skett en naturlig uppvärmning parallellt med den uppvärmning som växthusgaserna gett upphov till. Om man tar hänsyn till dessa faktorers inverkan under förra seklet måste klimatkänsligheten ha varit låg.

Hansen har sagt att klimatkänsligheten mellan två jämviktstillstånd är 6 grader. För detta har han blivit kritiserad av Gavin Schmidt. Många klimatforskare, till exempel Lennart Bengtsson, anser att begreppet jämviktsklimatkänslighet saknar reell mening eftersom klimatsystemet aldrig är i jämvikt och eftersom denna hypotetiska storhet endast kan bestämmas med hjälp av avancerade klimatmodeller som integreras över många tusen år, och detta är omöjligt, i varje fall än så länge (denna åsikt innebär för övrigt ett underkännande av de metoder som Hansen har använt i sina istidsstudier).

Min räkneövning avser korta tider där Hansen har angett klimatkänsligheten till 2,8 grader per 3,7 W/m2 och så mycket högre kan man förmodligen inte gå om man skall kunna få förra seklets temperaturutveckling att stämma med Hansens egna forcings utan modifiering.

Lägg märke till att Hansens kylande forcing från mänskliga aerosoler och Spencers värmande naturliga forcing blir relaterade vid en viss klimatkänslighet. Om man minskar på Hansens kylande forcings så måste man också minska på Spencers värmande dito om man skall få överensstämmelse med förra seklet i fall Spencer med klimatkänsligheten 0,6 grader.

Hansens kylande forcings är faktiskt mer kylande än vad Spencers värmande naturliga forcing är värmande.

Min räkneövning är inte avsedd som publicerbart vetenskapligt arbete utan som en pedagogisk illustration till klimatmodellen EBM enligt Andrews lärobok i atmosfärfysik och vad man kan göra med en sådan modell.

Men det är intressant att beräkningen med låg klimatkänslighet enligt Spencer ger en kurva som så mycket liknar Loehles och Scafettas kurva i föregående bloggpost av Lena Krantz och då har kurvorna ändå beräknats med två olika metoder. Loehle och Scafetta har använt en slags signalbehandlingsmodell medan EBM som jag använt är en erkänd atmosfärfysisk modell som ingår i elementära läroböcker i ämnet atmosfärfysik.

Pehr.

> Loehle och Scafetta har använt en slags signalbehandlingsmodell medan EBM som jag använt är en erkänd atmosfärfysisk modell som ingår i elementära läroböcker i ämnet atmosfärfysik

Bulls Eye!

Ingvar #12

Bulls Eye!

🙂

Detta blev för mig också¨ett märkligt sammanträffande.

Jag fick reda på Loehles och Scafettas vetenskapliga artikel igår i och med att Lena skrev sin bloggpost som ligger precis före min här.

Men mina egna beräkningar gjorde jag förra veckan och jag gjorde en tidsinställd publicering av min bloggpost här den 25:e juli med publicering idag på morgonen. Så jag visste ingenting om Loehse och Scafettas artikel när jag skrev texten ovan.

Pehr.

C. G. Jung och Pauli. synkronicitet

🙂

Pehr, vill du nödvändigtvis ge namn så blir det ”kallist” åt folk som Spencer och Lindzen, ”mainstream” åt Bengtsson, ät ”varmist” åt Hansen och Lovelock.

Du talar om inverkan av PDO, men hur beräknar du forcing från denna? Aerosoler är något väldefinierat, man kan mäta hur mycket de kyler, men PDO är mest ett namn.

Än konstigare är den där linjärt ökande forcingen. Var kommer den ifrån? Varför upphör den 2003? Det är klart att om man postulerar att delar av uppvärmningen är naturlig så blir effekten av CO2 mindre enligt just denna modell, men det är numerologi inte fysik. Tänk om det istället skett en naturlig avkylning under 1900-talet, då blir med samma analys klimatkänsligheten hög.

Precis som Loehle och Scafetta inför du en godtyckliga cykliska och linjära termer och kan då få i stort sett vilket resultat som helst.

Det är inte exakt samma modell som Pehr tar upp, men här en diskussion om hur Spencer räknat i sin bok:

http://bbickmore.wordpress.com/2011/03/01/roy-spencers-great-blunder-part-3/

Det inger inte så stort förtroende.

Pehr #11

Ja det var onekligen ett rätt märkligt sammanträffande och att kurvorna är så extremt lika varandra.

Men det går förmodligen att räkna på många olika vis och från olika synsätt men ändå komma till ungefär samma resultat.

Har lyssnat på Vaclav Klaus. Utbildad och kunnig ekonom. Har även arbetat med ekonomisk datamodellering i 12 år. Lågmäld. Duktig föredragshållare utan en enda bild. Långt och intressant föredrag. En person som jag gärna skulle vilja träffa in person.

Rekommenderas varmt!

Thomas #16,

Du skriver om modellen:

Det inger inte så stort förtroende.

Vad menar du? Jag har använt en modell från Andrews hyllade lärobok i amosfärfysik, se referens i bloggposten.

Anser du att Andrews kapitel om Climate Change inte inger så stort förtroende?

Thomas #15

Du talar om inverkan av PDO, men hur beräknar du forcing från denna?

Grunden för detta är att medeltemperaturen i klimatsystemet inte kan variera utan orsak. Det måste tillföras energi för att den skall öka och det måste tas bort energi för att den skall minska. Med hjälp av EBM kan man alltså bestämma hur stor forcingen för en viss temperaturvariation måste vara.

Aerosoler är något väldefinierat, man kan mäta hur mycket de kyler, men PDO är mest ett namn.

I princip kan mäta den forcing som har att göra med PDO genom att jämföra temperaturmätningar i oceanen och atmosfären. Likaså kan man som du säger i princip mäta hur mycket aerosoler kyler. I praktiken är det illa ställt. De forcings som uppges för aerosoler kylande effekt har så vida osäkerhetsgränser att det nästan är som de inte alls var kända. Många klimatforskare ifrågasätter aerosolernas kylande effekt och menar att den är starkt överdriven.

Än konstigare är den där linjärt ökande forcingen. Var kommer den ifrån?

Du upplever den som konstig men till skillnad från Roy Spencer och likasinnade klimatforskare som under många år umgåtts med de här problemställningarna är du inte själv klimatforskare. En ökande naturlig forcing är en konsekvens av ett tänkbart samspel mellan ocean och atmosfär på en tusenårsskala.

Under andra halvan av förra millenniet var temperaturen låg och vände sedan uppåt. Detta kan bara ske om klimatsystemet tillförs energi dvs. en forcing. Detta är en hypotes och vi kan inte veta exakt hur denna forcing ser ut. Linjär form är en rimlig ansats.

Varför upphör den 2003?

De forcingdata från GISS som jag använt upphörde år 2003 (Sato har under de senaste dagarna uppdaterat filerna så nu finns forcings fram till och med 2010 – jag har för övrigt en gissning om varför de nyligen uppdaterat).

Efter år 2003 är därför beräkningen en utvärdering av ett tänkt möjligt förlopp. Jag har valt att bestämma denna forcing efter 2003 som en linjär extrapolation av GISS forcing från växthusgaser (omräknat motsvarar detta en koldioxidhalt som ökar exponentiellt). Jag har valt att också låta PDO-forcingen fortsätta efter 2003 i fall Spencer.

Det är inte orimligt att en antagen forcing som gick genom ett minimum under andra halvan av förra millenniet nu kan ha kommit till sin vändpunkt. Men om man i stället låter den linjära forcingen fortsätta efter år 2003 så får man en kurva av samma form men temperaturen år 2100 blir drygt 0,2 grader högre.

Det är klart att om man postulerar att delar av uppvärmningen är naturlig så blir effekten av CO2 mindre enligt just denna modell, men det är numerologi inte fysik. Tänk om det istället skett en naturlig avkylning under 1900-talet, då blir med samma analys klimatkänsligheten hög.

Detta är naturligtvis en relevant synpunkt. Den gäller inte minst Hansens aerosoldata. När man postulerar att delar av uppvärmningen har uppvägts av kylande effekter från aerosoler så blir effekten av CO2 större enligt klimatmodellerna, men det är numerologi inte fysik.

Mitt pedagogiska beräkningsexempel kan alltså illustrera just denna kardinalinvändning som ju är en av de främsta kritiska synpunkterna som vi skeptiker har på klimatvetenskapen och klimatmodellerna. Det är fråga om numerologi snarare än fysik.

Pehr!

Bra att du kan så pass mycket att du kan göra egna beräkningar och även förklara hur det hänger ihop. Intressant läsning!

Pehr, du bestämmer alltså PDO:s inverkan enbart genom kurvanpassning. Dessutom under antagandet att PDO är en sinuskurva och med en (fritt?) vald tidsförskjutning. I verkligheten är inte PDO fullt så regelbunden:

http://en.wikipedia.org/wiki/File:PDO.svg

Hade inte PDO passat hade du och Spencer annars kunnat slänga in AMO, NAO, solfläcksindex (de som tror på Svensmark och tänkte efter borde redan reagerat på att det inte finns något utrymme för hans mekanism i din modell) eller något annat valfritt index av vilka det finns många. Konstigt vore det väl om inte något av dem kan delvis reproducera den globala temperaturkurvan med lite extra fria parametrar.

Jag vidhåller att den linjära trenden utan någon som helst förklaring bara är en ”black box” som Spencer och du stoppat in för att kunna få till en lägre klimatkänslighet. Vad är mekanismen? Aerosoler är fysik, om än inte helt lätt att mäta kvantitativt.

Som du säkert vet (eller borde veta) finns det otaliga metoder som använts för att beräkna klimatkänsligheten som alla ger högre resultat än Spencers och ditt.

Den modell du använder är dessutom inte mer än en diffusionsekvation som fördröjer och jämnar ut indata från forcing med en tidskonstant på C/alfa, dvs för Hansens version 12 år och för Spencers 2,6. (Där har du något att fundera över: kan man säga något om vilken tidskonstant som är rimligast?) Jag vet att Tamino fick minst lika bra resultat med en motsvarande modell där han använde sig av CO2+vulkaner+el nino och en mer normal klimatkänslighet.

I grunden handlar det om att försök att använda sig av enbart global medeltemperatur, enklast tänkbara ekvation där man stoppar in forcings lite som man känner för inte kan säga något om framtida klimat. Det behövs mer avancerade modeller och att man använder sig av alla de övriga mätdata vi har om hur klimatet fungerar.

Thomas #22,

Det var mycket på en gång. Jag får svara lite i taget.

Pehr, du bestämmer alltså PDO:s inverkan enbart genom kurvanpassning. Dessutom under antagandet att PDO är en sinuskurva och med en (fritt?) vald tidsförskjutning.

Jag har inte räknat med hundraprocentig exakthet men det är meningslöst speciellt när det endast är en räkneövning och när temperaturdata i sig har en osäkerhet på ± 0,1 °C.

Men period och temperaturamplitud för PDO överensstämmer ungefär med fig 3 i följande artikel av Wu et al. (2007):

http://www.pnas.org/content/104/38/14889.full.pdf

Genom att räkna baklänges med EBM på en sinuskurva med perioden 64 år och amplituden 0,08 °C och anpassa fasförskjutningen mellan temperatur och forcing så får man den sinuskurva som jag använt i beräkningen för PDO-relaterad forcing vid klimatkänsligheten 0,6 °C.

Så det är alltså inte mycket som anpassats. Från artikeln framgår period och amplitud och vi vet vilken klimatkänslighet vi vill testa med. Det blir alltså bara fasförskjutningen som blir kvar för att anpassa.

Jag vidhåller att den linjära trenden utan någon som helst förklaring bara är en ”black box” som Spencer och du stoppat in för att kunna få till en lägre klimatkänslighet.

Jag vidhåller att detta är en likadan svart låda som används i andra klimatmodeller i form av aerosoldata som är så osäkra att de också måste betraktas som svarta lådor. Vi kan lika gärna betrakta detta som att jag minskar andra klimatmodellers svarta lådor med en del av osäkerhetsintervallet i aerosoldata.

Min räkneövning kan antingen betraktas som att jag har samma aerosoldata som Hansen plus en naturlig linjär trend eller att jag minskar Hansens spektakulära aerosoldata med en del av osäkerhetsintervallet.

Det behövs mer avancerade modeller och att man använder sig av alla de övriga mätdata vi har om hur klimatet fungerar.

Det behövs om man nu kan åstadkomma detta. Dagens mest avancerade klimatmodeller innehåller alltför mycket osäkra parametriseringar, alltför dålig numerisk upplösning, för många svarta lådor i form av mycket osäkra data såsom aerosolforcingen, för att vi skall kunna få några säkra besked om hur klimatet fungerar.

Hur stor den framtida uppvärmningen kan bli är mycket osäkert och inte ens osäkerheten kan fastställas med säkerhet. Det är alltför mycket numerologi i stället för pålitlig fysik.

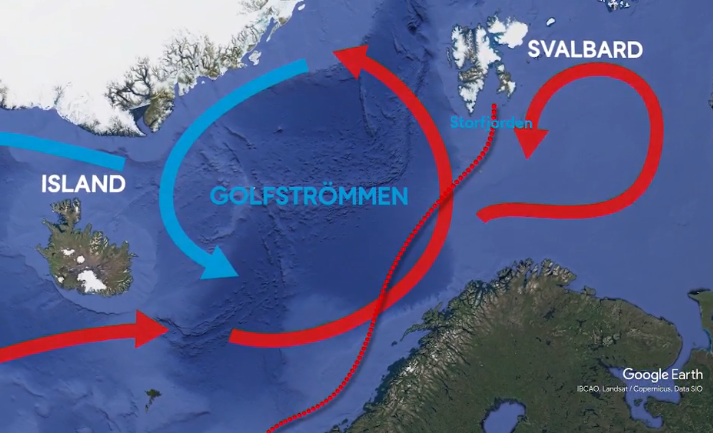

Ett grundproblem är uppenbarligen att oceanerna är mycket viktiga för klimatets utveckling. Men man är mycket bättre på att modellera atmosfären än oceanerna. Utvecklingen av modeller för atmosfären har gynnats av behovet atmosfärmodeller för väderprognoser och man har lärt sig mycket om atmosfärens fysik. Någon motsvarighet till väderprognos i oceanerna känner jag inte till och jag gissar att modellering av oceanerna är mycket mindre utvecklad.

Detta kan var en förklaring till att klimatmodellerna inte kan beskriva viktiga oscillationer såsom PDO.

Förstår inte vad artikelförfattaren vill ha sagt. Kemister har nog inte rätt kompetens att uttala sig om modellbygge och identifiering. Empiriskt verkar klimatkänsligheten ligga på ca. 2.5 grader (och ökande).

Stickan #24

Empiriskt?

Menar du att detta är uppmätta data?

Var snäll och visa var vi kan hitta siffrorna?

Inklusive den ökande trenden?

Stickan #24,

Lär dig lite atmosfärfysik och klimatvetenskap, förslagsvis genom att läsa Andrews bok som jag refererar till i bloggposten, så förstår du nog bättre.

Det vore kul om du som tydligen har viss kunskap i modellering skulle kunna delta i den intressanta diskussion som jag och Thomas har här. Thomas är påläst i klimatvetenskap och det skulle du också kunna vara om du har den ambitionen.

Stickan #24, ca 30% av mina kemikollegor i Sverige ägnar sig helt åt modellering. Även Pehr och jag själv har gjort åtskillig modellering.

Mångas uppfattning är att klimatmodellering är närmast omöjligt. Kanske är det så. Resultaten kan ändå aldrig prövas innan modelleraren ligger i graven.

Här en diskussion om en liknande modell:

http://www.gfdl.noaa.gov/blog/isaac-held/2011/03/05/2-linearity-of-the-forced-response/

Där används som indata resultatet från en klimatmodell med en klimatkänslighet på 3,4K. Strunt samma om det återspeglar jorden eller inte, på denna simulerade planet är klimatkänsligheten just 3,4K. Frågan är nu om en metod liknande Pehrs få fram denna känslighet ur utdata? Det visade sig dock att man med parameteranpassning fick en känslighet på 1,5K, mer än en faktor två fel. Uppenbarligen fungerar alltså inte metoden.

Stickan #24 (forts.)

Empiriskt verkar klimatkänsligheten ligga på ca. 2.5 grader (och ökande).

Detta är vad varmistiska klimatforskare som James Hansen anser. De forskare som jag benämner kallistiska såsom Richard Lindzen och Roy Spencer anser att klimatkänsligheten ligger inom intervallet 0,5 – 1,0 grader beroende på att naturliga variationer i klimatet troligen har en dominerande betydelse jämfört med inverkan av ökande växthusgashalter.

Detta är inte heller vad klimatforskarna inom huvudfåran (maistream) av klimatvetenskapen säger idag verkar det som. Både Thomas Palm och jag själv har tillskrivit den kanske främste svenske klimatforskare professor Lennart Bengtson angående klimatkänsligheten. Se följande kommentarer på Newsmill:

Kommentar nr 96:

http://www.newsmill.se/artikel/2011/04/25/hanteringen-av-fett-och-klimatfr-gan-visar-en-farlig-opportunism?page=1

Kommentar nr 151 och 173:

http://www.newsmill.se/artikel/2011/04/25/hanteringen-av-fett-och-klimatfr-gan-visar-en-farlig-opportunism?page=3

Lennart Bengtsson anser att klimatkänsligheten, den transienta dito, empiriskt har legat på 1,1 – 1,5 grader de senaste hundra åren. Klimatkänsligheten är inte konstant utan varierar med klimatets tillstånd. Vi måste alltså enligt Bengtsson ta hänsyn till att klimatkänsligheten kan öka i framtiden.

Som exempel skriver Bengtson till Thomas Palm att om koldioxidhalten fördubblas från 350 till 700 ppm så kommer temperaturen att stiga 1,2 – 1,9 grader.

Lennart Bengtsson anser också att klimatkänslighet vid jämvikt, till skillnad från den transienta, bara kan skattas från tusenåriga beräkningar med realistiska klimatmodeller och är mindre tillförlitlig och inte meningsfull.

Thomas #22 (forts.)

Den modell du använder är dessutom inte mer än en diffusionsekvation som fördröjer och jämnar ut indata från forcing med en tidskonstant på C/alfa, dvs för Hansens version 12 år och för Spencers 2,6. (Där har du något att fundera över: kan man säga något om vilken tidskonstant som är rimligast?)

Den modell jag använder innehåller faktiskt, till skillnad från avancerade klimatmodeller, inte någon modellering av diffusion. Principen för modellen är energikonservering, att energi varken kan skapas eller förstöras (termodynamikens första huvudsats).

Men modellen är också ekvivalent med en faltningsekvation (faltning = convolution på engelska). Detta framgår av ekvation 8.11 i Andrews lärobok som jag referat till i bloggposten ovan.

Jag har ett eget resonemang om tidskonstanten. En hög tidskonstant är kopplad till hög klimatkänslighet och vice versa. Temperaturen påverkas ständigt av mer eller mindre slumpmässigt varierande forcings som kan bero på molnens slumpmässiga uppträdande. Vid hög klimatkänslighet får dessa forcings större betydelse och verkar längre tid på temperaturens utveckling än vid låg klimatkänslighet. Detta borde innebära att andra forcings blir mindre synliga i temperaturens utveckling vid hög klimatkänslighet än vid låg dito.

Stephen Schwartz har i ett föredrag (2011) Relating climate forcings and climate response visat att forcing och temperatur är starkt korrelerade:

http://www.ecd.bnl.gov/steve/pres/ForcingResponseISSI2011.pdf

På bild 2 i föredraget visar han att formen på forcing från växthusgaserna och temperaturkurvans övergripande form (utom oscillationer såsom PDO-relaterade sådana) överensstämmer väl. Ett sätt att tolka detta på är att aerosolernas kylande effekt har överdrivits och att mänskligt orsakad forcing huvudsakligen består av växthusgaserna. I så fall skulle klimatkänsligheten ligga omkring 1 grad (under förutsättning att ingen naturlig forcing bidragit till uppvärmningen).

Detta tyder alltså på att både klimatkänsligheten och tidskonstanten är låg. Genom att tidskonstanten är låg avspeglar temperaturkurvans form den externa radiativa forcingens form.

Det finns mer att säga om detta men jag skall bara kommentera bild 6. Där har Schwartz använt faltningsekvationen på alla forcings enligt GISS med tidskonstanten 10 år och finner att den faltade signalen och temperaturkurvan överensstämmer bäst för en klimatkänslighet av 1,7 grader.

Detta innebär alltså att den bästa överensstämmelsen mellan EBM med GISS forcing och uppmätta temperaturer får man för klimatkänsligheten 1,7 grader. Men min beräkning ovan i bloggposten visar att eftersom temperaturdata har så stor osäkerhet så får man bra överensstämmelse även med klimatkänsligheten 2,8 grader.

Summa summarum är att de stora osäkerheterna om forcings, och speciellt hur forcings från aerosoler inverkan, och vilken betydelse naturliga variationer har, gör att klimatmodellerna inte kan beräkna pålitliga värden på klimatkänsligheten.

Det verkar som huvudfåran av klimatforskare rör sig mot åsikten att klimatkänsligheten är lägre än vad IPCC kommit fram till 2007. Viktiga tecken tyder på låg klimatkänslighet, till exempel en del av det Schwartz tar upp i föredraget och resultat från den forskning som bedrivs i Lindzens och Spencers forskargrupper, baserade på satellitobservationer.

Pehr, Lennart Bengtssons siffra på 1,2-1,9 grader är för en snabba uppvärmningen vilket inte är jämförbart med den mer vanliga definitionen av klimatkänslighet som handlar om jämviktstemperatur efter en lång tidsperiod. Han verkar inte tycka att en sådan definition är användbar, men likafullt bör man ha klart för sig att det är olika definitioner som används. Det där att mainstream idag skulle tro på en lägre klimatkänslighet är bara rent önsketänkande från din sida. (Den som vill veta mer om vad Lennar Bengtsson anser, t ex om denna blogg, kan söka hos UI där han skrivit några inlägg).

#30, det var typen av ekvation jag tänkte på när jag talade om diffusionsekvation, inte att du modellerade diffusion som fysiskt fenomen. Att kalla det en faltning är också helt korrekt. Det är inte en bra modell för att beskriva jordens klimat kvantitativt. Läroböcker brukar inrikta sig mer på pedagogik än på att få exakt rätt svar.

IPCC Box 10.2 ger en betydligt bättre sammanfattning av olika studier och metoder för att beräkna klimatkänsligheten.

Den som vill hävda att aerosoler inte har någon speciellt stor kylande effekt lär få vissa problem med att förklara resultatet av Tamboras och Krakataos utbrott. ”Året utan sommar” var en dramatisk illustration av hur de kan kyla.

Thomas #31,

Pehr, Lennart Bengtssons siffra på 1,2-1,9 grader är för en snabba uppvärmningen vilket inte är jämförbart med den mer vanliga definitionen av klimatkänslighet som handlar om jämviktstemperatur efter en lång tidsperiod. Han verkar inte tycka att en sådan definition är användbar, men likafullt bör man ha klart för sig att det är olika definitioner som används.

Jag har ingen anledning att kritisera Lennart Bengtssons bedömning att klimatkänsligheten vid jämvikt inte är meningsfull. Detta är väldigt logiskt med tanke på klimatet aldrig kommer till jämvikt och att vi knappast kan ha intresse av vad ett fiktivt jämviktstillstånd om tusen år kan ha för temperatur.

Det finns stor osäkerhet om klimatkänslighetens värde och vilken global uppvärmning vi kommer att få i framtiden. Terminologin ändras därför i vissa kretsar till att klimatutsläppen leder till klimatförändringar och klimatstörningar i stället för att säga global uppvärmning. Att med säkerhet hävda att klimatkänsligheten är hög anser jag tyder på önsketänkande (man kanske har en outtalad agenda eller så vill man helt enkelt ha rätt).

Den som vill hävda att aerosoler inte har någon speciellt stor kylande effekt lär få vissa problem med att förklara resultatet av Tamboras och Krakataos utbrott. ”Året utan sommar” var en dramatisk illustration av hur de kan kyla.

Aerosoler från vulkaner som har haft signifikant effekt på klimatet, till exempel de från Pinaubo, hade det för att vulkanerna med stor kraft skickade upp partiklarna i stratosfären:

http://www.drroyspencer.com/2010/06/revisiting-the-pinatubo-eruption-as-a-test-of-climate-sensitivity/

Effekten av aerosolerna från Pinatubo kunde ganska väl mätas upp. De påverkade både strålningen och temperaturen enligt satellitobservationer.

De aerosoler som människan producerar hamnar i troposfären där de har kort livslängd eftersom de tvättas ut genom nederbörden, till skillnad från aerosolerna i stratosfären. Dessa mänskliga aerosoler förekommer dessutom regionalt, alltså där de uppkommer genom förbränning.

Detta gör det mycket svårt att bestämma hur stor effekt de faktiskt har på forcingen. Man är mycket beroende av modeller för att avgöra detta och modellerna kan ifrågasättas. Detta är orsaken till att det förekommer så mycket kritik mot dessa aerosoldata.

Thomas #31,

En djupare diskussion av promlematiken med aerosoler finns i Schwartz et al. (2010) Why Hasn’t Earth Warmed as Much as Expected?:

http://www.ecd.bnl.gov/steve/pubs/SchwartzJClimate10WhyHasnt.pdf

Thomas #28,

Den artikel du länkar till är fokuserad på en enda aspekt.

En allmännare och mer övergripande diskussion är Judith Currys bloggpost What can we learn from climate models?:

http://judithcurry.com/2010/10/03/what-can-we-learn-from-climate-models/

Första meningen lyder:

Short answer: I’m not sure.

Hennes diskussion kräver en del förkunskaper av läsaren så hon skriver:

This discussion is somewhat esoteric, and written for an audience that has some familiarity with computer simulation models. For background on global climate models, I suggest the following references:

Wikipedia

Climateprediction.net

Roy Spencer

Jag tycker att artikeln av Roy Spencer är väldigt läsvärd:

http://www.drroyspencer.com/2009/07/how-do-climate-models-work/