För den som söker klimatdata, är Climate Explorer ett bra val. Där finns allehanda data, exempelvis temperaturserier och resultat från klimatmodellkörningar. Vad gäller de senare, finns resultat från CMIP3+ och den modernare CMIP5. Eftersom klimatmodellkörningar för framtiden kräver prognoser för framtida utsläpp, finns modellkörningar för olika utsläppsscenarier. De utsläppsscenarierna är samma som de som användes i den senaste omgången av IPCC-rapporter och kallas RCP2.6, RCP4.5, RCP6.0 och RCP8.5.

Den sistnämnda kallas ofta business-as-usual, men det stämmer inte alls. Tittar man noga på förutsättningar, är de helt orealistiska. RCP8.5 utgår från en snabbare befolkningsökning än vad andra FN-organ anser vara möjlig. Vidare utgår den från att energitekniken kommer att gå bakåt i stället för framåt. Enligt RCP8.5, kommer kol att bli allt viktigare för mänsklighetens framtida energiförsörjning. Befolkningen spås öka snabbare än ekonomin, så den genomsnittliga människan kommer att bli allt fattigare. RCP8,5 spår att koldioxidhalten år 2100 kommer att vara 930 ppm. Eller drygt 3 gånger högre än i början av 1800-talet. Mer än dubbelt så hög som nu, förresten. Koldioxidhalten i atmosfären behöver stiga med 6 ppm per år för att nå dit. Vilket är tre gånger snabbare än genomsnittet för de senaste tre årtiondena. Det finns ingenting realistiskt eller business-as-usual med RCP8.5.

I stället valde jag RCP6.0 som det scenario som bäst motsvarar business-as-usual. Inte för att det spelar någon roll, egentligen. Jag tänker diskutera skillnader mellan olika modeller och mellan modeller och verkligheten. När det gäller vad som har hänt är de fyra scenariorna lika. Forskare borde trots allt vara ganska överens om hur mycket växthusgaser som har släppts ut hittills. Där gäller den där konsensusen som många aktivister hävdar, utan att definiera vad de ansser att forskarna är eniga om.

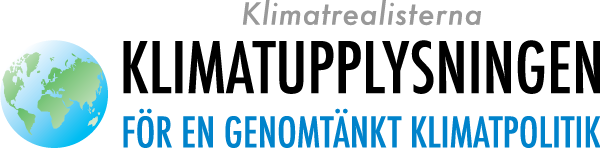

På måfå, utan att veta i förväg vad jag skulle få, valde jag ut fyra av de modellkörningar vars resultat finns tillgängliga på Climate Explorer. Modellresultaten för temperaturer ges som absoluta yttemperaturer i Kelvin. Ni minns väl att det skiljer drygt 273 grader mellan Kelvin och Celsius? Vilket inte spelar någon roll när det gäller skillnader och anomalier, men spelar roll för verkliga temperaturer.

Här är diagrammet med dessa fyra modellresultat inritade, som årsmedeltemperaturer:

Som flera kommentatorer har påpekat tidigare på denna blogg, är modellerna oense om jordytans absoluttemperatur. För 1880, det år som nu har kommit att bli förindustriell tid, skiljer det 1,5 K mellan högsta och lägsta årsmedelvärde för global temperatur i mitt lilla urval. Jag vet inte hur representativt det urvalet är. Kanske finns det ännu större skillnader mellan modeller som jag inte har valt?

1,5 K betyder rätt mycket när det till exempel gäller is- och snötäcke och avdunstning från världshaven. Det betyder en hel del för politiken också. Den förindustriella, globala medeltemperaturen har en osäkerhet på minst 1,5 K. Vilken är då nollpunkten för målen på högst två respektive högst 1,5 graders global uppvärmning?

De fyra modellerna är inte överens om vad som har hänt och de är inte överens om vad som kommer att hända. Enligt den modell som enligt Climate Explorer har nummer 15, exempelvis, hände inte mycket på drygt 100 år, medan vi nu ska befinna oss i en snabb uppvärmningsfas som pågår åtminstone till år 2100. De andra modellern spår mindre snabb uppvärmning. År 1998 är till exempel skillnaden mellan modellerna 1 och 15 1 K, medan den år 2100 är mindre än 0,1 K.

Det är rätt stor skillnad på om den globala uppvärmning fram till 2100 blir 2 eller 3 grader. I alla fall enligt de forskare som räknade ut att fördelarna överväger upp till just 2 grader. Det är den beräkningen som ligger bakom tvågradersmålet, som jag har sett ifrågasättas av Henrik Brundin från Vi-skogen. Han anser i stället att inga klimatförändringar alls och ingen nivå alls på global uppvärmning är acceptabla. Alla klimatförändringar drabbar de fattiga menar han i insändare och debattartiklar som han sprider till svenska tidningar. För att få till det, måste han lita mer på påstådda minnen än på nederbördsstatistik. Frågan är om han ens vet vad nederbördsstatistik är?

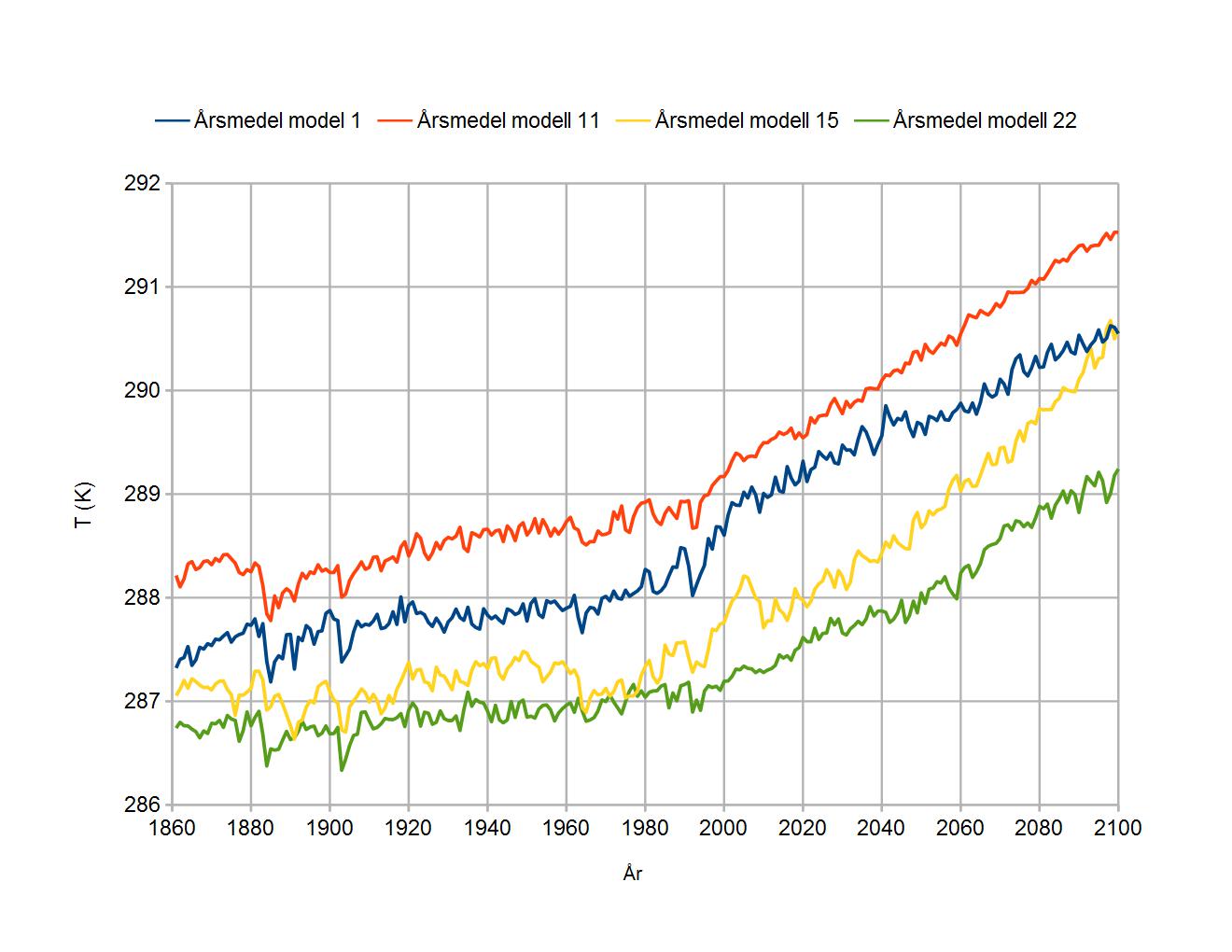

Dags att jämföra modeller med någon temperaturserie som ska representera verkligheten. Jag valde NCDC från Climate Explorer. Det är den som svenska medier ofta verkar använda, även om det många gånger inte nämns vilken temperaturserie de använder för sina rapporter om det femtielfte varmaste året i rad. NCDC:s serie var den första att inkludera en pauskorrektion som påstås visa att den globala uppvärmningen inte alls hade tagit paus. NCDC är en av de temperaturserier som överhuvud taget har många underliga korrektioner av rådata. Korrektioner som enligt vissa skeptiker bara är gjorda för få verkligheten att stämma bättre med modellerna. Då är det väl ett bra val för en jämförelse med just modeller?

Egentligen har NCDC slagits ihop med andra avdelningar inom USA:s motsvarighet till SMHI, NOAA. Den nya avdelningen kallas NCEI, men beteckningen NCDC lever kvar. Bland annat då på Climate Explorer.

Temperaturserierna från verkligheten har vanligen anomalier som data, medan modellerna alltså har absoluttemperaturer. Det går lätt att fixa genom att räkna om allt till anomalier. Som normalperiod valde jag 1971-2000. Ett diagram med de fyra valda modellresultaten och NCDC:s temperaturserie ser ut så här:

Modellerna stämmer vare sig överens med varandra eller med verkligheten. Om nu NCDC:s serie är verkligheten. Modellerna har till exempel problem med vulkanutbrott. Krakatoas utbrott 1883 borde enligt modellerna ha gett åtminstone ett par tiondels graders global avkylning, medan verkligheten knappt visar någon effekt alls.

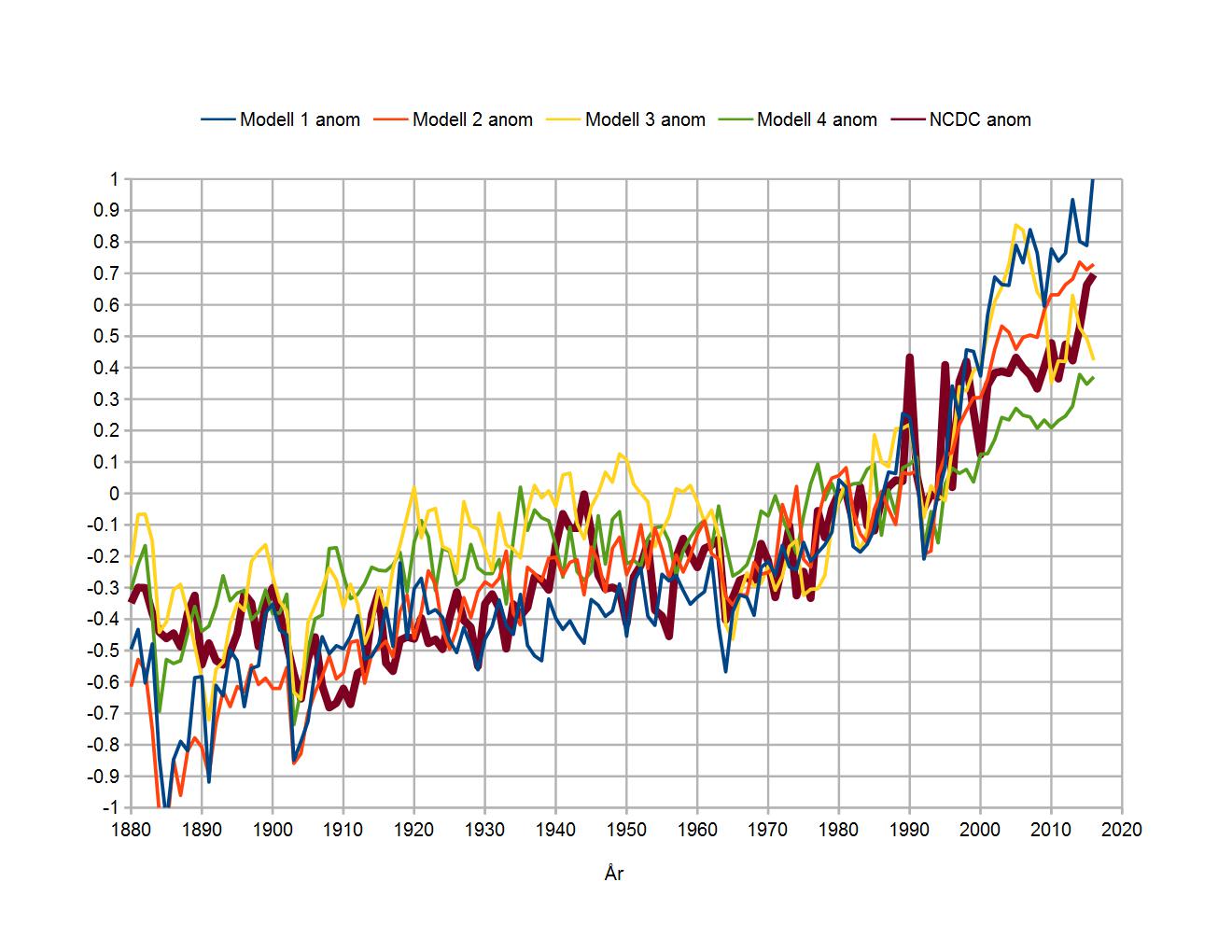

Ingen enskild modellkörning stämmer ens någorlunda väl med verkligheten. Åtminstone inte någon av de fyra modellkörningarna jag valde och den version av verkligheten jag valde. De klimathotstroende brukar gå med på att enstaka modellresultat inte är något att lita på, men hävdar att medelvärdet av många körningar trots allt stämmer bra och kan ge acceptabla prognoser för framtiden. Climate Explore har medelvärde för många modellkörningar också. Låt oss jämföra en sådan med verkligheten då:

Modellmedel stämmer inte heller med verkligheten. Då har jag ändå använt en verklighetsversion som kanske är anpassad för att stämma någorlunda bra med modellerna. Modellerna överskattar som sagt klimatpåverkan från Krakatoas utbrott. 1902 var det fyra stora vulkanutbrott, med Santa Maria som det största, även om Pelées utbrott dödade fler. Där verkar modellerna har fått till det någorlunda rätt. 1907 hade Ksudach ett stort utbrott. Enligt modellerna borde det inte ha märkts på global medeltemperatur, men enligt verkligheten tycks det ha märkts.

Novaruptas utbrott 1912, kanske i kombination med Colimas 1913, borde enligt modellerna ha kylt av jordytan en aning, men i verkligheten syns inte mycket av det. Inte förrän Agungs utbrott 1963 hittar vi åter en påverkan som enligt modellerna borde ha varit märkbar och som stämmer ganska bra med verkligheten. Flera av dalarna 1912-1963 i NCDC:s temperaturkurva skulle ha kunnat bero på vulkanutbrott. Men det kan också vara naturlig variabilitet med någon annan orsak. Modellmedel visar knappt några variationer alls under den perioden.

Det är bara för perioden 1960-90 som modeller och verklighet stämmer ganska bra överens. Vilket är rimligt, med tanke på att modellerna först gjordes för att kunna förklara alla klimatförändringar under den perioden med enbart växthusgaser och vulkanutbrott. Samtidigt som det är fullt möjligt att verkligheten, i form av NCDC:s temperaturserie, har korrektioner som har införts just för att få verklighet och modeller att stämma bättre överens.

Klimathotstron bygger på att mängden solstrålning till toppen av atmosfären (TOA) är konstant, att molnighet bara är en återkoppling och inte ändras annars och att bara vulkanutbrott och mänskliga utsläpp påverkar klimatet. Med mänskliga utsläpp menas då dels utsläpp av växthusgaser och dels luftföroreningar, som aerosoler.

Modellmakarna kunde inte förklara den globala uppvärmningen under 70-, 80- och 90-talen med enbart ökningen av koldioxid- och metanhalter. De tvingades förutsätta återkopplingar, främst i form av vattenånga och moln. Dessa återkopplingar ungefär tredubblade effekten av mänsklighetens växthusgasutsläpp. Då fungerade det. Nackdelen är att det inte fungerar för någon annan period. Den självklara slutsatsen från det är att modellmakarna har överskattat växthugasernas klimatpåverkan och underskattat naturliga faktorer. Ja, vissa möjliga, naturliga faktorer är inte alls inräknade. Exempelvis kosmisk strålnings möjliga påverkan på molnighet. Eller interna variationer, orsakade av havsströmmar och vindar.

Den självklara slutsatsen passar inte de klimathotstroende, för då har de inget klimathot att skrämmas med. Med en tre gånger lägre klimatkänslighet än vad som finns i modellerna, måste också prognoserna för framtida uppvärmning skrivas ned med en faktor tre. I stället för 1,5-4,5 graders uppvärming fram till 2100, blir det bara 0,5-1,5 grader. Behövs då några åtgärder alls för att klara tvågradersmål, eller ens 1,5-gradersmål? Någon form av energiteknisk utveckling borde världen ändå få se fram till 2100, en som gör fossila bränslen mindre viktiga?

I modellerna syns ingen påverkan alls från El Niño 1997-8, helt enkelt för att modellerna inte klarar sådana variationer i havsströmmar och växelverkan mellan hav och atmosfär. Modeller och verklighet gick skilda vägar efter Pinotubas utbrott 1993. Vars påverkan för övrigt tycks ha underskattats av modellerna. Först tack vare senaste El Niño, ungefär lika stark som den 1997-8, kom verkligheten i nivå med modellerna. Eftersom den effekten var högst tillfällig, om inte verkligheten ska korrigeras ännu mer, är det lätt att spå att modellerna snart ska skena iväg från verkligheten igen.

De klimathotstroende har bara ett enda försök till sakligt argument för att det mesta (eller allt) av klimatförändringarna de senaste 50-70 åren måste bero på växthusgasutsläpp: Att modellerna inte kan förklara temperaturökningen utan den ökande halten växthusgaser. Men modellerna klarar inte att förklara några globala temperaturförändringar med växthusgasutsläpp heller. Perioden 1960-90 klarar de genom att postulera återkopplingar som snarare är motbevisade än belagda. Andra perioder klarar de inte alls.

Resultaten från klimatmodellerna är grunden för klimathotstron. Men modellerna klarar inte jämförelser med verkligheten. För den som tittar på skillnaden mellan modell och verklighet, och inte är förblindad av sin religiösa tro på ett akut och allvarligt klimathot, är det uppenbart att modellerna har för mycket påverkan från växthusgaser och för lite påverkan från naturliga faktorer. Först när de felen är korrigerade är det möjligt för modellerna att göra några vettiga förutsägelser för framtiden. Med sådana felrättningar kommer modellresultaten inte att längre göda någon klimatalarmism, så det finns inte precis någon press på modellmakarna att erkänna och korrigera felen.

Tack Lars!

När de måste dra till med ”97% av forskarna” samtidigt som vi vet att 100% av skeptikerna tror att människan påverkar klimatet bevisar att till och med deras starkaste argument är blött dasspapper.

Att inte ställa kontrollfrågan ”hur mycket då” gör att det vilseledande argumentet består.

Kliatmodellerna är ett rent skämt faktiskt och endast oseriösa forskare kan använda dem till att skrämmas om klimatet.

Dessa scenarier är som sagt bara övningar baserade på confirmation bias och overfitting med selektiv data. Lattjo tidsförtid för de som gör dem. Politisk mädchen für alles för opportunister

Lars, precis som varje modellkörning bara är en realisering av en stokastisk process och at varje körning därför ger lite annorlunda resultat så är jordens klimat bara en realisering. Även om vi hypotetiskt tänker oss en perfekt klimatmodell så räcker det inte att ta medel av många körningar för att få den att överensstämma perfekt med jordens klimat. Vi skulle också behöva ha en stor mängd jordar och medelvärdesbilda alla dessas klimat och jämföra modellmedel med verkligt medel.

Det man kan notera är att om man tittar på din figur 2 så tvivlar jag på att någon skulle kunna med säkerhet säga vilken kurva som var jordens klimat och vilka som var modellkörningar utan att ha tillgång till facit. Bättre än så blir det inte.

”Modellmakarna kunde inte förklara den globala uppvärmningen under 70-, 80- och 90-talen med enbart ökningen av koldioxid- och metanhalter. De tvingades förutsätta återkopplingar, främst i form av vattenånga och moln.”

Var lite allvarlig nu! Vattenånga infördes som positiv återkoppling av Arrhenius i slutet av 1800-talet av rent fysikaliska skäl. Det är inget modellmakare ”tvingades förutsätta” för att få modeller och verklighet att stämma överens. Dessutom finns en ironisk poäng här i att vanligen på denna blogg klagas på att dessa positiva återkopplingar inte finns i verkligheten utan bara är politiska påfund, men här hävdar Lars att man införde dem just för att få modellerna att stämma med verkligheten.

”Ja, vissa möjliga, naturliga faktorer är inte alls inräknade. Exempelvis kosmisk strålnings möjliga påverkan på molnighet. Eller interna variationer, orsakade av havsströmmar och vindar.”

Senaste resultaten från CERN visar på att inverkan av kosmisk strålning är minimal. Så länge ingen kam ge en kvantitativ skattning som visar på att effekten skulle vara signifikant finns ingen vare sig anledning eller möjlighet att ta med den. Och visst har man med interna variationer, varför tror du temperaturen hoppar upp och ned mellan åren som den gör i alla modellkörningarna?

Lars ägnar sig bara åt rent önsketänkande när han hoppas att det är några okända naturliga faktorer som ligger bakom uppvärmningen senaste seklet, eller kanske skall man snarare se det i religiösa termer eftersom Lars verkar inne på religion. Att han liksom Spencer förutsätter att gud skapat världen stabil.

#3 Thomas P – Önsketänkandets stormästare!

Följ upp ditt resonemang och inse att dessa scenarios kan läggas i arkivet för lattjo numeriska övningar.

Givet att dessa scenarios har snarlika utgångspunkter – Om de nu vore så att man skulle varit något slags samband på spåren så skulle jämförelse mellan i förväg modellerat resultat och utfall givit vid handen att de olika modeller skulle fördela sig både över och under reellt utfall. De gör de inte. De ligger alla över. Systematiskt fel. Alltså man använder inte relevant indata och ägnar sig systematiskt att överanpassa till ett a priori önskat utfall.

Dvs slår man inte status quo – scenariet säger dessa labbövningar ingenting.

När jag bad Erik Kjellström, SMHI (Rossby Centre), berätta om vilka tecken på klimatförändringar som finns, hänvisade han till GISS.

Svempa #4 Titta på figuren igen! Uppmätt temperatur ligger inte i botten. Dessutom, om verkligt klimat och modellkörningar härstammar från samma ensemble vilket de gör om modellerna och deras indata är ideala, så är det 20% att det uppmätta resultatet ligger under det fyra modellkörningarna.

1. Nix, inga feedbacks finns validerade bortom diskussion.

2. De olika oscillationerna i oceanerna finns inte med i modellerna (internal variation). Anses ta ut varandra på 60 år. Det betyder ju inte att de inte kan skapa en trend inom, säg, en 30 års-period? Det finns försök där man tar med dessa oscillationer. Alla ger en betydligt LÄGRE klimatkänslighet som följd.

3. Molntäcket anses konstant vilket inte är sant. Solinstrålningen (mot markytan) har varierat kraftigt. Endast 2-3% förändring i det globala molntäcket skulle kunna förklara alla temperaturförändringar.

4. Modellkörningar klarar i princip ALDRIG temperaturökningen mellan 1920-1940 som anses vara icke-antropogen. Om den var icke-antropogen, varför skulle inte den senare också kunna vara det? Naturliga variationerna har väl inte upphört på något magiskt sätt?

#6 Indata är selektivt inte idealt. Det är endast jämförelse mot framtida utfallsdata (relativt när scenariot skapades) som är intressant. Inte på kurvpassade historiska.

Var lite allvarlig nu säger Thomas P till Lars K. ”Realisering av en stokastisk process”. Är det vad Thomas P menar med att vara allvarlig. Förstår han det ens själv.

Det är några detaljer jag inte förstår och funderat på:

Det är så vitt jag förstår idag helt belagt att globalismens alarmister i princip förfalskat originaldata (mätvärden) för att deras klimatmodeller skall visa önskat resultat. Vad värre är, så har jag sett uppgifter om att registrerad originaldata i databaser byts ut mot förfalskade väden, samtidigt som originaldatan uppenbarligen raderas/förstörs.

*Hur skall man om några år veta vad som en gång uppmättes vid de olika mätstationerna?

Jag anser att klimat handlar om samverkande och/eller motverkande ”kaos-processer”. Sannolikheten för att något upprepar sig identiskt är således NOLL (0)! Till detta måste fogas en faktor ”K” för det okända. I alla fysikaliska sammanhang måste denna faktor ingå med ett värde på plus eller minus annars är inte ”teorin” seriös. Är det fler än jag som funderar över tillförlitlighetsgraden för datorstödd klimatmodullering (som sanningsenligt till en början/ibland kallas för ”kalkylering”, men bytt namn när alarmisterna insåg att kalkylering är en låg grad av beräkning (ungefär som en gammal vevdriven räknemaskin).

*Hur många ”klimatmodeller” redovisar en faktor ”K”? Saknas en sådan så är detta enligt min mening ett bevis för en oseriös kalkyl (teori/modell). K-värdet måste redovisas!

*Behärskar mänskligheten den matematik som krävs för att bearbeta nämnda ”kaos-processer”? Det anser inte jag!

*Disponerar mänskligheten f n tillräckligt med samlad datorkraft, för att kunna bearbeta ”kaos-processer”? Det anser inte jag?

#3 Thomas och #9 Daniel.

Jag funderade också lite på vad Thomas P. menade med realisering av stokastisk process. Han kanske syftar på ”the Copenhagen interpretation”. Ja alltså inte på vad Obama kom fram till under klimatfestivalen där utan Niels Bohrs ”wave function collaps”´. T.ex. ljusets kollaps från en vågfunktion (en superpositionerad stokastisk process?) som realiseras i en partikel.

Eller kanske den elastiska AGW-hypotesens kollaps?

Klimatet är en kaotisk process. Definitionen av kaos är: ”oförutsägbar”.

Slutsats: Klimatmodellerna saknar värde.

Det måste vara något annat som driver ”forskarna” att fortsätta.

Vi uppehåller oss vid värdelösa klimatmodeller som enbart ser samband mellan ökningen av CO2 och global temperatur. Resultatet är som syns där temperaturen korrelerar med ökningen av antropogen CO2. Modellerna saknar ju verkliga förutsättningar. Var finns den solenergi i modellerna som omvandlar stratosfärens kemi och därmed förändrar jetströmmarnas lägen? Det är löjeväckande att vi har klimatforskare som springer omkring och yrar utan att förstå alla väder- och vinds oberoende variabler som påverkar den beroende variabeln, temperatur T?

Roland # 10

Ja tänk om de för alltid lyckats sänka tex det varma 1930- talet !

Tänker mig att tex Ryssland mfl ändå har egna väl bevarade historiska data som ”globaliseringsliberalerna” inte kommer åt.

Modeller vs verklighet?

Fick denna inbjudan från Byggfakta att delta i en undersökning. Vilken verklighet lever dom i?

”Hej och välkommen till Byggfakta!”

”Klimatförändringarnas skadeverkningar har blivit allt mer uppenbara både nationellt och globalt. I dagsläget är ansvarsfördelningen vid översvämningsskador i Sverige oklar samtidigt som antalet skador på byggnader till följd av kraftig nederbörd ökar. Med undersökningen önskar vi kartlägga attityder kring översvämning och nederbörd.”

https://www.webropolsurveys.com/S/2D23A99F780505DF.par

Se sista frågan! ..strategi att arbeta med klimatanpassning under 2017 ?

Om den här bloggen funnits 1974 då NOAA fick i uppdrag att utreda risken för global nedkylning hade alarmister pekat på bla den år för år växande septemberisutbredningen i Arktiska Havet(den växte under en lång följd av år fram till 1979 som nu används som utgångspunkt)

Skeptiker hade pekat på att det blivit kallare förr inte minst i slutet av 1600-talet.

Alarmister hade hänvisat till datorer som visat att snön skulle ligga kvar över sommaren i norra Norrland, varvid albelot skulle skena.

Tidningarna hade haft bilder på isbjörnar vid snötyngda midsommastänger.

Helt OT visserligen, ursäkta det, men rätt så kul…

Om hunden Max som gillar Trump.

https://www.youtube.com/watch?v=sbQ-pEQ5URw

Från Notrickszone.

IPCC AR5 2013:

“The overall uncertainty of the annually averaged global ocean mean for each term is expected to be in the range 10 to 20%. In the case of the latent heat flux term, this corresponds to an uncertainty of up to 20 W m–2. In comparison, changes in global mean values of individual heat flux components expected as a result of anthropogenic climate change since 1900 are at the level of <2 W m–2 (Pierce et al., 2006).”

Feldman et al, Nature 2015: (fritt tolkat)

As assessed in a 2015 paper published in the journal Nature, the CO2 concentration increased by 22 ppm during the first 10 years of the 21st century. The radiative forcing (warming) effect of this 22 ppm CO2 increase was modeled to be 0.2 W m-2. So of the 1.8 W m-2 of total radiative forcing since 1750, 0.2 W m-2 was added during the first decade of this century.

CO2 verkan under ett decennium: 0,2 WIm2

Osäkerhet i delsummor: 20 W/m2.

Apropå ThomasP:s ”realisering av en stokastisk process” kan kanske en liten förklaring av begreppen vara i sin ordning.

En stokastisk process kan förenklat beskrivas som en serie slumpmässiga variabler. Det finns ganska många olika typer av stokastiska processer som är mer eller mindre användbara för att beskriva och karaktärisera olika slumpmässiga förlopp.

Den kanske enklaste är Poissonprocessen. Att singla slant är det klassiska exemplet på en poissonprocess. Om man t ex singlar slant 17 gånger så är mängden av resultat ett exempel på en realisering av en stokastisk process, i detta specifika fall en Poissonprocess.

Är klimatet då en stokastisk process? Kanske, men det är inte självklart. Kom ihåg att det också finns kraftiga deterministiska inslag i klimatet. Årscykeln t ex, och Milankovitchkurvorna. Det är alltså inte fråga om någon rent stokastisk process.

Det är också långt ifrån självklart vilken typ av stokastisk process det är frågan om. Jag kanske bör tillägga att jag arbetat med, och även publicerat en del om, analys av statistiska data, och att jag av egen erfarenhet vet att det ofta är allt annat än självklart vilken typ av stokastisk process det är frågan om i ett givet fall.

Klimatet har ju uppenbarligen ett visst ”minne” så det har oftast modellerats som någon form av autoregressiv process (= där ett värde i större eller mindre utsträckning påverkas av de(t) närmast föregående). [Anmärkning till ThomasP, jo jag vet mycket väl att i en AR(0)-process påverkas inte nästa term av någon föregående]. Mann (och IPCC) har använt sig av en AR(1) process plus en linjär trend, men det har inte fungerat särskilt bra, vilket t o m Tamino håller med om. En ARMA(1,1)-process är troligen bättre, alltså en autoregressiv process plus ett varierande (men i vårt fall dåligt känt) medelvärde.

Bloggens alla troll har tydligen nästan ingenting att invända mot mitt inlägg? Förutom ett försök att se klimatet som en stokastisk process. Men är det helt och hållet en stokastisk process, går inga någorlunda exakta förutsägelser om framtiden att göra. Det går bara att ange sannolikheter för olika utfall. Sannolikheten är utomordentligt låg för utfallet att det ska bli så varmt som en majoritet av klimatmodellerna spår.

Den som refererar till Arrhenius borde lägga märke till att han faktiskt räknade fel. Och så småningom och motvilligt erkände det.

Mer avdunstning av vatten från haven innebär faktiskt inte nödvändigtvis mer vattenånga i atmosfären. I stället kan vattnet bilda moln, som skymmer solstrålningen och motverkar vad det nu vad som fick havsytan att bli varmare från början.

tty #19 Ett långt inlägg med förvisso helt korrekt beskrivning av en stokastisk process, men du avstår helt från att koppla ihop det med vad vare sig jag eller Lars skrev.

Naturligtvis är inte klimatet en rent stokastisk process utan det finns också deterministiska inslag (lustigt hur tty inte vände sig till pek01 med det konstaterandet), men det finns stokastiska inslag som gör att även körningar av samma modell med snarlika indata ger något olika resultat. Ju längre tidsperiod man titta på desto mindre skillnad, men på skalan av ett decennium kan de vara betydande. Jag trodde det var uppenbart vad jag menade, men om folk inte ens vet vad en stokastisk process är kanske det inte var så klart.

Lars #20 Arrhenius hade tillgång till otillräckliga data och det saknades vid den här tiden en hel del teoretisk kunskap vilket gjorde att hans beräkningar var lite hispiga, men det förändrar inte att just vattenångans återkoppling var han på det klara med. Skall du hitta mer korrekta beräkningar får du gå fram till 30-talet.

” Sannolikheten är utomordentligt låg för utfallet att det ska bli så varmt som en majoritet av klimatmodellerna spår.”

Och hur vet du det?

Lars väljer att ignorerar större delen av min kritik, vilket inte direkt förvånar mig. Det är ju så mycket lättare att kalla någon för troll, dvs på en intolerant blogg är alla som inte delar den rätta tron troll.

Återkoppling er helt rigtig en væsentlig faktor.

Først tunes en model til datidens temperaturer. Derefter ændres datidens temperaturer , som medfører at modellerne må ændres så de passer til den nye temperaturserie. Osv, osv…..

En mærkværdighed: Tilsyneladende er temperaturen den væsentligste parameter i modellerne, men alt det vi skræmmes med er afledte effekter, som nedbør og storme.

Kunne man prøve at tune modellerne efter nedbør og storme, og så se hvad temperaturen blev?

Tror du Thomas P att våran klimatminister (och hennes föregångare) vet vad en stokastisk process är. Och vad den har för betydelse för att kunna förutse kommande klimat.

Thomas P # 21

”Lars väljer att ignorerar större delen av min kritik, vilket inte direkt förvånar mig. Det är ju så mycket lättare att kalla någon för troll, dvs på en intolerant blogg är alla som inte delar den rätta tron troll.”

Varför blandar du in UI i den här råden? Eller är det åter en projicering?

#21 Stokastisk process vet alla vad det är. Och vart Thomas vill komma med sina floskler om realiseranden av stokastisk process vet vi också. Att komma undan modellernas undermålighet.

Svempa #25 Säg snarare är ni som vill överdriva modellernas brister eftersom inte ens en modell som har klimatkänsligheten helt rätt skulle duga med Lars Kaméls sätt att argumentera.

Thomas 26

Hur skall någon veta vilken klimatmodell som har känsligheten rätt????

Slabadang!

Att läsarinna kommentarer är alltid upplyftande och får mig att le. Har just spenderat en hel dag på en konferens med den värsta sortens faktaresostenta klimathotare och behöver frisk luft. Att läsa vad du skriver hjälper mycket! Keep it up!