Systematiska problem i de fyra ”nationella bedömningarna” av klimatförändringarnas påverkan på USA

Bland de mest inflytelserika kompendierna om klimatförändringar och dess effekter är de fyra ”Nationella Bedömningarna” av globala klimatförändringseffekter på vårt land (USA). Dessa dokument har mandat från Global Change Research Act från 1990. Hittills har fyra bedömningar gjorts, och en femte är just nu i ett tidigt skede av produktionen.

Det är rättvist att säga att de fyra aktuella dokumenten representerar några av de mest allvarliga snedvridningar av vetenskapen i politikens tjänst som någonsin har publicerats. Denna korta sammanfattning kommer att dokumentera varför.

Den Första US Nationella Bedömningen (2000)

Den första (2000) nationella bedömningen använde modeller som var sämre än en tabell med slumpmässiga siffror när de tillämpades på tioårslöpande statistik för medellufttemperaturer i de kontinentala 48 US staterna. Med andra ord resulterade tillämpningen av dessa modeller i en mer felaktig representation av temperaturerna i USA än hade varit fallet om man bara använt rådata.

Följande analogi är fullständigt korrekt. Tänk dig ett flervalsprov med fyra val. Om dessa modeller användes för att svara på provets frågor hade de varit korrekta mindre än 25 % av tiden, vilket är vad man kan förvänta sig om varje fråga besvaras slumpmässigt. På något sätt lade modellerna som användes i den Första Nationella Bedömningen brus till rådatat, vilket är den exakta motsatsen till vad en riktig modell ska göra. Vetenskapsteamet som arbetade med den första bedömningen, under ledning av den väl respekterade Thomas Karl visste detta, men fortsatte ändå (1). Med tanke på att dessa dokument är mycket inflytelserika på nationell och internationell politik, var detta (jag väljer mina ord noga här) ett olovligt förfarande med hänsyn till vetenskaplig praxis (2). Den första nationella bedömningen använde också de två mest extrema modellerna gällande värden för temperatur och nederbörd, av dataföljden som undersöktes.

Den Fjärde US Nationella Bedömningen (2018)

Den andra (2009) och den tredje (2014) nationella bedömningen utsattes också för mycket kritik. Det som förtjänar mer uppmärksamhet här är de systematiska felen i den fjärde (2018) nationella bedömningen, som är för närvarande det aktuella dokumentet som utgör grunden för politikiska beslut.

Den Fjärde Nationella Bedömningen fokuserade, liksom de tre föregående, främst på prognoser från klimatmodeller. Citat från kapitel 2:

”De framtida projektionerna som används i denna bedömning kommer från globala klimatmodeller (GCM) som återger viktiga processer i jordens klimatsystem med användning av grundläggande vetenskapliga principer.”

Det följer att, om dessa modeller som ensemble systematiskt är felaktiga på ett betydande sätt, är det olämpligt att använda dem för att projicera effekterna av de klimatförändringar som de förespår.

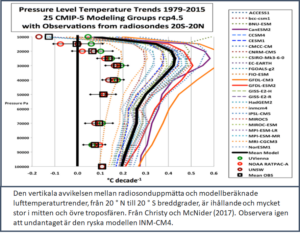

Den växande skillnaden mellan förutspådda bulkmätningar av troposfäriska temperaturer och observerade värden, särskilt vid hög höjd i tropikerna (se första figuren nedan), kastar ett omfattande tvivel över nyttan av den stora ensemblen av modeller som används i fjärde bedömningen. Den samlingen är känd som Coupled Model Intercomparison Project, Phase 3 (eller CMIP-3). Den genomsnittliga ”känsligheten” (mängden jämviktsuppvärmning för en nominell fördubbling av atmosfärisk koldioxid) är för dessa modeller 3,4°C.

På samma sätt visar den andra figuren nedan den vertikala fördelningen av de prognostiserade och observerade trenderna. Christy och McNider (3) kommenterar detta:

”I vartenda fall, med undantag av den ryska modellen ”INM-CM4″ under 250hPa, är de enskilda troposfäriska modelltrenderna större än observationsgenomsnittet under 100 hPa, med de största skillnaderna i övre troposfären …”

Den fjärde bedömningen ignorerar helt enkelt bästa vetenskapliga praxis, det vill säga att operativt använda modellerna som fungerar bäst jämfört med verkliga observationer. Denna typ av övning genomförs dagligen i prognosmeteorologi. Ofta ger många globala och regionala prognosmodeller motstridiga resultat för en viss vädersituation. Meteorologerna undersöker sedan vilka som har presterat bra, eller vilka som klarar sig bättre med tanke på situationen, och sedan beslutar för en eller en blandning av modeller för att nå den slutliga prognosen. Det händer ytterst sällan att de tar ett genomsnitt av alla, vilket är exakt vad fjärde bedömningen gör.

INM-CM4-modellen är definitivt en ljummen (engelska ”lukewarm”) modell. Dess uppskattning av det tjugoförsta århundradets uppvärmning är cirka 1,5°C. Detta överensstämmer med uppvärmningen som beräknats av Christy och McNider (3).

Betoning på fel framtida utsläppsprognos

Den senaste (2013) övergripande vetenskapliga bedömningen av den globala uppvärmningsfrågan av FN: s mellanstatliga panel för klimatförändringar (IPCC) använder sig av flera scenarier för framtida utsläpp. Den som förespår mest uppvärmning kallas Representative Concentration Pathway 8.5 (RCP 8.5), som antar en nettoökning av strålning för den lägre atmosfären på 8,5 Watt per kvadratmeter vid år 2100. Det lägsta scenariot som inte inkluderar en omedelbar begränsning av koldioxidutsläppen är RCP 4.5 (dvs. en ökning av strålningen med 4,5 W per kvadratmeter vid 2100). En enorm vetenskaplig litteratur har uppstått kring RCP 8.5, även om IPCC konstaterar att det är en osannolikt extrem prognos. Förra året förmildrade den auktoritativa International Energy Agency (IEA) RCP 8.5 och fann att den faktiska utsläppsbanan vi befinner oss på ligger något under det lägsta realistiska utsläppsscenariot (RCP 4.5). Scenario RCP 4.5 ger en total uppvärmning på bara 2,5°C från den industriella revolutionen till år 2100. Observera att en halv grads uppvärmning inträffade mellan 1910 och 1945, en period när koldioxidutsläppen var för små för att få sådana klimatiska konsekvenser. Det IEA egentligen säger är att den väg vi befinner oss på motsvarar en mänskligt inducerad uppvärmning på cirka 2,0°C till 2100. Det råkar vara så att det är just det som är målet för FN: s Paris överenskommelse (”fördrag”) om klimatförändringar från 2015.

IEA: s uppskattningar grundar sig på ett antagande om att uppvärmningsgraden (kallad temperaturens ”känslighet” för en fördubbling av atmosfärisk koldioxid) är 3,0°C. Men studier baserade på observerad strålning och temperaturförändringar av John Christy och Richard McNider från University of Alabama-Huntsville och Nic Lewis och Judith Curry, före detta ordförande för Earth and Atmospheric Science School vid Georgia Tech, ger en känslighet mellan 1,5°C och 1,75°C – nästan hälften av antagandet från IEA.

Dessa låga känsligheter, som är ”real world” beräkningar, tillsammans med IEA:s nya uppskattningar för minskade effekter av mänskliga utsläpp, förändrar effekterna av koldioxidinducerad klimatförändring från en nettokostnad till en nettovinst (4). Det här kanske är förklaringen till att, när yttemperaturen steg under 1900-talet, medellivslängden nästan fördubblades i den utvecklade världen och ökar nu dramatiskt i övriga världen.

Sammanfattning

De fyra ”Nationella Bedömningarna” av klimatförändringarnas påverkan på USA har dramatiskt överskattat effekterna av vårt förändrade klimat, till stor del då de använda klimatmodellerna är behäftade med systematiska fel, samt att man överskattar de förväntade förändringarna som mänskliga aktiviteter förväntas orsaka på överföring av strålningsenergi i den lägre atmosfären.

Dr. Patrick J. Michaels, Senior Fellow, Competitive Enterprise Institute

För vidare information

Michaels, P.J. and P.C. Knappenberger (2016): Lukewarming: The New Climate Science That Changes Everything, Cato Institute:Washington, DC.

Översättning: Stephen Wilks

Fotnoter

(1) Karl skrev till mig att ”vi körde testet du gjorde men ändrade genomsnittsperioden” från 10 års löpande medel till 1, 5, 10, 20 och 25 år. Han var vänlig nog att bifoga en graf som visade att vid alla tidsintervaller som testades var den återstående variansen efter applicering av modellerna större än den råa variansen. En modifierad version (för tydlighetens skull) finns som Figur 25, sidan 109 i Michaels (2016). Detta dokumenterades först i “Science or Political Science? An Assessment of the U.S. National Assessment of the Potential Consequences of Climate Variability and Change,” in Gough, M., Ed. (2003), Politicizing Science: The Alchemy of Policymaking. Hoover, Palo Alto.

(2) Åtgärden var den precisa motsvarigheten till att en läkare skulle ordinera ett läkemedel som han eller hon vet kommer att göra patienten sämre.

(3) Christy, J.R., and R.T. McNider (2017): Satellite bulk tropospheric temperatures as a metric for climate sensitivity. Asia-Pacific Journal of Atmospheric Science, 53, 511-518.

(4) Dayaratna, K.D., R. McKitrick, and P.J. Michaels (2020). Climate sensitivity, agricultural productivity and the social cost of carbon in FUND. Environmental Economics and Policy Studies 22, 433-448.

Det är bara att tacka för och än en gång få ta emot en svensk översättning av en av de värdefulla broschyrerna som Trumpadministrationen gav världen som en sista (?) gåva – en gåva som President Biden tackade för på sitt mycket speciella sätt genom att omedelbart söka utplåna. Ett ytterligare exempel på en aktuell variant av bokbål för att hindra det omhuldade så kallad Fria Ordet.

Tack för arbetet med översättningarna och att källorna finns bevarade här på bloggen.

P.S. Nu har Ad Libris meddelat att ”Hot Talk Cold Science” finns att beställa D.S.

Tack för översättningen.

Att modellera ett komplex system är svårt.

Inte ens dagliga variationer med moln klarar de av:

https://wattsupwiththat.com/2021/03/03/high-end-of-climate-sensitivity-in-new-climate-models-seen-as-less-plausible/

Man kan ju klart se att klimatmodellernas prognoser inte har med verkligheten att göra. I ljuset av detta är RCP 8.5 en fars, men ändå en styrande tes bland klimatforskare och övriga troende på AGW. En verklig förändring i klimatforskarnas dogmatiska tro på CO2 som enda drivande faktor, kan bara fås först när man inser kopplingen mellan solens variabla UV och påverkan på atmosfärisk cirkulation genom stratosfären.

Verkligheten visar att utan klimatmodellsimuleringar finns inget klimathot och inget klimatnödläge. Eftersom det behövs många klimatmodeller så är det ingen som vet hur klimatet fungerar. Meteorologer förstår hur vädret fungerar de närmsta dagarna, kanske 10 dygn, men inte hur vädret är om 1 månad och absolut inte om 80 år.

Både vädret och klimatet har ju ett kaotiskt beteende.

I princip innebär det att det finns flera olika väder/klimat som energimässigt ligger nära varandra, men utfallsmässigt skiljer sig rätt mycket åt.

Givet randvärdena (solinstrålning, termisk utstrålning från markytan) så finns det flera olika klimat som är möjliga.

En intressant egenskap hos kaosprocesser är att de saknar medelvärde. Det konvergerar inte.

Om man tar en tioårsperiod så får man ett värde. ökar man till en trettioårsperiod så får man ett annat. Tar man en hundraårsperiod ett tredje värde. Då kan det vara så att hundraårsvärdet ligger längre ifrån tretioårsvärdet än från tioårsvärdet.

I en kaosprocess så finns det inget värde som representerar det ”sanna” medelvärdet, eftersom det inte finns.

Att försöka göra datormodeller för kaotiska processer är dömt att misslyckas. Man kan få vilket svar som helst.

Klimatmodellerna har ju infört nån slags ofysikaliska dämpningsfunktioner som ska hindra att lösningen driver iväg. När man gjort det så har man lämnat den riktiga världen. Det är något annat man har i modellerna.

Jonas [5]; Nej, allting som gäller väder och klimat är inte kaotiskt, även om det finns inslag av kaotiskt beteende. Strömningar i vatten och atmosfären följer sina banor vilka är utstakade av topografiska förhållanden, påverkade av jordrotationen och den drivande termiska dynamiken. System som Golfströmmen, ENSO, NAO, Hadley, Polar Wortex, Brewer-Dobson cirkulation etc, finns där av strukturella orsaker. Men den variabla faktor som ytterst driver den termiska dynamiken, är solen.

Jag skulle nog säga att det mesta som gäller väder är kaotiskt. Det finns få säkra cykliska fenomen, egentligen bara årscykeln och milankovichcyklerna, alltså rent astronomiska effekter.

Sedan har vi också åtskilliga fenomen som är kvasicykliska, som alltså återkommer, men med varierande intervall, såsom ENSO, PDO, NAO, The Indian Ocean Dipole och The Agulhas leakage.

En liten synpunkt på datormodellering, som baserar sig på personlig efarenhet, visserligen av modellering av mycket enklare processer än klimat: modeller med mer än max tre parametriserade variabler är fullkomligt värdelösa. Du kan i stort sett få vilka resultat som helst.

#7 tty

Absolut. Här fyra parametrar och sen ”wiggle his trunk”. Von Neuman ”With four parameters I can fit an elephant, and with five I can make him wiggle his trunk.”

#8

Här har vi den:

https://www.youtube.com/watch?v=CVDYh5liQkA

#9 Den här versionen är lite längre

https://www.youtube.com/watch?v=KfNPAXplLbc

#6 Björn,

Det håller jag med om. Det finns ett mönster i väderfenomenen.

Det jag påstår är kaotiskt är jordens medeltemperatur.

Det jag menar med kaotiskt är att för givna randvärden, så finns det flera olika lösningar som stämmer.

Ämnet är lite komplext och det känns som att det är svårt att i detalj förklara vad jag menar i en blogg. Det som är bottom line är att jorden kan ha många olika temperaturer och ändå vara i strålningsbalans.

Idag är det 15C som ger strålningsbalans. Det kan lika gärna vara 10 eller 20C och man har strålningsbalans.

Kravet på att jorden ska ha strålningsbalans bestämmer inte jordens medeltemperatur.

Det är ett fundamentalt problem som klimatmodellerna brottas med. Det beskrevs också i an artikel här på bloggen.

https://klimatupplysningen.se/kan-datormodeller-forutsaga-klimat/