Den norska forskargruppen består av klimatforskare och statistiska matematiker. De har använt sig av alla upptänkliga observationer tillsammans med en relativt enkel klimatmodell, en så kallad energibalansmodell där klimatkänsligheten är en av de ingående parametervärdena. De har anpassat parametervärdena i klimatmodellen till observationerna genom att använda Bayesiansk statistik. De fick då jämviktsklimatkänsligheten (ECS=Equilibrium Climate Sensitivity) till 1,8 grader C (0,9-3,2 grader C med 90 % sannolikhet) för fördubbling av koldioxidhalten.

Artikeln av Skeie et al. (2014) är publicerad i den geovetenskapliga tidskriften Earth System Dynamics. Tre av författarna tillhör klimatforskningscentret CICERO vid Universitetet i Oslo, Terje Berntsen, Gunnar Myhre och Ragnhild Bieltvedt Skeie. De två andra författarna är statistiska matematiker som tillhör Norsk Regnesentral, Marit Holden och Magne Aldrin.

Det inger förtroende att klimatforskarna här samarbetar med statistiska matematiker som är skickliga på Bayesiansk statistisk. Tanken är att använda en klimatmodell som innehåller klimatkänsligheten som en parameter och att ta reda på värdet på klimatkänsligheten genom att anpassa modellen till observerade data. För att göra detta korrekt med Bayesiansk statistik så behövs det expertis på statistisk matematik.

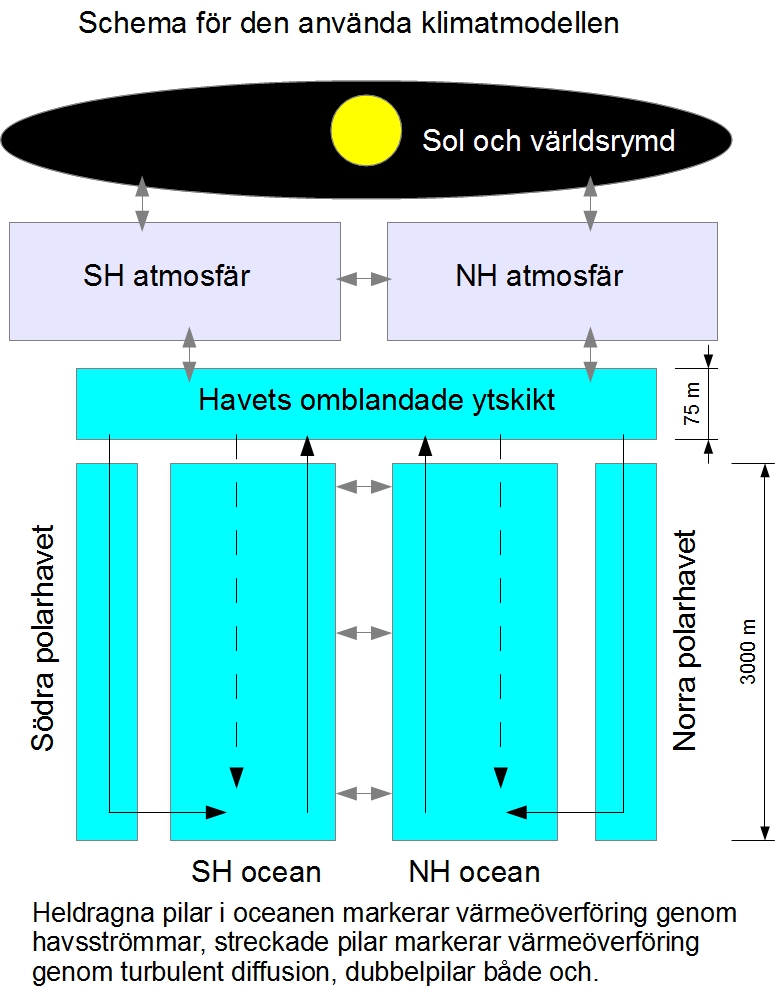

Magne Aldrin (2010) har gett en presentation av den metod som de använder vid en workshop i Cambridge, Storbritannien 2010. Den enkla klimatmodellen är inte av de allra enklaste slaget, atmosfären är uppdelad i norra och södra halvklotet. Modellen av oceanen är ändå mer komplicerad och uppdelad i södra polarhavet, södra halvklotets huvuddel, norra halvklotets huvuddel och norra polarhavet. Följande bild ger ett ungefärligt schema för denna klimatmodell (de angivna måtten är bara tänkbara exempel).

Denna enkla klimatmodell har enligt tidigare studier som citeras i Skeie et al. (2014) kunnat reproducera simuleringar med avancerade klimatmodeller. Anledningen till att man för en sådan här anpassning av modellparametrar till observerade data inte använder en avancerad klimatmodell direkt, är att sådana modeller är mycket komplicerade och kräver för mycket datorkapacitet. Ett sätt att lösa detta problem är att göra som författarna har gjort, man använder en enklare modell som man har konstaterat vid simulering kan reproducera avancerade klimatmodellers resultat.

Klimatmodellen innehåller klimatkänsligheten vid jämvikt (ECS=Equilibrium Climate Sensitivity) som en okänd parameter och ytterligare sex parametrar som har med värmeflödena i oceanen att göra. Man behöver också strålningsutbytet mellan atmosfärens överdel och solen och världsrymden. Denna typ av data är det som kallas ”radiative forcing” och som klimatforskningen har ägnat stora ansträngningar att bestämma, men osäkerheterna i data är fortfarande stora. Som bekant är det inverkan av ökade halter växthusgaser i atmosfären som främst påverkar denna ”radiative forcing” och som man har ganska bra data för men också exempelvis ändrade aerosolhalter påverkar och där är osäkerheten mycket större.

Har man värden på dessa sju parametrar och en kurva på hur ”radiative forcing” varierat med tiden sedan förindustriell tid så kan denna enkla klimatmodell räkna ut hur temperaturen har varierat både på norra och södra halvklotet och hur värmeinnehållet i oceanen har förändrats. Man kan sedan ändra på parametervärdena, varvid man framförallt är intresserad av klimatkänsligheten, inom tänkbara felgränser, samt även variera ”radiative forcing” inom sina felgränser. På detta sätt kan man se för vilka kombinationer av parametervärden man får kurvor för temperaturerna och oceanens värmeinnehåll som stämmer med observationerna. Det är detta som kallas parameteranpassning.

Det är sådan parameteranpassning som statistiska matematiker kan hjälpa till med att göra på ett professionellt sätt och verkligen utnyttja kunskaperna om Bayesianska metoder för att få bästa möjliga resultat. På detta sätt kan man bestämma ett sannolikhetsintervall för klimatkänsligheten, i detta fall kan man om ECS säga att det sannolikaste värdet är 1,8 grader C för en koldioxidfördubbling och att med 90 % sannolikhet ligger värdet mellan 0,9 och 3,2 grader C (att jämföra med FNs klimatpanels (IPCCs) intervall att med 66 – 100 % sannolikhet ligger värdet mellan 1,5 och 4,5 grader C).

De observationer som författarna har använt för sin studie är dels sex temperaturserier: HadCRUT3, NCDC och GISS för norra respektive södra halvklotet (det är ett omfattande vetenskapligt arbete som tagit lång tid att genomföra, därför har inte HadCRUT4 kunnat användas genomgående utan endast för en tilläggsanalys), dels data för oceanens värmeinnehåll från Levitus forskargrupp vid NOAA samt två andra forskargrupper. Det är alltså oerhört mycket data som man anpassar modellparametrarna till. Man har även, vilket är möjligt i en Bayesiansk analys, tagit med data för oceanparametrarna som bygger på oberoende observationer som ingångsdata (så kallad ”prior probability distribution”).

Resultatet för jämviktskänsligheten ECS är lågt, 1,8 grader C för en fördubblad koldioxidhalt, men speciellt anmärkningsvärt är att osäkerhetsintervallet, 0,9-3,2 grader C, är kortare än i andra liknande studier. Jämför till exempel med den omtalade nypublicerade studien av Lewis och Curry som fick 1-4 grader C.

Författarna studerade därför hur resultatet varierade med var data slutade. Om de använde data endast fram till år 2000 fick de en något högre klimatkänslighet men framförallt blev osäkerhetsintervallet mycket längre.

De föreslår därav en förklaring till varför det är så. Det beror dels på att ”radiative forcing” har stigit betydligt under senaste decenniet så att relativa felet i denna har minskat. Den andra bidragande orsaken är att tillgången till data för värmeinnehållet i oceanen ökat med 20 % (beroende på att mätserien börjar omkring 1950). De säger alltså inte att den minskade längden på osäkerhetsintervallet skulle ha att göra med uppvärmningspausen.

Den transienta klimatkänsligheten är också av intresse eftersom det är denna som enligt teorin i första hand bestämmer hur temperaturen kommer att öka med ökade växthusgashalter inom 50 till 100 år. Man använder som mått på denna klimatkänslighet temperaturhöjningen som beror på hur temperaturen påverkas av en ändrad koldioxidhalt med 1 % per år (dvs. 400 ppm ökar på ett år till 404 ppm). Klimatkänslighetsmåttet kallas TCR (Transient Climate Response) och anger temperaturhöjningen vid den tid när koldioxidhalten fördubblats, vilket med 1 % per år tar cirka 70 år.

Skeie et al. fick för TCR värdet 1,4 grader C med 90 % sannolikhet för att värdet ligger i intervallet 0,8-2,2 grader C. Även i detta fall blev osäkerhetsintervallet längre, nästan 70 % ökning, om endast data fram till år 2000 användes.

Det mest spännande med denna mycket förtroendeingivande studie tycker jag är den redan omnämnda jämförelsen med FNs klimatpanel klimatkänslighetsintervall, dvs. att klimatkänsligheten sannolikt, med 66-100 % sannolikhet, ligger mellan 1,5 och 4,5 grader C. I den senaste vetenskapliga sammanfattningen för beslutsfattare (Summary for Policymakers, SPM) skriver man mer exakt:

Equilibrium climate sensitivity is likely in the range 1.5°C to 4.5°C (high confidence), extremely unlikely less than 1°C (high confidence), and very unlikely greater than 6°C (medium confidence).

(likely = 66-100 % sannolikhet, extremely unlikely=0-5 %, very unlikely = 0-10 %).

Den här presenterade studien har i stället kommit fram till att med 90 % sannolikhet ligger klimatkänsligheten mellan 0,9 och 3,2 grader C. Skillnaden mot FNs klimatpanel intervall på 1,5-4,5 grader C är anmärkningsvärd.

Referenser

Skeie RB, Berntsen T, Aldrin M, Holden M, Myhre G (2014) A lower and more constrained estimate of climate sensitivity using updated observations and detailed radiative forcing time series. Earth Syst Dyn 5:139–175. doi:10.5194/esd-5-139-2014

Aldrin M. (2010) Bayesian estimation of the climate sensitivity based on a simple climate model fitted to global temperature observations. Cambridge workshop, december 2010.

Finns det några beräkningar på den globala medeltemperaturen vid den senaste istiden?

Pehr, det låter nästan som om du berömmer OH?

Är undersökningen tillförlitlig? Jag tänker så här, värmekapaciteten i haven är mycket stor. Minsta lilla temperaturförändring i haven får en enorm effekt på den totala mängden energi som kommit in systemet. Vi kan inte mäta havets temperaturförändring ens idag med någon större noggrannhet, hur har man då uppskattat den bakåt i tiden?

Tror ni KLOTET gör någon inlägg i still med att ”det är inte så illa trots allt” ? Eller släpper man fram någon ”de är värre än vi trodde” för att ”balansera” . Brukar ju dyka upp 9m havsnivå eller 11 grader för att redaktionen inte skall tappa modet allt för mycket … Men man kan ju alltid suga fast vid övre spannet så

slipper man kommentera – det ligger ju inom AR5 spannet – frid och fröjd…

Vad tror ni ?

CO2 skall enligt teorin ha en logaritmisk påverkan på strålningsbalansen.

Varför använder man då en linjär modell för TCR?

Har de använt det för ECS också?

Hm… jag brukar inte läsa sagde OH’s funderingar, men minns att jag vid ett tillfälligt besök på inhägnaden eller hans egen finare och mer intellektuellt högstående blogg läste att han också sade sig jobba på samma sak, med samma metodik – med svenska ”klimatforskare”.

Ska man lägga ett vad på att de bjuder över norrmännen (om samarbetet resulterar i något)?

Sättet att ange koldioxidhöjningen till 1 % är verklighetsfrämmande. Det innebär en accelererande ökning från 4 ppm per år nu till 8 ppm per år om 70 år.

Eftersom återflödet till hav och land ökar med ökad koncentration innebär det att eldandet med fossila bränslen måste öka med kanske fyra gånger i förhållande till nu.

Med vilka ändliga bränslen har man tänkt att allt det eldandet skall ske?

Koldioxidhalten kan ej bli långsiktigt accelererande.

Ökningstakten kanske saknar betydelse för klimatkänsligheten. Men den är av avgörande betydelse för hur framtiden kan komma att se ut.

Lars Cornell, #7:

Du lyfter den fråga som jag menat är in absurdum orimlig i IPCCs antaganden, nämligen framtida utsläppstakt av CO2. Föreslår att du tittar i SRES. Fall bara inte i fällan att tro att detta handlar om ’mängder’ fossila bränslen för då är det inga problem att nå över 8 ppm/år om 70 år…

Peter Stilbs, #6:

Jag tror det är låga odds på ett sådant vad även om UI faktiskt flertalet gånger har uppmärksammat studier som indikerar lägre klimatkänslighet: http://uppsalainitiativet.blogspot.se/2013/05/lagre-klimatkanslighet-enligt-ny-tung.html Denna hade en känslighet på neråt 0.9 C.

Här har ni chansen att ställa knepiga frågor. Blir spännande se i vilken utsträckning skeptiska frågor släpps fram

http://www.smhi.se/2.2428/2.2968

Intressant Pehr.

Detta att osäkerheten ökar när det uppkommer en paus är nog ett sätt att visa att pausen är oberäkningsbar.(men återkommande med visst intervall)

Science is ??

I en annan del av Norden pågår en samling för att skriva ihop IPCC rapport som underlag för 2015 års möten. Inget nytt bara omskrivning så alla blir nöjda sägs det i Radion.

Är det Halloween idag-det passar bra med rapporten.

Tricks or treat.

Skall banne mig välja Tricks för att se vad barnen gör då godiset uteblir!

Fortfarande handlar det om klimatkänslighet bundet till fördubblad koldioxidhalt. Tänk om grunden för detta tänkande är helt felaktigt, då bygger tusentals rapporter på samma felaktigt tänkande. Att koldioxiden ökar är det inget tvivel om, men har denna ökning i grunden den drivning av klimatet som påstås? Hardes rapport härom dagen var ett nytänk där solens och molnens betydelse fanns med som variabler. Klimatforskningen behöver en ny ansats, men den kan först byggas med hjälp av data från nya satellitobservationer som både riktas mot solen och jorden. Vad händer om vi nu går mot ett konstant solfläcksminimum under 70 år, som var den tid som Maunder minimum varade? Är detta inte en variabel att ta hänsyn till? Den obalans i den atmosfäriska cirkulationen som nu skylls på ”klimatförändringarna”, alltså ökningen av CO2, är i stället ett tecken på solens minskande aktivitet. Oroar inte detta någon?

Myggor och kameler!

Jaha ja ??? … Jag är numer luttrad och erfaren och är mer fascinerad av hur många ”klimatforskare” som måste ha nån typ av sysselsättning genom AMS? Betänk att vi har bara tre enkla mätserier från havsnivåmätningar den bästa av dessa är tidvattenmätingarna och som komplement Argo och satelliter. Det räcker faktiskt med ett snabbt ögonmått av kurvorna för att avgöra att det INTE föreligger någon acceleration och inget onormalt eller avvikande överhuvudtaget i någon av mätserierna. Men det stoppar ju inte sysselsättningsmålen det minsta !! Nej för helskotta … här sitter nu tusentals ”klimatanalytiker” och styckar klipper och klistrar och söker efter svar och slutsatser som inte finns i mätserierna att finna! Men de har nog gett sig fasen på att nånstans i det statistiska bruset så ska de hitta sin ”signal”.

Varför jag stoppar även denna beräkning av ”klimatkänsligheten” (vilket dj… la begrepp!) i papperskorgen är den uppenbara OFULLSTÄNDIGHETEN när tex INTE vare sig befintlig molndata eller någon hypotes om dess globala förändringar innan 1983 är redovisad eller beräknad.

Det finns nog få vetenskapliga dicipliner som lurat både sig självt och allmänheten så grovt om vad den vet och behärskar. Ta de ”dramatiska förändringarna i Arktis vi nu ser” jaha … det är klart det är ju JÄTTEDRAMATISKT !!?? …. enda tills man framkallar fotografierna från Nimbussatelliten som skickades upp 1964 … och vi får bildbevis på att 1966 var Antarktis isutbredning till och med större än det vi kallar ”rekord” idag, för att bara tre år senare uppvisa ett rekordminimum understigande vad vi känner som ett verkligt satellithistoriskt ”klimatrekord”. Så var finns dramatiken ??? Ingenstans naturligtvis och fanns den så var den då större under sextiotalet än under satelliteran. I Arktis visar fotografierna från sextiotalet gigantiska hål i Isen runt Nordpolen och vi vet ju att våra första atomubåtar hade meeting i öppet vatten där och utgör en ytterligare bekräftelse på denna observation.

Så … när det kommer artiklar som påstår sig baseras på ”observationer”, så finns det ett antal luckor som måste räknas för att man överhuvudtaget skall kunna ta den på allvar eller förstå hur teoretiskt begränsad den faktiskt är. Jag låter bli att nämna de artiklar so baseras på ”studier” av ”klimatmodeller” som mer är ta på lika litet allvar som horoskopen i dagstidningarna.

Vad som är uppenbart är att hela klimatvetenskaen är urspårad och har INTE EN SUSNING om våra naturliga klimatförändringars storlekar frekvens och hastighet till en storleksordning där de kan skilja mellan vad som är naturligt eller mänsklig påverkan. En klok politiker använder sunt förnuft och tar ett samhällsansvar som inbegriper ett civilförsvar som klarar av extremväder och temperaturer år båda håll. Nu satsar de bara på en häst och den har svår hälta på att det ska bli varmare.

Betänk att hela klimathypen och grunden för västvärldens energipolicys utgick ifrån att det fossila bränslena skulle bli allt dyrare och allt mer sällsynt. Nu står vi här i den raka motsatta verkligheten översköljda av billiga fossila nyupptäckta/nytillgängliga resurser och de två tekniker vind och sol är hopplöst självklart bevisade ickealternativ som ställer till både miljömässiga energiförsörjningsmässiga och ekonomiska helveten för de ekonomier som drabbas av dem. När skall våra politiker inse att risken för att det blir kallare ger större problem än när det blir varmare?

SR:

”På söndag kommer FN:s klimatpanel, IPCC, att presentera en slutgiltig sammanfattning av de tre ingående rapportdelarna om jordens klimat. Tanken är ge en lättbegriplig bild av klimatförändringarna, men in i det sista är det osäkert vad den till slut kommer att innehålla.”

http://sverigesradio.se/sida/artikel.aspx?programid=406&artikel=6005555

Men var inte alla eniga om klimathotet? Att kunskapsläget var tillräckligt för att ställa om hela världen. Budskapet om 97% och annat har trumpetats ut i många år i medierna. Och nu sitter de och funderar på som skall vara med. Varför det?

11

Björn

Oroar inte detta någon?

Inte speciellt. Finns inget dåligt väder bara dåliga kläder, right?

Gustav #2,

Ha, ha, jag förstår vad du menar men så är det nog inte. Jämför detta:

http://sv.wikipedia.org/wiki/Honour_by_association

Vad jag kan förstå av denna studie är att det är dessa statistiska matematikers skicklighet med den statistiska analysen som kan förklara varför de får ett noggrannare resultat med ett lägre liggande och betydligt kortare osäkerhetsintervall för klimatkänsligheten än Lewis och Curry. De har visat att den statistiska analysen verkligen kan ge något mer.

Dessutom får de fram detta med att det finns början till en trend i hur osäkerhetsintervallet förändras med tiden när nya mätningar kommer till. Trenden är att osäkerhetsintervallet blir kortare med tiden genom att den övre gränsen minskar.

När de använde data endast fram till år 2000 blev den övre gränsen 5,6 grader C för ECS, när alla data fram till 2010 användes sjönk den till 3,2 grader C. Detta är ju en uppseendeväckande stor minskning av den övre gränsen för klimatkänsligheten. Det skall bli intressant att se vad som händer när data fram till 2015 används.

HenrikM #3,

Det är riktigt att osäkerheten i hur havets värmeinnehåll förändras är stor och att den var ännu större tidigare. I denna studie har man använt data som börjar omkring 1950 och tagit hänsyn till de stora fel som finns i dessa data på ett, så långt jag kan bedöma, statistiskt skickligt sätt. Därför bedömer jag att studien är tillförlitlig ur denna synpunkt.

#12 Slabadang!

—- snip —

Vad som är uppenbart är att hela klimatvetenskaen är urspårad och har INTE EN SUSNING om våra naturliga klimatförändringars storlekar frekvens och hastighet till en storleksordning där de kan skilja mellan vad som är naturligt eller mänsklig påverkan.

—- snip —

Självklart. Det är ju precis därför som de kan påstå vad som helst. Perfekt läge. Anything goes

Påminner mig starkt om alla som försökt räkna ut det perfekta roulette/pokersystemet och havererat…det finns för många rutor och kort…och klimatet är långt mer komplext…stäng av datorerna och på med huvet.

Stickan no 1 #5,

Jag vet inte vad en ”linjär modell för TCR” skulle kunna vara för något.

De har använt en definition på TCR som innebär att för ett givet värde på TCR så kommer temperaturändringen att variera approximativt logaritmiskt med koldioxidhalten. En fördubblad koldioxidhalt ger temperaturökning på TCR grader C. Ökning av koldioxidhalten 4 gånger (2^2) ger en temperaturökning på 2*TCR. Ökning av koldioxidhalten 8 gånger (2^3) ger en temperaturökning på 3*TCR. Om koldioxidhalten ökar 2^N gånger så ökar temperaturen N*TCR.

Vetenskapsradion just nu:

Skogsdöd som resultat av klimatförändringar fick det inte heta-däremot som resultat av torka och värme.

En IPCC studie visar på karta på en lokal söder om Oslo.

Nu är de där men professorn förnekar att det är skogsdöd eller unikt.

Nån hade fångat upp en rapport som nu hårddrogs av IPCC.

Professorn gillar det inte.

Värsta skadorna fick de på 40 talet!

Ridå!

Radion gör en kritisk granskning av IPCC-Kors i taket!

Varför får ingen fram siffror på en möjlig negativ klimatkänslighet?

Det verkar som att en hypotetisk klimatkänslighet kan utsträckas uppåt i oändlighet, men aldrig nedåt under 0, varför?

Lars Cornell #7,

TCR är bara en konvention för att mäta hur temperaturen ökar när koldioxidhalten ökar gradvis. Måttet har kommit till som ett sätt att karakterisera klimatmodeller i stället för eller som komplement till att man i dessa modeller låter koldioxidhalten fördubblas momentant.

TCR avspeglar bättre vad som kan hända när koldioxidhalten ökar gradvis som den gör i verkligheten.

Om teorin är riktig så bör TCR inte vara känslig för om koldioxidhalten ökar 1 % per år, eller 0,5 % per år eller om den ökar linjärt med säg 2 ppm per år. Man bör få approximativt samma värde i alla fallen.

TCR är alltid betydligt lägre än ECS. Detta beror på havens inverkan, att TCR blir lägre beror på att haven har en kylande effekt som på mycket lång sikt försvinner, vilket gör att ECS blir högre.

Men du har rätt i att en exponentiell ökning av koldioxidhalten med 1 % per år är ett orealistiskt scenario.

Lasse #20

Skog är nog inte vad som bekymrar pk-maffian runt Hornstull, det finns betydligt värre hot.

https://www.systembolaget.se/Dryckeskunskap/Om-vin/Klimatklockan-klamtar/

Pehr22, ” hur temperaturen ökar när koldioxidhalten ökar”

HUR förklarar du att temperaturen inte ökat alls, under den period CO2 ökat från 360 till 400ppm?

40ppm – med noll effekt på temperaturen!

#24 Är det en fråga?

Även om CO2 styr en del så finns det annat som styr också.

Vi såg en liknande period med sjunkande temperaturer på 50-70 talet.

Nu sjunker inte temperaturen men planas ut.

Det vore kul att göra en uppskattning på denna skillnad och se på klimatsencitiviteten utifrån detta!

http://www.woodfortrees.org/plot/hadcrut4gl/from:1900/to:2014

#23

På medeltiden ville fransmännen införa importtullar mot billigt engelskt vin.

Vi kanske snart är där igen.

Lasse #10,

Den enda jag har hittat i artikeln om uppvärmningspausen är i referenslistan under beteckningen ”hiatus” (det är ju ganska kul att de som förnekar betydelsen av uppvärmningspausen måste finna sig i att självaste Kevin Trenberth publicerar vetenskapliga artiklar som sagda paus):

Meehl, G. A., Arblaster, J. M., Fasullo, J. T., Hu, A., and Trenberth,

K. E.: Model-based evidence of deep-ocean heat uptake during

surface-temperature hiatus periods, Nat. Clim. Change, 1, 360–

364, doi:10.1038/nclimate1229, 2011.

Jag konstaterar själv i mitt blogginlägg att författarna inte hänvisar till uppvärmningspausen som förklaring till att osäkerhetsintervallet blev kortare när alla data fram till 2010 användes jämfört med om man använde data endast fram till 2000. Som jag skrev #15 i svar till Gustav så beror denna förkortning av osäkerhetsintervallet för ECS att den övre gränsen minskar från 5,6 grader C till 3,2 grader C (medan den undre gränsen minskar marginellt). Denna förkortning av intervallets längd menar författarna beror på att noggrannheten ökar på grund av alla nya data som tillkommit för ”radiative forcing” och havens uppvärmning under tioårsperioden.

Men man kan också se från resultaten i artikeln att medelvärdet på ECS också minskar under tioårsperioden. Om data endast fram till 2000 användes blev medelvärdet för ECS 2,2 grader C, men med alla data fram till 2010 blev detta medelvärde som sagt 1,8 grader C.

Även om författarna inte säger något om detta så tycker jag allt tyder på att uppvärmningspausen bör vara en starkt bidragande orsak till denna minskning i ECS-värdet.

#24,#25 + Pehr

Tänket är följande. mer CO2 i atmosfären gör det varmare pga växthuseffekten.

Kanske en summering och vad vi står just nu kan vara på sin plats.

C02 är en växthuseffekt.

Jomenvisst. Både matematiska formler och labbförsök har bevisat att så är fallet.

Vad händer då om man använder samma formler i naturen? Samma sak naturligtvis. Men.. och det här är problemet. Det finns mer grejer i naturen än CO2. Här slutar liknelsen mellan laboratoriet och verklighet.

Ett av generalfelen är just att man tror att CO2 är styrande och dominerande storhet i klimat. Kimathotarna har dessutom tunnelseende och är singelminded. Focus CO2.

Jag är inte förvånad att globala temperaturen och CO2 spretar åt skilda håll. Jag har förväntat mig det. Jag är heller inte förvånad att man hävdar att värmen försvinner i havsdjupen. Det har jag också förväntat mig. Nu kan man inte mäta det men är det som borde hända när mer energi kommer in i systemet. Här kan det finnas tusen år innan det dyker upp igen och då är det förmodligen kallare. Kanske den extra energin då kan försena en börjande istid eller sluta en pågående.

Sen det här att man har väldigt lite koll. Molnen, CO2, det olika luftlagren. atmosfärens skiktningar och utbyte , osv, osv. Det finns så otroligt många system som påverkar varandra. Vad är troligast allt detta utbyte syftar till. Jo utjämning som skapar stabilitet. Att slå ut allt detta krävs mer än en tändsticka i en gymnastiksal. Solkräm och gummistövlar. Och du har förberett dig för alla eventualiteter vädermässigt.

Men, jag ser framemot fler ledtrådar. Min mening är inte att döda nyfikenheten på klimatet utan att avdramatisera det.

Lasse # 20

Tack för radiotips!

Där ser man vikten av att läsa IPCC rapporter noggrant. Bör spridas, tycker jag.

http://sverigesradio.se/sida/avsnitt/451725?programid=412

Lasse #20

Jag lyssnade på vetenskapsradion också.

Reportaget var OK, överraskande nog. Även om det låter som om reportern försöker slå knut på sig själv för att få fram att klimatförändring skadat skogen, så låter han ju forskarnas svar tydligt dementera det. Den norske professorn får ju till och med avrunda med att säga att om IPPC:s prognoser stämmer så kommer vår skog i Skandinavien att växa bättre med mer nederbörd och mer värme. Han lade till nedfallet som man tidigare trodde skulle ge försurning och skogsdöd, men som istället visat sig göda skogen så den växer så det knakar.

Skämmas fick IPPC där en ansvarig fick erkänna att det inte finns ett spår av att skog tagit skada vare sig i världen eller Europa, som en följd av systematisk klimatförändring. Kartbilden i rapporten över skadad skog är alltså starkt bedräglig, framgick det. Den visar helt normala skador som alltid funnits och inte ökat. IPPC-mannen försvarar lamt det hela med att de bara visar ATT skog kan skadas, och kommer att göra det OM vissa klimatbetingelser uppfylls. Men givetvis ser inte läsaren kartan så.

#12 vart hittar man satellitbilder tagna över Ark

tis från 60-talet…..NSIDC har bara färska. ..

http://www.kth.se/aktuellt/nyheter/skogens-foradlare-blir-hedersdoktor-1.510264

Jamför:

http://sv.wikipedia.org/wiki/Sverker_Martin-L%C3%B6f

Lite off-topic men ändå inte. Har snubblat över en mycket intressant aktiv, etablerad forskare som lite diskret punkterar än det ena än det andra i AGWs antaganden OCH han får det publicerat!!!!!

Här är ett smakprov: ”we will document that the planetary energy imbalance of F = 0.58 +/- 0.15 W/m^2 calculated by Hansen et al. does not exist. Consequently, the implications related to this planetary energy imbalance have no basis.” Ord och inga visor! Gerhard Kramm är hans namn.

http://www2.gi.alaska.edu/~kramm/

Peter #9, Jag gick in på den sidan. Där finns en lista med sexton(16) ”klimatexperter” som skall svara på frågor.

Experterna är:

Reino Abrahamsson, Naturvårdsverket

Sten Bergström, SMHI

Pelle Boberg, Naturvårdsverket

Lars Bärring, SMHI

Henrik Carlsen, Stockholm Environment Institute (SEI)

Ralf Döscher, SMHI

Ingrid Gudmundsson, SMHI

Richard Klein, Stockholm Environment Institute (SEI)

Joakim Langner, SMHI

Marianne Lilliesköld, Naturvårdsverket

Lena Lindström, SMHI

Kenneth Möllersten, Energimyndigheten

Gunn Persson, SMHI

Markku Rummukainen, SMHI/Lunds universitet

Patrick Samuelsson, SMHI

Gustav Strandberg, SMHI

Kan den listan ge en ledtråd om VAD en ”klimatexpert” är för någonting..??

VAD är en klimatexpert?!

VAD är en klimatexpert?!

Min gissning. En som tror på klimathotet.

Mats G #28,

”Men.. och det här är problemet. Det finns mer grejer i naturen än CO2. Här slutar liknelsen mellan laboratoriet och verklighet.”

Jo, jag håller med om att detta är teorins verkligt svaga punkt. Men jag anser också att en mycket stor svårighet är att klimatet ändrar sig så långsamt. Om säg trettio år så kommer man förhoppningsvis att kunna testa teorin på ett adekvatare sätt men med dessa långa väntetider blir ju klimatvetenskapen något av ett unikum inom naturvetenskapen.

”Klimathotarna har dessutom tunnelseende och är singelminded.”

Jag tror det är mycket mer komplicerat än så. All den verksamhet som växt upp kring klimatfrågan gör att det skapats en snårskog med särintressen av många olika slag. Där har Jacob Nordangård med sin forskning gjort mycket för att vi skall få en bättre bild a situationen.

https://www.klimatupplysningen.se/2014/01/03/2013-aret-da-merchants-of-doom-framtradde-allt-tydligare/

”Men, jag ser framemot fler ledtrådar. Min mening är inte att döda nyfikenheten på klimatet utan att avdramatisera det.”

Detsamma för min del

Alienna #34

Kan vi här på bloggen tota ihop några frågor som vi kan skicka in ?

En lägre klimatkänslighet är inte detsamma som en låg.

1,8 C är fortfarande katastrofalt mycket, en temperaturstegring från 1900-talets början om nära 3 C vid en koldioxidfördubbling från idag.

Men visst är det bra om ,klimatkänsligheten är lägre, det skapa större utrymme för forskning och utveckling.

Intressant att konstatera är emellertid hur tom förenklade klimatmodeller kan få komma till användning bara de resultat man uppnår pekar åt önskat håll.

#38 Denna länken bör du nog läsa:

http://notrickszone.com/2014/10/30/more-glacier-studies-confirm-roman-and-medieval-warm-periods-were-just-as-warm-as-today/

Vi tror att vi är unikt drabbade av klimatförändringar-varför blev det så?

#37 Jag slängde iväg två frågor. Bägge baserade på de mycket intelligenta frågorna som finns i APS genomgång av den senaste IPCC-rapporten:

http://www.aps.org/policy/statements/upload/climate-review-framing.pdf

Det går liksom inte att slingra sig ur dessa frågor eftersom de direkt är härledda ur (dåligt underbyggda) påståenden i IPCC-rapporten.

Mina frågor var om den påstådda projicerade havsnivåhöjningen i IPCC-rapporten som ger rent absurda

resultat för slutet av detta århundrade med en plötslig stigning om 14 mm/år samt hur ”bevisen” för ”missing heat” egentligen ser ut. Speciellt vad gäller tillgängliga observationer.

Peter,

Jag vet inte hur det skulle gå till… Tänker mig att det är smidigast att var och en som vill fråga ”experterna” någonting, själv postar sin fråga.

Jag har t.ex. frågat dem VAD en klimatexpert är för någonting. Dom borde ju veta skillnaden mellan en expert och en allmänt klimathotstroende lekman…

#41 Alienna

Det viktiga är att ALLA här skickar frågor. Sedan kan vi summera hur många som kom fram.

Jag tror inte många kommer genom censuren. Därför tyckte jag att det kunde vara en idé att tillsammans formulera nåt klurigt. Själv har jag inget bra förslag, men det finns ju kunnande här.

Pehr & Mats #28

Jag har inte läst artikeln , men jag undrar ungefär som Mats hur de kan hantera alla andra naturliga faktorer som styr klimatet?

Det är ett generellt problem att sortera bort dessa naturliga källor till variationer, innan man kan påstå att temperaturökningen beror just på (antropogen) CO2. IPCC har gjort det mycket slarvigt, genom att för det första kalla allting ”antropogent”, och sedan påstå att variationer i solens instrålning saknar betydelse, och därefter erkänna att molnbildning och molnigheten den är svår att ha koll på. Och så hamnar man på en hög och osäker klimarkänslighet.

Harde försöker åtminstone inkludera solen och molnen och får avsevärda bidrag från båda dessa.

/C-G

Tyvärr har den här studien samma svaghet som i stort sett alla försök att bestämma klimatkäänsligheten med Bayes-metodik, nämligen en fysiskt orimlig (platt) prior:

”The ECS is given a vague prior, uniform [0, 20] ◦ C”

Resultatet blir en utdragen högersvans med mycket hög klimatkänslighet i sannolikhetsfunktionen i stort sett vad än mätvärdena visar på. För att illustrera hur orimlig priorn är så innebär den t ex att sannolikheten för att ECS är > 15 grader är nästan dubbelt så stor som att den är < 3 grader. Om ECS vore ens i närheten av 15 grader så skulle det växa dadelpalmer i Sverige vid det här laget.

Problemet är att ingen ännu har lyckats hitta en vettig metodik för att använda Bayes-statistik i fall där värdet på den sökta variabeln är både dåligt känd och ett kontinuum.

36

Pehr Björnbom

”klimatet ändrar sig så långsamt.”

Jo som vetenskaps man så är det en nackdel men som inneboende på Jorden så är det en fördel. Det innebär att vi hinner anpassa oss vilket människan fö är mästare på. Det innebär också att de utjämnande effekterna har god tid på sig att samla kraft och gå till motattack. Summa summarum. All is well.

Namnet Markku Rummukainen känner jag igen… Så här kommenterade jag ett av hans inlägg hos miljödepartementet:

”Ja, det krävs en massa jobb för att allmänheten inte skall märka det uppenbara.

Kunskap om hur klimatet fungerar finns inte – är ickeexisterande – totalt frånvarande – ingen har den blekaste aning.

Det faktumet undviker man mycket noggrant.

Och vad politikerna säger att IPCC säger – är inte detsamma som det IPCC säger.

För att nu inte tala om vad massmedia, i sin tur, säger att IPCC säger efter att ha lyssnat på vad politiker säger att IPCC säger att ”forskare” säger…

Det existerar inte ens ett endaste vetenskapligt belägg som styrker AGW-hypotesen.

Hela ‘klimatfrågan’ är 100% politik. Det har ingenting med verkligheten eller naturvetenskap att göra.”

(Den kommentaren försvann, med en massa andra kommentarer, efter en vecka … Kommentarer som är i strid mot Den Rätta Tron, passar sig inte i ett sådant departement.)

http://www.themoscowtimes.com/news/article/russia-could-be-facing-35-year-cold-weather-spell-scientist-says/510285.html

Apropå måndagens SMHI batalj. Vem har tid egentligen att chatta eller följa en chat en måndag förmiddag?

Lbt #38,

”1,8 C är fortfarande katastrofalt mycket, en temperaturstegring från 1900-talets början om nära 3 C vid en koldioxidfördubbling från idag.”

Det du säger här står i bjärt kontrast till vad Kerry Emanuel säger i samtalet med John Christy. Se länkar ovan. Kerry Emanuel menar att ett värde i lägre delen av IPCCs intervall (1,5-4,5 C) inte leder till några stora problem och att de flesta av hans klimatvetenskapliga kollegor delar denna hans åsikt.

”Intressant att konstatera är emellertid hur tom förenklade klimatmodeller kan få komma till användning bara de resultat man uppnår pekar åt önskat håll.”

Denna din ironi är något av ett slag i luften om man tar hänsyn vem en av författarna, nämligen Gunnar Myhre är, dvs. hans ställning som koordinerande ledande författare för den senaste vetenskapliga rapporten från FNs klimatpanel IPCC:

http://www.climatechange2013.org/contributors/chapter/chapter-8

C-G #43,

Som jag förstår dessa saker så får man se det som ett antagande att interna variationer utjämnar varandra under den studerade perioden. Modellen kan ju inte beskriva några interna variationer.

Dessutom får man också se det som antaganden, som kommer från de data för ”radiative forcing” som de använder, att det inte finns några indirekta effekter från solen. Vidare får man se det som ett antagande att förändringar i molnigheten inte ger upphov till något bidrag till ”radiative forcing” utan att molnen bara kan bidra till återkopplingar.

Om molnen skulle ha gett upphov till positiv ”radiative forcing” så under den studerade perioden skulle klimatkänsligheten bli lägre och vice versa.

Jag har inte hunnit med Hardes artikel ännu men kanske är det sådana saker som han tagit med i analysen.

LBt #38

Lugna ned dig litet. Valet av prior innebär att medelvärdet 1,8 grader med säkerhet är för högt relativt verkliga mätdata (vilket indirekt medges i sektion 4.4 och 4.6 i artikeln).

tty #44,

Faktum är att även om det finns en utdragen högersvans också i denna studie så går svansen ovanligt snabbt mot noll. Sannolikheten för att ECS är större än 3,2 C är som framgår av blogginlägget 5 %. Sannolikheten för att ECS är större än 4,5 C är endast 1,4 %.

Enligt IPCC är sannolikheten för att ECS är större än 4,5 C upp till 17 %, dvs. en storleksordning större än vad man kommit fram till i den aktuella studien.

Föreningen VIT har skickat följande fråga

http://www.tjust.com/vit/2014/1000000000.rtf

Pehr Tänk på att IPCC sammanväger ett flertal olika studier och man kan inte bara jämföra en enstaka studie med en sammanvägning av en hel massa andra.

Kampen mot vindkraften kan faktiskt skörda framgångar! Följ kampen på http://www.friavindar.se

Thomas #53,

Att jämföra med IPCCs intervall anser jag däremot är rimligt, vad skall man annars jämföra med, speciellt som det här gäller en ny studie som inte omfattas av IPCCs senaste sammanvägning. Publiceringshistorien är följande:

”Received: 25 June 2013 – Published in Earth Syst. Dynam. Discuss.: 14 August 2013

Revised: 4 December 2013 – Accepted: 9 February 2014 – Published: 25 March 2014”

Det har ju för övrigt också från klimatforskarhåll framförts kritik mot att man inom IPCC skulle ha varit alltför restriktiva med att minska på den övre gränsen i intervallet 1,5-4,5 C. Men det finns naturligtvis andra klimatforskare som inte håller med om denna kritik.

Angående Thomas P s sista kommentar!

Forskningen går framåt …. Femton av de sjutton senaste publicerade artiklarna om ”klimatkänsligheten” har avsevärt lägre klimatkänslighet än vad politbyrån IPCC ”sammanställt”.

Observationerna talar sitt tydliga språk och det är dags att sätta upp skylten ”RIP” över IPCC. Det är väl bara vetenskräpsredaktionen tillsammans med WWF och Grinpiss som försöker skaka på liket och låtsas att det lever.

Nimbus bilder på polarisarna från 1964 Recovering the past:

https://www.youtube.com/watch?v=bvGIE1y3cXA

tty #44

Tack för att du hjälper mig att vara fortsatt skeptisk till bayesiansk statistik, där priorn är en gissning som inte bygger på någon kunskaps- eller erfarenhetsgrund.

Men den duger gott för att befästa en tro för dem söker saligheten.

Trots allt är det kanske ändå så att klimatforskningen steg för steg håller på att fjärma sig från IPCC:s projektioner. Jag hoppas på det och att uttrycket ”värre än vi trodde” får en helt omvänd betydelse.

OT

CFACT

intervju med astronaut Walt Cunningham (ABC)

http://www.cfact.org/2014/10/31/watch-apollo-astronaut-walt-cunningham-blast-global-warming/

Pehr!

Jag är precis lika skeptisk som Slabadang (# 12).

Hela ide’n med att använda sig av

”radiative forcing- modellering” känns

väldigt primitivt och som jag starkt ifrågasätter.

Normalt brukar Jonas N tydliggöra bristerna i den här

typen av modeller så jag kan egentligen nöja mig med att

hänvisa till något av hans intressanta inlägg genom åren.

Helt kort menar jag att en modell som förefaller

ha en tidenhet som är på ett år, som förefaller

i princip vara linjär utgående från någon slags

jämvikts punkt och som inte tar hänsyn till

moln är en oerhört förenklad

modell. Den är på nivå examensarbete

i statistik. Tillför menar jag ingenting till

klimatvetenskapen.

Jag har inte heller läst artikeln, utan grundar min

uppfattning på lång erfarenhet av matematisk modellering

och av att värdera matematiska modeller.

Mitt råd Pehr är : Försök inte att förstå – det finns

ingenting att förstå. Parameteranpassning med hjälp av

statistik till en sån här modell säger ingenting

om klimatkänsligheten.

Vi kommentatorer som följer denna blogg

och som ser den här typen av uppsatser

säger väsentligen alla samma sak: Qvasivetenskap.

Avlsutningsvis. Kul att Du hänvisar till en

workshop på Isaac Newton Institute. Det var när jag såg

och läste om temperaturkurvorna som fanns i den

”fyrspaltare” som gjorde reklam för workshopen,

som min misstro gentemot klimatvetenskapens

temperaturprognoser startade och grundlades.

Din rapportering om norrmännens rapport

har bara förstärkt denna misstro.

Thomas Kaijser

OT Enligt SVT:s Rapport så är fossila bränslen på väg att bli värdelösa eftersom ingen vill investera i dem.

#58

Att påstå att en prior är ”en gissning som inte bygger på någon kunskaps- eller erfarenhetsgrund” är vilseledande. En prior ska spegla den bakgrundsinformation I som problemformuleringen baseras på: P(a|d,I)=P(a|I)P(d|a,I)/P(d|I) där d är data och a parameternav intresse. Priorn kan vara vag eller specifik, men den bör komma från logisk analys av problemet snarare än gissning (se’n står det ju var och en fritt att räkna på vilka förutsättningar den vill, men man bör redovisa hur man kommit fram till sin prior eller visa att den inte påverkar slutsatserna).

Lite vid sidan av ämnet:

I min mening är den framlidne fysikern Edwin Jaynes den okrönte kungen i ämnet sannolikhet, priors och beslutsteori. Läs hans bok Probability Theory, The Logic of Science om ni är intresserade av en uppgörelse med många ”klassiska” statistikmetoder och verkligen vill lära er Bayesiska metoder. Som bonus avmystifieras entropi och termodynamikens andra huvudsats genom en genomsund användning av sannolikheter. För artiklar: bayes.wustl.edu

#59 Ingvar

En astronaut till, Buzz Aldrin.

” I’m sceptical humans are causing global warming. More research and less politics is needed.”

http://www.dailymail.co.uk/sciencetech/article-2814701/I-sceptical-humans-causing-global-warming-says-Buzz-Aldrin-thinks-people-sent-DIE-Mars.html#ixzz3Hio5dP8k%20

ErikB #62,

Tack för intressant kommentar och boktips!

Jag upplever problem med att få en vettig betydelse av sannolikhet i till exempel den prior som använts för klimatkänsligheten i studien. Alla värden i intervallet 0-20 C skall ha samma sannolikhet och alla värden utanför har sannolikheten noll. Sannolikheten för att klimatkänsligheten enligt priorn ligger i intervallet 0-5 C är alltså 25 %. Men vad betyder detta påstående egentligen?

Jag har hittat följande webbsida där ett par bokkapitel kan läsas som ger grunder i ämnet. Men jag har inte hittat svar på frågan där.

http://bayesmodels.com/

Det kvittar hur man än vrider å vänder på det, det finns ingen så kallad klimatexpert i dagens läge som verkligen vet hur denna planets klimat fungerar !

Fast Lbt å TP kanske kan peka ut nån som vet ?

Ska man göra en modell av något som man inte vet hur det fungerar så kan vi lika gärna vända oss till shamaner och diverse spågummor/gubbar som de gjorde förr i tiden.

Och det skall vi bygga en framtida politik på ??

Jösses !

ThomasP #53

”Tänk på att IPCC sammanväger ett flertal olika studier och man kan inte bara jämföra en enstaka studie med en sammanvägning av en hel massa andra.”

Och IPCC förvrängde i AR4 dessutom resultatet av de studier som inte passade genom att ”homogenisera” dem med en absurd Bayes-prior.

ErikB #62

Att påstå att en prior är ”en gissning Att påstå att en prior är ”en gissning som inte bygger på någon kunskaps- eller erfarenhetsgrund” är vilseledande

En prior ska inte vara en gissning som inte bygger på någon kunskaps- eller erfarenhetsgrund men inom klimatvetenskapen är den ofta just det. Eller kanske snarare en ´gissning´ som strider mot all kunskaps- och erfarenhetsgrund. Som t ex i det aktuella fallet med en platt prior (0, 20) grader K. Eller anser du verkligen att det är rimligt att anta 50 % sannoilikhet för att ECS > 10 grader?

Jag vet att det för många är som att svära i kyrkan att ifrågasätta Bayes-statistik, men jag vill nog påstå att möjligheten att ”fixa” resultatet genom ett kreativt val av prior i många fall är anledningen till att den används. Det är fortfarande rätt fås som vet tillräckligt mycket i ämnet för att genomskåda dylika trick (och jag har f ö sett vetenskapliga artiklar där manm inte ens redovisat vilken prior man använt).

Pekke #65

”Ska man göra en modell av något som man inte vet hur det fungerar så kan vi lika gärna vända oss till shamaner och diverse spågummor/gubbar som de gjorde förr i tiden.”

Inte helt sant. Om man känner till alla relevanta variabler utom en eller ett par så kan en matematisk modell vara mycket användbar för att få fram det troligaste värdet eller värdena, eller åtminstone göra en känslighetsanalys av vad effekterna av olika värden på de okända variablerna blir. Problemet är att beräkningsvolymerna växer på ett totalt ohanterligt sätt med flera osäkra variabler, det vet jag inte minst genom personlig erfarenhet. Att hantera dussintals variabler som är osäkra och/eller inte kan beräknas explicit utan måste parametriseras håller jag däremot med om ligger på häxdoktor-nivå.

#64

Eftersom jag varken läst artikeln i fråga eller särskilt mycket om klimatkänslighet överhuvudtaget så borde jag väl inte säga för mycket om den specifika priorn, men jag tycker den verkar lite märklig med sina absoluta gränser. Generellt för sannolikheter brukar jag dock se dem som grader av implikation: till vilken grad implicerar den information vi har ett visst utfall (sannolikhetsläran kan härledas som en utvidgning av tvåvärd ”vanlig” logik till att täcka spannet mellan implikation av sant och implikation av falskt). Den är alltså en produkt av den information som ”tagits med i beräkningen”, inte en fysikalisk storhet som kan mätas upp (i den logiska tolkningen). Om vi låtsas att den aktuella priorn är korrekt/vettig/välmotiverad så skulle min tolkning vara: 1) något i bakgrundsinformation utesluter klimatkänsligheter >20 grader och <0 grader 2) i övrigt kan inte bakgrundsinformationen säga något om känsligheterna i intervallet (i mina ögon en märklig prior som verkar ansatt utan någon djupare analys, men jag kan som sagt inte avfärda den helt utan att läsa artikeln).

#67

Allt kan missbrukas, inte minst statistik som bekant. Bayesisk sådan inget undantag, och om folk vill använda priorn som en fixarratt är det inget jag stödjer. Ifrågasättande är alltid bra om det motiveras. En sak jag gillar med Jaynes "version" är att han trycker på att alla sannolikheter är betingade — vi bygger alltid vår analys på någon bakgrundskunskap — och man ska vara noga med att redovisa denna och hur man därifrån kommer till sina sannolikheter. Då kan man alltid diskutera/kritisera det väsentliga istället för priorns form: vilka antaganden bygger analysen på. Spontant, nej det verkar inte alls rimligt att intervallet [15,20] är lika sannolikt som [0,5].

I övrigt kan sägas att Jaynes var en sann skeptiker i den goda betydelsen och borde uppskattas av folk här

#68

Det hela handlar väl om antalet obestämda parametrar (och deras inbördes beroenden) i relation till mängden tillgänglig information (typiskt mängden relevant data). Inom t.ex. marin seismik bestäms tusentals obekanta i bottensedimenten tillräckligt bra för kunna avgöra var man ska borra efter olja (inte för att man prickar rätt jämt, men ändå). Vad jag antar är problemet i klimatmodellerna — jag ska återigen betona att jag inte är djupt påläst och därför ägnar mig åt halvspekulation — är en relativ brist på data (eller kanske brist på kvalitetsdata) i förhållande till det komplexa system med massor av obekanta och osäkerheter som man försöker säga något om. Sedan är det gissningsvis inget lätt fråga hur mycket man kan förenkla modellerna för att minska antalet okända innan approximationsfelet överstiger vinsten av förenklingen.

ErikB #69,

Jag läste lite i Jaynes bok, de kapitel som finns på webben via din länk, men det är en hel del att tränga in i med Boolesk algebra och annat för att få grepp om sannolikhetsbegreppet i detta sammanhang. Jag får associationer till vågfunktionen i kvantmekaniken, sannolikheten är en användbar storhet för att göra analyser med hjälp av men det är svårt att förstå vad den betyder i sig.

Det var intressant att både du och tty finner klimatkänslighetsstudiens val av prior märkligt. Efter vad ni säger så kan man undra varför de inte har använt FNs klimatpanels rapport från 2007 för att konstruera en prior. Detta är ju en information som faktiskt finns och mot bakgrunden av denna så är sannolikheterna för värden runt 3 C mycket större än för värden omkring 10 C till exempel. Den prior de har använt står uppenbarligen i motsats till detta.

Så där har vi något skeptiskt som vi kanske borde kunna enas om

Jag litar inte på så kallade ” Experter ” efter egna erfarenheter som driftoperatör, som operatör så ställer man in diverse driftdata efter vad slutproduktens värden har och inte efter vad de teoretiska värdena borde vara.

Som driftoperatör som jag är måste jag se till vilka värden min slutprodukt ger och kalibrera mina driftvärden så att jag får den slutprodukten som min arbetsgivare och kund vill ha, jag kan icke ställa in teoretiska värde och tro det fungerar, det brukar inte göra det !

Fast en del tror att teori å praktik är samma sak.

pekke-du skrev-detta skall vi bygga framtidens politik på.

Just nu i min kommun bygger man vallar anpassade för IPCC värsta tänkbara scenario.

Det är på allvar och måste förhindras genom en saklig upplysningsdiskusion!

Kajkrön över +2 m utmed en torr strandremsa!!

Lst och SMHI gör detta tyvärr omöjligt.

Idag 20 miljoner slängda i sjön!

Även Slussen byggs om för framtida flöden!

Där finns dock en Plan B som kan förhindra en 20 årig ombyggnadsperiod!

Pehr och Björn!

Det finns en mycket viktig ingrediens som handlar om beteendevetenskap och inte naturvetenskap. Vem ställer sig frågan om det överhuvudtaget går att beräkna ”klimatkänsligheten” med mänskligt CO2 som utgångspunkt? Jag hävdar att alla naturvetare som jobbar med modeller får ett kärleksförhållande till alla faktorer som är mätbara och säkra. Det blir till den ”ordning och reda” som gäller för den matematik de vill och måste få att gå ihop. När de sedan skall sätta in dessa ”säkra” observationer i sitt stokastiska verkliga sammanhang så övergår matematiken lätt till att bli astrologi när de skall bedöma ”sannolikheter” och sannolikheten för att de har formulerat rätt formel dvs rätt ”modell” blir för oss att gissa oss till. Sannolikheter för VAD?

Vad jag ser som ett bevis på att man använder fel formel är att resultaten av formeln förändras efter temperaturobservationerna som nu vartefter sänker ”klimatkänsligheten” för CO2. Det blir ett självbedrägeri där curvfittingen av CO2s effekt blir justerad vartefter och detta utan att ifrågasätta formlerna i sig och huruvida de överhuvudtaget går att beräkna klimatkänsligheten för CO2 i sitt stokastiska sammanhang. Konsekvensen blir att man alltid tillskriver CO2 en viss konstant betydelse/faktor/effekt som till och med kan växla tecken trots att den konstant ökar linjärt. Vad som kännetecknar den här typen av modeller är att de fortsätter att räkna och spekulera framåt tills någon till slut tar initiativet och skrapar bort dem från kakelväggen.

Uppfinningsrikedomen att hitta argument för varför modellen ”borde räkna rätt” är bottenlös. Däremot är samma rikedom förvandlad till större fattigdom när de skall kvantifiera vad de INTE VET … det blir kaklet i väggen som stoppar till slut för det finns INGEN FUNGERANDE VALIDERING av modellen i sig och vad som var ett ”mission impossible” redan från början bevisar sig till slut att just det.

Så min observation och erfarenhet är att tillskriva CO2s påverkan av klimatkänsligheten till NOLL då andra större faktorer uppenbarligen styr temperaturvariationerna i större utsträckning än CO2 och vi kan med mycket stor sannolikhet anta att osäkerheten i antalet större kända och antalet och storleken av okända faktorer helt och hållet dränker ”CO2 effekten” i den utredning av ”klimatkänsligheten” som nu sysselsätter så många. Har du väl ställt fel fråga från början så sitter skägget där på sin plats i brevlådan liksom. När man inte visste vad som styr naturliga klimatförändringar … hur kan man då förvänta sig svaret på hur mänsklig CO2 skulle påverka dem … och varför antog man på förhand att den hade betydelse?

Vetenskapliga skägg som sitter i brevlådan avlägsnas bäst med hjälp av Occams rakkniv ?

pekke #72

Tack för en mycket relevant kommentar.

Den visar på tre rader hur oklokt det var att skriva under klimatkonventionen som stipulerar att människans utsläpp av växthusgaser styr jordens medeltemperatur. Den uteblivna uppvärmningen, trots fortsatt ökande utsläpp, visar att grundantagandet är fel.

Slabadang [74]; Så sant, så sant!

Pehr B #48,

Vi talar om en temperaturstegring från 1900-talets början om nära 3 C vid en koldioxidfördubbling från nu. Skulle en sådan påverkan på begränsad tid vara försumbar när den totala temperatursvängningen sett över hela den mer än 100000-åriga klimatcykeln är blott ca 5 C? Påståendet är ju barra löjligt, det är en sanslöst stor påverkan vars konsekvenser vi inte har en aning om.

Ironi? Jag avskriver inte datorsimuleringarna vare sig i det här sammanhanget eller i andra det är ni som väljer och vrakar efter egna drömmar. För övrigt menar jag att de försök till klimatkänslighetsvärderingar som vi än så länge sett är mycket grova förenklingar som om vi flyttar dem 50 år framåt i tiden sannolikt då ger ett helt annat utfall.

LBt, räknar de flesta inte på en CO2-fördubbling sedan industrialiseringen, samma tidpunkt som den globala temperaturen jämförs med? Alltså ca 1850-60. Vi har då på dessa 150 år uppskattat att temperaturen ökat med nära 0,8 grader varav möjligen hälften kan vara kopplat till våra CO2-utsläpp. Låter det sanslöst mycket?

Det finns dom som är rädda att syrenivåerna i atmosfären sjunker och det enda säkra sättet att öka syreproduktionen är att släppa ut mer CO2 så att framförallt algerna i haven växer till fortare. Alger är dessutom sannolikt nyckeln till framtidens energibehov. Jag tror att CO2 gör betydligt mer nytta än skada.

L #78 ”Det finns dom som är rädda att syrenivåerna i atmosfären sjunker och det enda säkra sättet att öka syreproduktionen är att släppa ut mer CO2 så att framförallt algerna i haven växer till fortare. ”

Ja, syrehalten sjunker även om jag aldrig träffat någon som är rädd för det. Anledningen till att halten sjunker är att vi förbränner fossila bränslen vilket förbrukar syre (livets gas?) och omvandlar det till koldioxid och vatten. Hur tänkte du dig att spä på med CO2 på ett sätt som inte förbrukar syre, om det nu är ditt problem för dagen, i motsats till en kommande istid som du oroade dig för nyss.

#79, jag förstår att du aldrig träffat någon som är orolig för sjunkande syrehalt, du sitter ju klistrad framför datorn dygnet runt. Och i motsats till politikerna räknar jag in all koldioxid som nyttig, även den fossila.

L #80 Du förstår alltså inte det där med masskonservering? Om du förbrukar syre för att framställa CO2 kan fotosyntesen som bäst återställa syrehalten om all denna CO2 omvandlas till kol i växter och syrgas, men som vi vet sker inte det utan bara typ en fjärdedel tas upp via fotosyntes. Därför sjunker syrehalten. Ditt tal om ” det enda säkra sättet att öka syreproduktionen är att släppa ut mer CO2 så att framförallt algerna i haven växer till fortare. ” är nonsens.

#81, så enligt dig är vi inne i en dödsspiral hur vi än gör?

Thomas P [81]; Ökad CO2-emission leder väl till ökad fotosyntes och därmed ökad produktion av syre? Det är bara att elda och gasa på!

I #82 ” så enligt dig är vi inne i en dödsspiral hur vi än gör?”

Eh? Nej.

Björn #83 ”Ökad CO2-emission leder väl till ökad fotosyntes och därmed ökad produktion av syre? ”

Men är verkligen grundskolekemi så förbannat svårt? Läs mitt #81en gång till och skäms!

Thomas P [84]; I den kända formeln för fotosyntes, 6CO2 + 6H2O + hν → C6H12O6 + 6O2, bildas sex syremolekyler och vad är problemet? Om antalet växter ökar måste väl antalet reaktioner öka och därmed antalet syremolekyler?

Björn #85 Och var kommer CO2 ifrån tror du? Kan du den reaktionen också?

L #78,

jag har noga redovisat mina utgångspunkter, en koldioxidfördubbling från nu och en temperaturstegring om nästan 3 C från 1900-talets början.

Tydligt eller hur och inte särskilt bra.

#87, du säger att ”vi” talar om det, men det är väl bara du som har de utgångspunkterna?

Angående diskussionen här om man kan få mer syre i atmosfären genom koldioxidemissionerna.

Thomas har rätt denna gång att den mängd syre som går åt för att förbränna alla fossila bränslen är enormt liten jämfört med den mängd syre som finns i atmosfären. Så man behöver inte oroa sig för syrebrist av denna anledning.

Han har också rätt i att man teoretiskt inte kan öka syrehalten genom att förbränna fossila bränslen även om den utsläppta koldioxiden bildar syre genom fotosyntes. Detta beror på att innan vi kan släppa ut en koldioxidmolekyl så måste vi förbruka syremolekyler i förbränningen. Vi kan med fotosyntesen teoretiskt inte få tillbaka mer än de syremolekyler som vi har förbrukat. Följden blir att om vi vill öka syrehalten i luften genom fotosyntesen jämfört med vad den är idag så måste vi minska koldioxidhalten i luften jämfört med vad den är idag.

Det är inte ens så att vi alltid får tillbaka allt syret även om all koldioxid som släpps ut deltar i fotonsyntesen och därmed bildar nytt syre. Om vi till exempel förbränner bensin så får vi minskning av syre i atmosfären även om alla koldioxidmolekyler deltar i fotosyntesen efteråt.

Förbränning av bensin kan beskrivas ungfärligt med följande kemiska formel

2 C8H18 + 25 O2 → 16 CO2 + 18 H2O

När vi förbränner bensin går det alltså åt 25/16 = 1,56 syremolekyler för varje koldioxidmolekyl som bildas.

Fotosyntesen kan beskrivas med följande formel:

6 H2O + 6 CO2 + ljusenergi → C6H12O6 (druvsocker) + 6 O2

När koldioxidmolekylen sedan deltar i fotosyntesen får vi alltså bara tillbaka en syremolekyl per koldioxidmolekyl.

Alltså 0,56 av de 1,56 syremolekyler per koldioxidmolekyl som gick åt för att förbränna bensin kommer inte tillbaka vid fotosyntesen.

Slabadang #74,

”Vem ställer sig frågan om det överhuvudtaget går att beräkna ”klimatkänsligheten” med mänskligt CO2 som utgångspunkt?”

I den studie som jag diskuterar här har man inte haft mänskligt CO2 som utgångspunkt utan har helt enkelt utgått från koldioxidhalten i atmosfären som en av de faktorer som påverkar jordens energibalans. Koldioxidhalten har ju mätts upp under många år och man har också tagit hänsyn till hur andra gaser vars halter mätts upp påverkar strålningsbalansen såsom metan och dikväveoxid. Men man tar också hänsyn till att solens variation påverkar strålningsbalansen och att aerosoler också gör det, både sådana som kommer från förbränning men också sådana som kommer från vulkanutbrott.

Om vi till exempel antar att Murry Salbys paradox skulle vara sann så att ökningen av koldioxid inte alls beror på människan så skulle detta ändå inte förändra förutsättningarna för denna studie det minsta. Ur studiens synpunkt är det helt egalt vad den ökade koldioxidhalten beror på.

”Jag hävdar att alla naturvetare som jobbar med modeller får ett kärleksförhållande till alla faktorer som är mätbara och säkra.”

Det kan jag hålla med om men många naturvetare som jobbar med modeller är medvetna om detta och har den självkännedom som krävs för att hålla huvudet kallt. Det finns ju väldigt många goda exempel inom naturvetenskap och teknik på hur man med matematiska modeller kan lösa problem på ett effektivt sätt, men i de flesta fall blir det effektivt genom att det är ett samspel mellan matematisk-numerisk modellering och experiment i laboratoriet.

”Vad jag ser som ett bevis på att man använder fel formel är att resultaten av formeln förändras efter temperaturobservationerna som nu vartefter sänker ”klimatkänsligheten” för CO2.”

Så tolkar jag inte vad man funnit i den här studien. Resultatet av den här studien är ett osäkerhetsintervall. Vad de såg är att osäkerhetsintervallet blev kortare när nya mer noggranna resultat tillkom. Att modellen har ett systematiska fel kan man utgå ifrån med vissa effekter som de du beskriver, det är en enkel modell av ett mycket komplicerat system, men det var framförallt den övre gränsen i osäkerhetsintervallet som flyttades ner. Detta ser jag som ett gott tecken.

”…det finns INGEN FUNGERANDE VALIDERING av modellen i sig….”

Där håller jag inte med eftersom vi här talar om en enkel modell med få parametrar. Då är situationen en annan än med de enorma avancerade klimatmodellerna där det finns principiella svårigheter på grund av komplexitetsparadoxen:

https://www.klimatupplysningen.se/2013/08/02/sommarrepris-varfor-kan-klimatmodellerna-inte-forutsaga-klimatets-utveckling/

Sedan är det fortfarande så att jordsystemet är stort och klimatet ändrar sig långsamt. Därför har vi för lång tid framåt alltför lite observationer av jordsystemet och klimatet för att kunna använda modellerna på ett tillräckligt bra sätt, och detta gäller både enkla och komplicerade modeller.

Jag anser som jag har gjort hela tiden, precis som de andra skribenterna här på Klimatupplysningen, att man inte kan komma förbi att jordens energibalans påverkas av ändrad sammansättning av atmosfären och att detta leder till temperaturändringar. Ökade halter av koldioxid och andra andra gaser som kan absorbera och emittera infraröd strålning måste därför påverka jordens strålningsbalans och detta leder till ökad global temperatur. Detta är väl accepterat av det flesta naturvetenskapliga forskare.

Det som diskussionen handlar om är inte detta utan om hur stor temperaturändring man kan få. Detta beror på de återkopplingar i klimatsystemet som den ändrade strålningsbalansen leder till. Och det just den frågan som den studie som jag diskuterat här försöker svara på, dvs. hur stor är klimatkänsligheten.

Den ändrade strålningsbalansen / Jordens energibalans / Rymdödlornas högkvarter / Växthusgaser /Globens innevånare / Växthusgaser som ”inte räknas som” växthusgaser / Modeller som kan spå framtiden / Klimatkänslighet / Andemedier / Tomtar & Troll / Konsensus…

Hypoteser och andra idéer/teorier presenteras som om det handlar om belagda vetenskapliga fakta.

Naturvetenskap verkar inte vara speciellt populärt inom Klimatreligionen.

Pehr B!

”Jag anser som jag har gjort hela tiden, precis som de andra skribenterna här på Klimatupplysningen, att man inte kan komma förbi att jordens energibalans påverkas av ändrad sammansättning av atmosfären och att detta leder till temperaturändringar. ”

Japp och inte ens jag hävdar motsatsen Pehr.. men vad inte du jag eller någon annan vet är vare sig tecken eller storlek i sitt större kaotiska klimatiska sammanhang. Jag tror helt enkelt att det är fel metod med en felaktig förväntan av vad svaret skulle innebära för GMT vilket utgör den stora frågan. Vad en liten förändring i sammansättningen av värmeabsorberande atmosfärsgaser gör för en lutande snurrande planet som inte är ett växthus eller en svart kropp, kommer den teoretiskt beräknade ”klimatkänsligheten” inte kunna ge svar på. Frågan är om ambitionen att räkna fram den är till hjälp eller mer stjälp för att hitta svaret och för att kunna skilja naturliga variationer från mänsklig påverkan.

Precis som jag hävdade i mitt inlägg …. ”Därför borde modellen räkna rätt” det är bland annat här som beteendevetenskapen sätter in och blir mycket förrädisk där vi får vara extremt noggranna med det exakta värdet av den modell vi räknat fram och hur vi kan tillåtas använda den och till vad. Teoretiskt kan den vara helt korrekt .. men hur var och när kan du tillämpa den?

Vad jag hävdar med bestämdhet är att man letar under samma och fel sten hela tiden. Hur validerar du svaret från modellen och vad annat än tempdata kan den valideras emot? När får du bekräftelse på att modellen är ”rätt” tillämpad på klimatet? Vi har endast instrumentdata sedan 1850 i runda slängar att utreda om, hur och i så fall hur mycket eller lite CO2 påverkat GMT. För tempdata så gäller ”its all in there” och antagandet att CO2 skall kunna avläsas i dessa är en hypotes inbyggd i CAGW-hypotesen och som genom sitt konstruerade begrepp ”klimatkänslighet” utgår ifrån att den skall vara så stor att den skall kunna mätas och fastställas. Det är smaschupplägg för sammanblandning av orsak och verkan och konfirmationssubjektivitet.

”its all in there” innebär att ALLA klimatfysikens komponenter lagar och dynamiska krafter i samverkan representeras i tempdata, vi kan vara helt säkra på att det existerar en hel flock med ”svarta svanar” vad gäller interaktionen och den verkliga växelverkan dem emellan. Resultatet av alla dessa kaotiska samspel skapar vad jag kallar våra naturliga klimatvariationer. Använder vi istället en helt vanlig uteslutningsmetod så hävdar jag att Tellus redan genomfört experimentet och konstaterat att med en till 75% (inkl CO2-ekvivalenter) redan uppfylld fördubbling av CO2 sedan 1850 så är det redan uteslutet att CO2 skulle kunna bidra med en större effekt på GMT än 1C. Skall man hävda något annat så blir det rena spekulationer om mystiska förstärkningeffekter som varit dolda tills nu men som skall poppa fram vad det lider.

Med kunskapen om att tempen stått stilla samtidigt som ökningen av CO2 varit som störst så mörknar himlen av den stora flock med svarta svanar som drar över ”klimatvetenskapen” och beräkningar av ”klimatkänsligheten”. Jag blir allt säkrare på att beräkningar av klimatkänsligheten är en återvändsgränd för att få svaret på hur mycket några PPM co2 till en fördubbling skulle påverka temperaturen. Det är mer som att försöka trä i nålen med grytvantarna på under färd på guppig skogsväg.

”Hiatusen” är en enkel del av den uteslutningsmetod vi istället kan fokusera på och se till att beräkningarna på skogsvägen håller sig inom 1C som fartbegränsning? Vad gäller återkopplingar … vad gör dig då säker på att inte återkopplingar kan ändra villkoren för strålningsbalansen -1,5 – +1,5 C? Blir det oordning på torpet om jag föreslår att klimatkänsligheten för växthusgaser är en variabel som styrs av variabla återkopplingar ? Vad är tex klimatkänsligheten för förändringar i det globala molntäcket? .. för havscirkulationen ? .. och trots dessa kaotiska återkopplingmekanismer har GMT inte förändras mer?

Så det föreligger helt horribla förväntningar på vad en teoretiskt beräknad klimatkänslighet skulle kunna användas till och vilka svar den skulle kunna ge. Osäkerhetsmonstret är verkligen gigantiskt och har av CAGW-kyrkan utnyttjats till sitt extrema maximum där monstrets storlek medvetet har förväxlats med klimatriskernas storlek. Ju mindre de vet ju mer har de pumpat upp alarmismen i osäkerhetsutrymmet. Observationer förvandlar monstret till storleken av en cockerspanielvalp !

Med facit i hand och ynka 0.8 C på 150 år så är det dags att ställa den nya frågan och byta ut begreppet klimatkänslighet mot klimattålighet och klimatstabilitet. Ingen förändring av stormar tornados, torkor,översvämningar, havsisar,glaciärer,havsnivåer mm …och ställa oss frågan varför förändras det globala klimatet så LITE på 150 år? Skall vi förklara klimatstabiliteten istället för känsligheten så hamnar vi med stöd av observationerna på rätt spår och fokuserar på modellernas nedre skalor och kopplar den till tåligheten istället för känsligheten och detta utan att få svar på vilka andra klimatstabiliserande dynamiska faktorer den samverkar med. Så utifrån vilken universell klimatbild och tolkning vi utgår ifrån avgör vilka frågor vi ställer och vilka svar vi söker.

Jag menar att den uppspelta teaterdramatiken om ” de stora klimatförändringar vi nu ser” blir totalt stendöd och pinsam när man väl läst in alla vitala klimatdata! Tvärtom påvisas en rent tråkig stabilitet och tålighet.

Slabadang # 92.

Återigen en helt makalöst bra kommentar. Vill bara instämma till fullo.

Litet av Dina tankegångar finns I min uppsats ” Värdering av komplex system”,

Kungl. Krigsetenskapsvetenskapskademiens Tidskrift och Handlingar, nr 3, 1993,

– en uppsats som jag flaggat för tidigare.

( Jag snuddar faktiskt vid koldioxiden och möjligheten eller snarare omöjligheten att

kvantifiera dess inverkan på klimatet.)

Jag trodde uppsatsen fanns på min hemsida på Linköpings Universitet, men ack… .

Jag ska fixa det under veckan.

Thomas Kaijser

Thomas Kaijser!

Jag vet inte om min erfarenhet av kraschade modeller gör att jag som inte är matematiker programmerare, tekniker eller specialist har tvingat mig att istället analyserar själva utvecklingsprocessen och beteenden. När man haft tillgång till den absoluta spetskompetensen i modellbyggandet och ändå vid upprepade tillfällen ”misslyckas” så är det inte specialistkompetensen som saknas utan det är enligt min mening brister i projektledning och brister i uppdragsformuleringen som fallerar. Hur beräknar man korrekt komplexiteten i ett system? Mitt svar är att du måste känna till ALLA faktorer i detta system för att kunna beräkna det och kunna fastställa volatilitet för att kunna tillföra något prognostiserande mervärde. Modellerna hade aldrig påbörjats om man utvärderat själva uppdraget seriöst från början och jag hävdar att gör du det i rätt ordning så är det där du skall lägga kostnaderna och fokus. Det blir betydligt billigare än att försöka dra i gång vad som är ett ”mission impossible” redan från start.

Här utgör enligt mina erfarenheter de omedvetna självbedrägerierna en helt egen industri. Jag uppfattades som ”motvals” när jag ställde lite djupare frågor om de ”faktorer” som användes och öppnade med frågorna falluckor för de ”data” och tankefigurer de använde. Jag förstod att många faktorer egentligen var bestående av myriader underliggande faktorer men som summerades till och brukades som EN faktor. Har du inte gjort denna grundliga analys av omfattningen på komplexiteten kommer du med säkerhet att sysselsätta en sjuherrans massa mycket kompetent folk men gå kort om en fungerande modell och bränna massor av kapital längs vägen. Det finns en mänsklig svaghet och läggning till att underskatta komplexitet och överskatta sin förmåga att beräkna den. Min erfarenhet säger att om du inte har en enkel modell som fungerar så hjälper inte utökad komplexitet av modellen dig framåt. Keep it simple! I Komplexa system är det en bedrift bara att vara bättre än slumpen. När jag nu bara förstått en bråkdel av komplexiteten inom klimatet och därigenom svårighetsgraden och sedan jämför med den noggranhet på 1/10 dels C till 1/1000 C de påstår sig kunna beräkna för framtiden …… ja du Thomas man kan skaka på huvudet för betydligt mindre?

Slabadang # 94.

Ja absolut. Jag skakar också bara på huvudet. Va f- n håller dom

på med.

(Jag kallade mig för Tompa I början här på KU – och ska jag inte

hamna I modereringskö så måste jag nog starta med Tompa).

Thomas Kaijser

Våra Klimatupplysningsvänner tompa. Slabadang och Alienna förefaller mig mena att de ökade växthusgaskoncentrationerna i atmosfären har omärkbar effekt på temperaturen eller att det inte finns något vetenskapligt stöd för hypotesen att växthusgaserna har orsakat en temperaturökning.

Jag anser däremot att det finns ett betydande vetenskapligt stöd för hypotesen att de ökade växthusgaserna med en låg klimatkänslighet har orsakat en temperaturhöjning sedan år 1850. Denna hypotes stöds också av flera nyutkomna artiklar om klimatkänsligheten av bland andra Lennart Bengtsson och Stephan Scwartz, av Nic Lewis och Judith Curry, samt den norska studien som diskuteras här. Jag skall ta upp detta i mitt blogginlägg på fredag.

Pehr # 96.

Jag kan bara tala för mig själv. Som vanligt blir jag litet lång.

Matematik och matematisk modellering kan vara bra stöd för att strukterara komplexa samband.

Men när verkligheten blir väldigt komplicerad så

menar jag att det är väsentligen meningslöst att

använda matematiskka modeller för kvantitativa

utsagor.

Matematiska modeller år analysverktyg och inte

”answering machines”.

Tyvärr drabbas människor ofta av det så kallade

”modelleringssyndromet”. Man blir förälskad i

sin modell.

Jag är verkligen inte expert på utstrålningsfysik. Tvärtom. Okunnig.

Så nu spekulerar jag.

1) Molnen förhindrar instrålning på

dagen ( speciellt mellan +- 30 latitud).

Molnen förhindrar utstrålning på natten och

det sker relativt likvärdigt runt helas klotet.

(Tror jag). (Ju kallare jordytan desto mer borde

moln dämpa utstrålning).

Var molnen uppträder borde därför ha betydelse.

Temperaturdämpande runt ekvatorn – temperaturhöjande för övrigt.

Sen finns det väl en daglig rytm i molnbildningen också.

Jag tror i alla fall att molnen är av icke försumbar betydelse för temperatur och klimat.

(Om jag fattat Slabadang rätt anser han att förståelse för deras inverkan är

och tillkomst är helt avgörande för att klimatmodeller ska over huvud

taget kunna användas för prognos – och jag är böjd att hålla med.)

Min bedömning är att man hanterar moln och

molnbildning i de globala klimatmodellerna på ett

mycket schablonmässigt sätt.

2) Senaste tiden har jag spekulerat i vindens

betydelse. Säg att vi har en ”konstant” vind över

jordytan med vindhastighet 10m/sek. (Det går ju inte att

fixa en sån vindrörölse – men låt oss bortse från det.)

Och säg att vi har en molnfri jord.

Blir utstrålningen nu märkbart lägre än om man haft en vindstilla jord?

Förmodligen försumbar skillnad.

’

Men har inte vind någon som helst betydelse för jorden medeltemperatur? För klimatet

självklart – men för utstrålning ( och instrålning)?

Och i värmeutbytet mellan hav och luft?

Och det finns mycket rörelseenergi I vinden men jämfört med havets

försumbar.

Förmodligen är vindhastighet en marginell faktor.

Utstrålning går kanske går rakt igenom vinden.

3) Gröna växter. Allt kretsar ring de gröna växterna.

De skapar mat genom att fånga upp koldioxid och de

bryts ner som föda åt oss eller insekter och då frigörs

koldioxid. Runt, runt, runt går koldioxiden.

Nu ökar mängden gröna växter på jordytan och

förmodligen också i havet. Hur mera gröna växter

påverkar globala temperaturen är svårt att fastställa.

Hur påverkade den stora avverkningen av skog i

de tropiska områdena under slutet av

förra århundrat klimatet och den globala temperaturen?

Indiens temepratur har gått upp har man sagt mig men träden

har också fällts på landsbygden I Indien. Lokal klimat

förändring blir det nästan alltid när man avverkar skog.

Det finns massor med obesvarade frågor. Att då

börja prata om konfidensintervall för koldioxiden

känns väldigt ovetenskapligt. Det påminner om

operationsanalys i försvarsforskningen där militären

vill ha ett värde på ”pKill”.

Jag tycker det är dålig vetenskap. Så enkelt är det.

Alla storheter hänger ihop och då blir den här

typen av siffror ganska meningslösa.

Nu har vi haft 17 års utan uppvärmning.

Det förefaller synnerligen osannolikt att en

värmekatastrof är på gång.

Och att modellerna måste ifrågasättas är väl klart.

Och jag vidhåller, – norrmännens artikel ger inget

nytt. Förutom att möjligen det finns människor bland

de klimathotstroende som inser att skattningarna

rörande koldioxidens inverkan varit överskattande.

Men det har ju alla med litet erfarenhet av matematisk

modellering insett sen länge. Och bevisvärdet hos

deras modell menar jag är väsentligen noll.

Grundmodellen är för grov och systemet alltför

ostationärt för att det ska bli

meningsfullt att tala om konfidensintervall.

—

Vad ska politikerna göra? Tror flertalet

av klimatforskarna att koldioxiden kan orsaka

kraftig global uppvärmning finns det väl skäl att

försöka vidtaga åtgärder som minskar

mänskliga utsläpp av koldioxid – inte bara

fossila.

Nu har det gått 17 år utan uppvärmning. Det borde

ha medfört att klimatforskarna

vågat erkänna att deras prognoser

var fel. Tyvärr har det än så länge inte blivit

så och det är en skam för klimatvenskapen och

vetenskapen. Men vi kan ju hoppas. Snart

kanske man väljer att också lyssna på dom som

ifrågasatte prognoserna och som menade att det

var dåligt underbyggda prognoser.

Thomas Kaijser

[…] mitt blogginlägg förra fredagen, Norsk forskargrupp fick klimatkänslighet (ECS) mellan 0,9 och 3,2 grader C, diskuterade jag den studie som Skeie et al. (2014) gjort som är ett ytterligare belägg för […]